如果你觉得 opencll 有 点重,那 zerocll 基本就是它的反面。这是一个用 rasp 重写的 opencll, 体积多大?三兆字节,二进置文件启动速度几乎秒开, 对比一下,典型的 note g s 进程,动不动就是四百兆字节内存常驻。 zerocll 的 思路很简单,把能跑变成跑得轻,跑得稳。

粉丝2048获赞1.6万

相关视频

02:54查看AI文稿AI文稿

02:54查看AI文稿AI文稿更清亮的 zero claw 来了,但是现在不建议你用在过去的这个一个月里啊。 open claw, 呃,以以前也叫 mot claw, 呃, cloudboard 改名改了很多次啊,呃,简直是火遍了天啊, 现在几乎成了开源 a i a 政策的代名词啊,有各种各样的玩法,相信你也听到了。但是呢,它也有一定的问题啊,主要的问题呢,就是,呃太重,太大, 它采用了 note g s 的 这个运行时资源消耗比较大,那部署呢?比较臃肿。于是呢,就有好事者呃,用 rest 重新写了一遍,起个名字呢,叫 zero claw, 就是它所有的代码都是由 rust 来编写的。它的设计哲学呢,非常直接,也就是极致的性能,极低的资源利用,无缝的模块化替换。 它最突出的特点呢,就是轻量化。那对比 opencloud 呢,需要内存需要呃,一 g 以上,而 zerocloud 呢,只要小于五兆就可以,那启动时间 opencloud 差不多要五百多秒。而 zero cologne 呢,启动只要十毫秒。那对于部署成本呢?用 open cologne 呢,可以,你可以用一个 mac mini 要四千多块钱啊,或者你用呃云端的方案, 腾讯云或者阿里云的轻量服务器,一年也要几百块钱。而 zero cloud 呢,它可以运行在任何的设备上头,甚至很小的那种树莓派啊等等,这些都没问题,因为它消耗的资源非常少, 所以你可以把它作为一个嵌入式的,把 zero cloud 呢,作为一个嵌入式的这个 ai agent, 比如说嵌入到你的智能家居的设备里面。其实刚刚说了一大堆好处啊,我跑了一下,目前建议呢, 如果你不是即刻,现在还不建议你用,因为我在跑的过程中呢,其实发现他目前还不是很完善。另外啊,自由可拉呢,在安全性方面做了加强默认的方案呢,都是低于较高安全策略的, 其实这个是对于生产环境来说是好事,也就是说他不是一个开盒即用的产品,比如说他默认是不不允许互联网访问的,所以啊,初识配置还是比较复杂,由于肌肉可乐他 这个轻量化的这个特点呢,其实他为我们做介入式的 ai 智能应用提供了更多的可能性,但是如果你不是即刻的话,建议大家可以先持续关注就好。 好在这个项目呢,更新非常频繁,我相信呢,呃,在呃不久的将来呢,他会呃做的越来越来越完善。

00:53查看AI文稿AI文稿

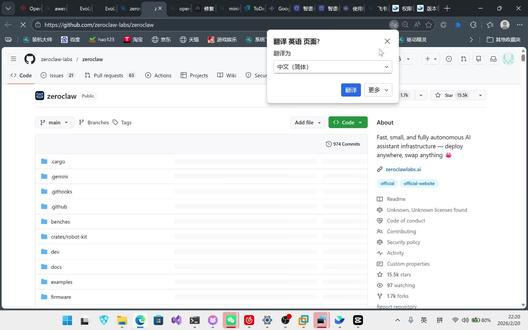

00:53查看AI文稿AI文稿兄弟们,感冒了啊,趁着现在声音嗓音比较磁性,给大家录个视频。前两天不是出了个 open claw 吗?现在又出来一个 zero claw, 它们和那个 open claw 有 什么区别呢?一个它启动速度非常快,第二个它占用内存非常少。这是中文网站啊, 这是他的 github 上面的地址,然后点击这个中文简体中文,可以看到他这个项目简介,还有这个和 opencloud 的 对比, 你看他的这个大小非常小,占用内存才小于五兆,在一个十美元的硬件的基础上都可以运行。下面是他的这个部署方法,非常简单,感兴趣的可以去看一下。 这个用我的十六 g 内存的电脑给大家录的,没有用那个一百二十八 g 的, ok。

823沪上码仔AI 01:11查看AI文稿AI文稿

01:11查看AI文稿AI文稿不要再被骗了,最近有个项目是这个外网特别火的肌肉扣啊,十五点五 k 啊,我刚才试用了一下,我感觉这个效果其实没有那么理想啊,这里我已经搭建好了,我们看一下 啊,我,我每次跟他说话,他他虽然说会及时回,但是吧回完之后就没有再次回了,可能这个飞沙剑的问题啊,我我我我是针对的是飞沙剑问题,但是后台其实他没有回我啊,然后我我再问一下他好好了没有 啊?这个肌肉刻好,它就是,嗯,特别火,就是说它是 rus 的, 直接给他给他那个重构的一个项目,然后它延迟只有十毫秒,虽然速度真的很快。你看 它没有开始写,我给它用的是 g l m, 这是这是一个最好的模型啦,我觉得这 g 普的最好的模型了呐, 我,我让他给我做一个 zui 的 这个啊计算器,哼,我觉得这个项目肯定没有当初的那么理想,嗯,这个之后肯定会有一些调整。

43余弦 01:48查看AI文稿AI文稿

01:48查看AI文稿AI文稿今天我们来聊聊 zero claw, 一个号称零开销零妥协的 ai 基础建设。咱们直接看数据,这一比对,差距简直不是一点半点,完全是数量级的碾压 哇!你再看这个启动速度,不到十毫秒,这是什么概念?快了四百多倍啊!看到这你肯定会问,这怎么可能呢?这么大的性能差距到底是怎么做到的?答案就在于它的核心架构,一个万物可插拔的设计,而这完全是用 ras 实现的, 这个关键特性就叫 tray, 你 就把它想成是软件上的 usb 接口,什么都能往上插。 所以你看,从 ai 模型到内存,每个核心系统都是一个独立的模块,想换哪个就换哪个, 口说无凭,咱们来实际操作一下,就换个内存后端,看看有多简单好,假设你的配置文件里,内存后端用的是高性能的 sql lite 数据库,现在我们不动代码,只改这一行配置,把它换成简单的 markdown 文件 搞定,就这么简单,一行代码都不用改,更别提重新变异了。这种强大的灵活性意味着什么呢?就是部署和设置过程会变得超级简单, 到底有多快?你看就这三步命令就能把它跑起来。所以总结一下 zero claw 给你带来了什么?超清亮闪电启动完全可插拔,还不怕被厂商绑定?这就回到了它的核心理念,零开销零妥协,随时随地部署,随心所欲替换。 好问题来了,当你的 ai 基础架构能做到这么便宜、快和灵活,这会解锁哪些全新的玩法呢?

65老王Bingo 01:11查看AI文稿AI文稿

01:11查看AI文稿AI文稿带你看看我用 oppo pro 两周之内的真实消耗,再告诉你一个技巧,让你的头壳消耗直接减少至少一半,这是谷歌官方的 api 基本系统,我们来看看这个月我是用了十二美元,我使用的模型主要是 java 三 pro、 nano 三 pro 和 sunflash, 我 用它做一切的流程,自动化、视频生成、图片生成、代码生成。再看看我们团队的差不多有三十人,这两周用了七十美元,算下来每天就是五美元,他们用文字、视频、图片的模型做类似的用途。这样算下来,我们每人每天用 java 的 模型差不多就是五到十块人民币, 这个费用远远低于大家在网上说的数字。那为什么我们能做到这么低呢?告诉大家一个技巧,首先打开你的电脑终端,确保你的 open class 是 正确安装的,然后输进去 open class skills, 这里面会告诉你你已经安装了哪些没有安装,哪些打了对号的是安装的。当你认真读清楚你安装的这些技巧之后,在你用旁边和 open class 对 话的过程中,在每次做任务的时候一定要加上一句话,就是用指定的技巧。比如在这里我让他帮我修改 pdf 的 时候,用到了 nano pdf skill, 如果你不指名的话,他会调度多个,一个一个去尝试,所以很多头衔就会浪费在过程中。 如果你已经安装部署的 oppo core, 赶紧去试一试这个技巧,你会看到明显的头壳消耗的下降。如果你还没有安装,或者你不知道怎么去本地部署安装 oppo core 的 话,我们正好有一个 ai 工具小组,里面有手把手的安装教程和进阶的 oppo core 落地应用教学。如果你感兴趣,可以看视频主页介绍,第一行会有专人给你提供更多的信息和介绍。

729硅谷E老师 08:00查看AI文稿AI文稿

08:00查看AI文稿AI文稿大家好,欢迎回到我的频道,昨天我刚做了一期关于 opensea 替代方案的视频,主要是因为说实话, openclaw 最近简直火出圈了, 他在 github 上已经拿到了十八万个 star 开发者,刚刚入职了 openai, 现在简直是全民都在尝试运行它,但问题在于它太吃资源了,光内存占用就超过了 e g b, 启动起来简直慢得离谱,要是没台性能强悍的机器,想跑通它可就难了。 显然,大家也都遇到了同样的问题,评论区里有很多人都在给我安利这款替代品, 我特意去钻研了一下,发现这东西确实非常厉害。那么咱们今天就来好好聊聊它。它的名字叫做 zero claw, 它们的 github 上的标语很有意思,叫做 claw down right。 这是一款完全基于 rust 开发的全自主 ai 助手, 它的定位是作为 open c o 的 超轻量级替代品,整个二进置文件只有三点四 mb, 这就是全部的体积,仅仅三点四 mb。 相比之下, open circle 光是核心就超过了一 gb, 也就是说体积缩减了百分之九十九,这简直不可思议。那么为什么这一点如此重要呢? zero claw 的 核心理念在于 ai 助手因使轻量守护进程而非臃肿操作系统。 open claw 想要面面俱到,这固然很酷,但这也意味着它对硬件配置要求很高。 而 zero claw 走的则是完全不同的路线,它极致轻量,运行飞快,而且几乎不挑运行环境, 我说任何设备绝非夸大。其次,哪怕是树莓派 zero 也能跑,就这么一块十美元的板子,足以内存占用甚至不到五 mb, 在 正式翻译版本下,启动时间甚至不到十毫秒,对比一下 openclock, 光是启动就要花上好几秒, 所以这表现相当出色。接下来我们看看它具体支持哪些平台。 zero cloud 原生支持超过二十二家 ai 服务商,包含了 cloud、 open ai、 olamar group、 mister 等众多主流平台。 如果你在本地运行 oledma, 那 它简直就是绝配,因为你可以在同一台机器上运行 zero cloud, 就 能在同一台入门级硬件上运行你的模型。网上甚至还有配合 oledma 配置 zero cloud 的 教程,大家都说这是他们用过部署最快的 open cloud 分 支。 不仅如此,它还支持对接所有主流的通讯软件,比如 telegram、 discord、 slack。 和 whatsapp。 和 open cd rom 一 样,你可以控制电脑,只需通过聊天软件用手机操作即可。但不同的是,它运行时几乎不会占用系统资源。 另外,它的架构设计也非常出色。 zero cloud 的 所有组建都是基于特性构建的,所以服务商、频道、工具和记忆模块全都能随时替换。 你可以随意切换 ai 服务商,或是只需改动一下配置文件就能更换通讯频道,完全不需要修改代码,这非常关键,因为这意味着你不会被特定平台绑死。 如果你想从 openai 换到 alm 码,或者从 telegram 转到 discord, 只需改下配置就能直接上手使用了。 接下来咱们聊聊它的记忆系统,因为这部分的表现真的让我感到非常惊艳。 zero cloud 基于 sqite 构建了一个混合搜索引擎,它将向量切入以 b i o b 格式存储,并利用 sqite 的 f t s 五扩展实现支持 b m 二十五评分的权威搜索, 而最厉害的地方在于完全没有外部依赖。你不需要运行 python 或是 elasticsearch 等任何重量级服务, 所有功能都集成在那个极小的二进制文件中,老实说,这真的很了不起。此外,安全性也是 zero cloud 的 一大亮点, 它拥有严格的杀箱机制,显示的命令、白名单以及工作区权限控制,确保智能体仅能访问指定工作区内的文件,且默认仅监听本地 local host 的 地址。除非手动授权,否则它不会开放所有网络接口。 因此它完全符合社区针对 ai 智能体制定的安全规范。这非常关键,因为如果你关注过近期新闻,就会发现已有恶意程序专门针对 open c pro 配置文件并窃取 api 密钥, 所以这种从底层架构就内置安全设计的做法意义重大。如果你正打算从 open sql 切换过来,它已经内置了迁移工具,只需运行迁移命令,先带上 dryrun 参数进行预览, 确认无误后去掉参数,再次运行即可正式迁移。它会自动导入 open c o 的 记忆和配置,确保数据无缝衔接。至于 zeroclock 的 安装过程非常简单,先克隆仓库,运行 cargo build release, 最后执行 cargo install path 即可。接着运行 zero claw in it, 按照引导程序进行初设设置,这会帮你配置 ai 服务商 api 密钥以及频道参数。 所有配置都会保存在配置文件中,位于摩摩斯 zero cloud config tom lives, 而且 a p i 密钥默认都会加密存储,这一点非常加分。现在我来聊聊我对这个项目的真实感受。 我觉得 zeroclaw 确实有很多让人眼前一亮的地方。首先,它降低了门槛,让 ai 智能体触手可及,让没有昂贵硬件的用户也能轻松上手。只要十美元的树莓派,对比上千美元的 mac mini, 这差距简直是天壤之别。其次, rust 的 底层架构保证了内存安全和极高的运行速度。第三,模块化设计意味着你不再受限于单一的供应商或平台。 目前他已斩获七千六百个 star 以及六百四十多个 fork, 这足以说明 社区正在鼎力支持这个项目。我认为这反映了一个更大的行业趋势,本地 ai 助手领域正趋于成熟,用户开始追求轻量与安全,而非一味追求功能的堆砌。 不过也有一些细节需要注意,既然它是用 rust 编写的,参与这个项目需要掌握 rust 语言,这对部分开发者来说可能存在一定的门槛。此外,它的插件生态合集成功能目前还比不上 open c 洛, 但说实话,就它的功能和超低资源占用来看,这绝对是一个非常出色的替代选择。 我觉得如果你用的不是高端配置来跑 opensea claw, 又或者你更看重安全和效率,那一定要试试 zero claw。 它开源前免费表现确实非常惊艳。总之,这东西挺酷的。下期视频见,拜拜!

01:34查看AI文稿AI文稿

01:34查看AI文稿AI文稿cloud bot 真不像很多博主说的是所谓的炸裂产品,真没那么神。因为有客户想用 cloud bot 做产品, 我让我同事研究了几天,下面来聊一聊。首先,它是看上去什么都能做的数字员工,但实际上呢,什么都做不了的产品。所有这些功能都是需要相应的 skill 的 驱动,而且还要不断地去调试,而不是上手就能用, 而且超级消耗, token 用了三天不到都发掉了五百多块钱。其次呢,我仍然没有搞清楚它有什么实际的应用场景,比如抓取网页,随便找个 a 卷的就能实现,而且这种通用型的抓取信息基本上也没啥商用价值, 精准性根本无法控制。然后就是通过聊天工具去控制电脑操作干活的功能,听上去很酷,可是稳定性不太好,时快时慢,有时候两分钟都出不来。概念很好,而且对中国用户太不友好了。 综合来看呢, clubbot 的 用户应该是技术开发者,不是普通的非技术小白,安装这套东西还是比较费劲的,普通用户也没必要去研究它了。但是这类产品提供了一些新的产品思路,这是非常有价值的。像 manos 一 样,提供了通用自连体的概念, 而 cloud bot 提供的是桌面智能体的概念,通过 agent 操控本地电脑的概念还是很有启发意义的,带动更多的创业公司去研究这些方向,创造更多的新产品,也期待开发者能够贡献更多有价值的应用场景。

20谷发条企业智能体 11:01查看AI文稿AI文稿

11:01查看AI文稿AI文稿在二零二六年, open code 和 openwork 可能是我们个人 ai 使用者能够用到的性价比最高的 ai 智能体工具了。在个人日常办公、文件处理、数据分析以及报表生成、 ppt 生成这些领域, open code 是 真的能够直接接管你所有工作的工具, 支持 m c p, 也支持 ansapic 最新发布的 agent skill 功能。同时它还支持市面上几十种 ai 大 模型,还提供大量的免费 ai 模型供你使用。 哪怕你想尝试 ai 编程, open code 也是功能强大且性价比最高的工具。那么今天我就来为大家介绍一下如何安装和使用 open code 这款的 code code 的 工具,以及 open work 这款对标 co work 的 开源个人办公助手。 今天的视频分为以下几个内容,首先我们来快速安装 open code, 包括命令行和桌面 app, 然后了解一下如何做相关的环境设置以及添加 agent skill。 然后我们来安装 openwork 这款开源版的 cloud co work 工具,并熟悉一下相关的设置。最后我们来快速了解一下大模型的选择以及 token 的 消耗相关问题。视频中的内容和安装步骤我都整理成了知识笔记,视频的最后会分享给大家,那我们就正式开始。 opencode 的 安装非常简单,因为它不像 cloud code 那 么避远,而 sapic 对 cloud 的 使用有非常严格的限制,大多数情况下,我们还得通过配置环境变量来使用第三方 ai 模型, 而 opencode 的 不用。它的安装方法非常简单,直接到它的官网下载桌面客户端下载之后双击安装即可。如果你习惯命令行工具,也可以直接通过命令行命令行版本,具体的命令在它的官网上都有。 安装之后打开桌面客户端,选择你的项目文件夹,然后我们就来到了项目界面。接下来我们要做的第一件事就是选择一个 ai 大 模型, 我们点开选择模型这个按钮,在弹出的窗口中可以看到模型列表,其中最上面列出的是目前提供的免费模型,我们先选择一个免费模型,这里我们选择 mini max m 二点一。 然后在 ai 对 话框的左下角有一个 build 和 plan 的 模式切换按钮,那这两个有什么区别呢? build 的 意思就是直接建造, ai 会按照你的要求直接修改文件、编辑代码、删除文件等等。 而 plan 就是 做计划,先进行分析和规划,但并不会真的动手去做,等你先确认 ai 给你的规划你满意了,再切换到 build 模式去进行实际操作。 build 和 plan 是 两个默认的智能体,我们还可以通过配置文件来添加自定义的智能体,这个我一会儿会说到, 那么这就是 ai 对 话框的两个设置项目。接下来我们要了解几个核心的技巧。首先就是斜杠命令,在 ai 对 话框中输入斜杠就能看到斜杠命令了,比如斜杠 init 是 促使化项目并创建 agent 点 m d 斜杠 m c p 是 打开 m c p 列表,查看你已经连接的 m c p 服务,这里呢就引出了下一个核心技巧,也就是配置文件。我们通过斜杠以 n t 出示话来创建的 agent 点 m d 文件是项目特定的配置文件,比如项目结构、编码规范、命名规范等等, 这些大多数都是和编程有关的,如果你不写代码,而只关注个人日常办公和文件管理的话,不用关心这个。另一个文件就是 open code 点 json 这个配置文件。这个配置文件所在的位置是你用户目录下的点 config 文件夹下的 open code 目录下, windows 就是 c 盘 user 你 的用户名,然后找到点 config。 而 mac 用户是你用户主目录下的点 config 文件夹。要注意, mac 上带点的目录默认是隐藏的,你要使用 command 加 shift 加点,把它们显示出来。 这个 open code 点 json 文件或者是点 json 文件,就是 open code 的 核心配置文件了。点 json 就是 json with comments, 就是 带有注视的 json 文件,本质上就是 json。 那在这里我们可以配置 mcp 服务以及自定义 agent。 我 目前就配置了一个 notion 的 mcp 啊。 notion 的 mcp 也很简单,是 notion 官方发布的,我之前的视频有讲过, 我还自定义了一个叫 smart build 的 智能体,并设置了系统提示词。那这样一来,在 ai 对 话框中,你除了能看到 build 和 plan 这两个默认 agent 之外,还能看到你自己配置的 agent。 有 关 open code 点 json 这个配置文件的详细写法,大家可以参考 open code 的 官方文档。 那么关掉 open code, 点这一次文件,在当前这个 open code 文件夹下,我们可以创建一个 skills 文件夹,然后把我们从 github 上下载的 skills 复制进来,那么我们的 open code 就 安装上这些 skills。 其实和 cloud code 是 非常相似的, 我目前也是安装了很多日常工作相关的 skill, 比如 word, excel, pdf, 还有无线画布、 comics 相关的 skill。 那 关于 skill 我 之前的视频也讲过,那么到此我们就完成了 open code 的 所有配置。那总结一下,安装完 open code 后, 选择一个免费的 ai 模型,然后在用户目录下的点 configure 文件夹下的 opencode 文件夹里创建一个 skills 文件夹,把你常用的 skills 复制进来,你的 opencode 就 已经是完全体了。那至于 mcp 和自定义 agent, 按照你的需求到 opencode 点 jc 文件里添加就可以了。 那具体的使用,我在屏幕上快速地做一个展示,比如输入一个指令,让智能体调用相应的 skills 来为我们进行英文文档的翻译,并拣写成中文的知识笔记。还可以读取 rss 订阅,并通过 notion mcp 把获取到的 rss 信息导入到 notion 数据库中。 还有一个最便捷的使用场景是直接把 github 上的开源项目的项目地址发给 opencode, 让它来帮你安装在电脑上,那这样你就不需要自己亲自去阅读这一大片英文的 readme 文档,那非常的方便。 但是归根结底, open code 还是一款侧重于编程的工具,和 cloud code 是 类似的,但是在我们日常工作中用的最多的就是办公场景,比如文件的处理、数据分析、办公流程等内容。那么这里最好用的工具就是 openwork, 它是在 open code 的 引擎基础上构建的桌面应用程序,和 cloud 最新推出的 codewalk 一 样,针对非技术用户和日常办公场景进行了大量的优化,有非常好用的图形化界面,那使用起来几乎没有什么难度。接下来我们就来快速安装一下 openwork。 我 们来到 gitlab 的 openwork 仓库,点击右侧的 release 链接,在列表中选择适配自己操作系统的安装文件,下载之后双击安装即可。 然后打开 openwork, 首先还是选择一个文件夹,这个文件夹就可以选择你日常办公的文件夹,比如放置你的报表和 ppt 的 文件夹,也可以是你的 obscene 知识库。文件夹 打开之后,我们点击 new task 按钮,就可以开启一轮 ai 对 话了。当然我们还是要选择一个 ai 模型,我们依旧选择一个免费的模型。 mini max m 二点一 这个时候我们在右边的菜单栏能看到一些内容,包括已经连接的 m c p 服务、已经安装的 skills 以及已经安装的插件等等。 我们先点击左上角的后退按钮,回到主页面,在左侧菜单栏中就能看到一些设置选项,比如我们点击 skills 就 能看到已经安装的 skills, 还可以点击导入按钮来导入你下载的 skills, 或者直接打开 skills 所在的文件夹。 那这样的图形界面是非常一目了然的,比之前的 open code 界面要直观很多。我们点击左侧的 mcp 选项,页面中就显示了你所连接的 mcp 服务,它默认给你提供了一些 mcp, 比如 notion, stripe 这些。 把滚动条拉到最下面,在 edit mcp config 里就可以编辑我们刚才说过的 open code 点 jc 文件了,那这里我们就不多讲了。 然后在 plug ins 界面,我们可以安装一些插件,这里我推荐一个 github 上名字为 awesome open code 的 仓库,里面收集了大量的优质 open code 插件, 把插件的名称复制到 openwork 的 plug ins 界面中的 add plug ins 文本框内,然后点击 add 按钮就可以添加插件了。 比如你可以添加一个 google ai 搜索插件来增强 opencode 的 网络搜索能力。再比如,你可以添加 gemini 身份验证这个插件,来让 opencode 能够使用你谷歌账户中现有的 gemini 套餐的额度。 我们都知道谷歌的 ai 订阅用户会有大量的 java c l i 和 anti gravity 的 ai 额度,那通过这个插件就可以使用 java c l i 的 ai 额度。假如将来 open code 不 再提供这么多免费的 ai 模型,那么这个插件可以让你使用你的 java c l i 额度来进行智能体操作。 同理还有 open ai 的 codex 认证插件,原理也是一样的。这个仓库里还有一些其他资源,比如魔兽争霸通知音效插件,再比如一些 open code 的 皮肤主题, 大家根据自己的需求来使用就可以了。那如果你是 opcode 用户,你可以搜索 opencode 横线 opcode, 这个插件能够让你直接在 opcode 界面中使用 opencode, 那么到此我们就完成了所有的环境配置。回到我们刚才的 ai 对 话框,就可以发送指令让智能体来为你执行任务了, 我们由 skills 来为我们执行特定的任务。还有 m c p 连接外部系统,比如 notion 推出云文档、微软 office 三六五和 autodesk 邮箱等等。 我们的 openwork 现在是真正意义上的核心枢纽,连接你所有的工具。所以我才说 openwork 和 openwork 可能真的是你二零二六年的主力 ai 的 工具了。 那最后我还是来讲一下 token 的 问题,智能体的操作非常的消耗 token, 所以 最近很多 ai 厂商都推出了一些套餐,比如智普 g l m 和 mini max 都推出了 coding plan, 几个小时之内允许你发送特定数量的请求。 还有就像我刚才所说,我们可以通过插件来使用 gemini c i 或者 codex 的 ai 额度,尤其是谷歌 gemini, 那它的编程工具呢?做的不咋样,但是得益于它自家土豪般的 tpu 和语音服务,它的 ai 额度还是非常慷慨的。所以如果未来有一天 opencode 不 再像现在这样提供这么多免费的 ai 模型,那么大家就可以考虑我刚才说的这几个途径来以更高的性价比来使用 opencode。 另外 opencode 还支持连接本地大模型,比如 alamo 和 lm studio。 本地大模型的优势是极致的隐私性,但是性能还是比不过云端大模型的。另外还比较吃电脑的配置, 以我之前视频中大家给我的留言来看,很多人的电脑性能并没有那么的好,部署本地大模型还是比较吃力的, 所以大家还是根据自己的实际情况来选择适合自己的大模型。那么到此今天视频中的内容就全部结束了,大家现在就可以开始安装部署自己的 ai 智能体了。那具体的安装步骤我整理成了文档, 大家可以在我的频道信息中看到我的个人主页地址,然后直接去下载就可以了,有任何问题都可以给我留言,记得点赞关注,谢谢大家!

713杰森的效率工坊 00:36查看AI文稿AI文稿

00:36查看AI文稿AI文稿在 oppo kart 爆火后这几天又相距出现了各种爆改款龙虾。如果你既没有 mac mini, 又没有高性能的主机来跑 oppo kart, 那 就可以试试今天这款 zelda kart, 那 zelda kart 基本就是它的反面,即清即简。这是一个用 ras 重写的 oppo kart, 体积多大?三照字节二帧值,文件启动速度几乎秒开, 对比一下,典型的 note js 进程,动不动就是四百兆字节内存长驻。自绕口令的思路很简单,把能跑变成跑得轻,跑得稳,快去试试吧。

15犟森头 01:09查看AI文稿AI文稿

01:09查看AI文稿AI文稿想用 colog 根本打不开,好不容易用上了号又被封了,用了二百刀也退不回来。直到我发现了这一个网站,官网有的功能这里都有,而且不用注册,直接就可以使用。 我们先来看一下效果,让他帮我写一下毕业论文。左边是 colog, 右面是 deepsea, 能看出来 colog 比 deepsea 更严谨学术一些。这个参考文献呢,知网也都能搜的到。 别光只会聊天。接下来我们再试一试 glow 的 skill 功能,在这里点击设置,点击 capabilities, 然后往下滑,我们就可以看到 skill 的 这个选项。在这里你可以上传自己的 skill, 也可以使用官方的 skill。 我 调用的是品牌指南的官方 skill。 点击聊天,我让他帮我做一个关于 ai 安全的 ppt, 这是他帮我做好的 ppt, 这质量我觉得可以直接交差了。接下来再看一下他的前端能力,让他生成一个记账本,这种生成和交互,国内 ai 没有哪个可以做到吧。最后扔一份全英的财报给 他,他直接给了我一份可式化的中文分析,比我自己肯效率高十倍。这一个站我已经用了两年,一直都很稳,想要的关注我。

211六粒的世界 07:18查看AI文稿AI文稿

07:18查看AI文稿AI文稿我们首先来看 ai agent 终极对决 menace agent 与 open claw。 我 个人在使用 open claw 的 三周时间里,每天都刷新着认知,而 menace 的 skill 执行和纠错能力此前已给我留下深刻印象, menus agents 的 迅速退出更让我惊喜体验后也确实表现不俗。简单来说,对于追求极致控制的即刻和开发者, open cloud 仍是首选。但对普通用户而言, menus agents 足以胜任日常百分之八十的工作, 这背后实际上是传统软件的示威,以及 ai 智能入口和校交媒体霸主地位的激烈争夺。 我们看到, matta、 腾讯等科技巨头都在积极布局这一未来赛道。进入二零二六年, ai agent 的 浪潮正席卷全球,他们已不再是简单的智能助理,而是进化为能够自主规划执行任务,甚至像人类一样操作电脑的数字分身。 在这场激动人心的改革中, menace agents 和 open claw 无疑是两大焦点,它们各自代表着 ai 代理发展的不同路径, 一个追求极致易用性,让 ai 触手可及,另一个则致力于赋予用户对 ai 的 绝对掌控,打造真正的数次提升。 menus agents 作为 menus ai 全新推出的个人 ai 助理,其核心定位正式实现效率普惠,而非仅为即刻掌控服务。它致力于将复杂的 ai 能力极致简化,让普通用户也能轻松拥有一位强大的数字员工。 你只需在 telegram 或 whatapp 中扫码即用,就能让 ai 协助你完成市场调研、报告解析、数据分析乃至应用部署。 manus agents 的 哲学便是让 ai 真正成为每个人的生产力工具与 manus agents 的 普惠理念形成鲜明对比。 open claw 则代表着对 ai 代理的极致掌控, 它是一款开源的本地 ai 助手框架,只在赋予用户像真人一样操作电脑的能力,实现彻底的全站接管。 openclaw 的 创始人 peter steinberg 已被 openai 蛊惑,这无疑讲弦了其在未来 ai 代理生态中的重要地位, 其核心哲学是 ai 代理必须完全在用户掌控之下,确保数据安全与操控透明。 openclo 更像是您的专属数字替身,在本地为您打理一切数字事物。对于追求极致定制化和隐私保护的极客用户而言,它无疑是实现数字自由的终极梦想。我们来看技术架构与运行机制。 manos agents 的 核心优势在于其云端沙箱架构,它提供了一个隔离且安全的运行环境,具备完整的 u lan 图文件系统和 shell 执行能力。这一意思是用户无需进行任何复杂配置,即可实现真正的开箱即用。 此外, manos agents 全面集成了 anthropic 的 agent skills 开放标准,让用户可以将成功的任务流程封装为可附用的 skill, 也能轻松利用社区或团队共享的专业 skill。 最终,通过 manos 一 点六 max 旗舰 agent 模型,其规划与问题解决能力得到了显著提升,确保各项任务都能高效完成。 接下来,我们深入了解 openclaw 的 技术架构与运行机制。 openclaw 秉持本地优先的设计理念,它支持 docker 部署,并通过 accessibility api 或屏幕录制,能够直接操作本地系统的用户界面。 这种独特的机制赋予它强大的具身操作能力,使其能像人类一样灵活地与电脑进行交互,并高效操作各种原生应用程序。 作为一个活跃的开源项目, openclaw 拥有一个庞大的社区,积累了超过七百个社区。构建的 skills 提供了较为丰富的定制化选择。 尽管部署它需要用户具备一定的基数背景,门槛相对较高,但 openclaw 所带来的极致隐私保护和高度定制化正是它吸引全球技术及客的核心魅力所在。接着,我们来看看 menace agents 的 应用场景与用户画像。 它被定位为一款效率普惠的个人 ai 助理,运行在云端隔离沙箱中,您只需通过 telegram 或 whatsapp 等聊天软件即可轻松交互。其核心优势在于零门槛开箱即用,并提供强大的任务交付能力和丰富的 agent skills 生态, 无论是职场人士、内容创作者、小型团队还是普通用户都能充中受益。 manus agents 可广泛应用于市场调研、报告转载、数据分析、代码开发以及日常效率提升等多个领域。聚焦 open call, 它的核心定位是一个由机客掌控的开源 ai 注述框架。 它可在本地设备或私域云上运行,支持本地 u i 操作和多渠道接入。其主要优势在于提供极致的隐私保护、高度定制化以及全站操作能力,并有强大的开源社区作为后盾。 因此, opencloud 的 典型用户画像是开发者、技术及客以及那些对数据隐私和系统掌控有极高要求的用户。 它非常适用于本地自动化、高效文件管理、精细化软件操作以及构建个性化工作流等多种场景。在 ai 代理时代,数据安全与隐私无疑是用户最关心的问题。我们看到两种不同的处理模式, menus agents 采用信任托管模式,数据在云端处理,其安全性依赖于 menus ai 的 信任背书和技术保障,这为大多数用户提供了便捷性,但对于极度敏感的数据,用户可能需要仔细权衡。 相对的, opencloud 则将数据和操作完全致于用户。本地设备赋予用户绝对的物理控制权,安全性由用户自行配置和管理, 这无疑是为那些对数据隐私由极高要求的用户提供的最终集解方案。展望未来, ai 代理将重塑我们的人机交互。 menace agents 和 open claw 作为商业化、普惠和开源生态的代表,并非对立,而是互补,共同拓展着 ai 技术的边界。那么,如何选择最适合您的 ai 伙伴呢? 如果您追求极致效率并信任云服务, menace agents 无疑是您的理想之选。而如果您是技术爱好者,高度重视数据隐私并渴望深度定制的体验, openclaw 将为您开启一个全新的数字世界。 ai 代理的时代已经来临,它们将成为我们工作与生活中不可或缺的数字分身。拥抱 ai 代理意味着您将拥有更高的效率、更广阔的创作空间以及更智能的未来。您准备好迎接这一激动人心的变化了吗?

4AI局座 01:22查看AI文稿AI文稿

01:22查看AI文稿AI文稿英伟达最新动作引发 ai 安全新思考。这家芯片巨头刚刚发布了一份关键指南,教用户如何在本地硬件上运行 火爆全网的 openclaw ai 智能体。这项技术突破背后隐藏着惊人风险。最新数据显示,目前全球已有超过四万个 openclaw 实力存在安全漏洞,其中一点二万个甚至可以被远程攻击。这些暴露在互联网上的 ai 系统 不仅可能泄露 api 密钥,还可能让黑客获取 telegram、 机器人令牌等敏感信息。英伟达特别推荐使用配备一百二十八 gb 内存的 d g x bark 工作站 来本地运行大型语言模型。该公司强调,本地运行不仅能避免高昂的云服务费用,更重要的是能保护用户隐私数据。通过设置三万两千七百六十八个 token 以上的上下文窗口,用户可以获取最佳性能。令人担忧的是,随着 opencloud 的 爆红, 一个全新的托管服务市场正在快速形成,目前已有超过三十家服务商提供从免费到每月数百美元不等的托管方案。 但专家警告,即使采用英伟达建议的安全措施,也无法完全消除所有风险。这场 ai 安全与便利性的博弈正在上演。美国成为受影响最严重的国家,其次是中国和新加坡,在享受 ai 便利的同时,已经成为摆在每个用户面前的重要课题。

68硅基透镜 02:52查看AI文稿AI文稿

02:52查看AI文稿AI文稿哈喽大家好,欢迎大家收看洋洋的手柄测评。大家都知道之前有很多朋友猜测我是不是有一强的漂亮手柄,今天就跟大家说不是,然后目前在用的大概还有四五款,这款就是我个人特别心仪的一款。首先就是它的性能啊,跟 pro 可以 说是不分上下, 只要普肉一半的价格,二百多我们就能拿下这一款性能非常全面的手柄,而且它的重量也不会很重,它的握把这里对女生来说非常友好,但是呢对男生也是不错的,我看了他们的反馈就是基本上男生女生都不会觉得握起来很大呀,或者很重,但却也是很有质感的。 你的造型是非常好看的,我这个是自己定制了一个 diy 的 面壳,然后大家收到的话是一个非常经典的蓝白配色,这个上面也是可以自由 diy 的, 它有再送一个贝壳和一个镭射贴纸,我很喜欢这个贴纸,虽然我一直没有 diy, 看我们手账人看了简直就是狂喜啊。首先它支持随差唤醒功能,这是一个很重要的功能,然后大家可以看到它这是由两档调节,咱们把它调节到 switch 模式。接下来我们需要长按这个 home 键三秒, 指示灯快闪之后我们点这个主机,然后更改握把顺序,哎,这个匹配成功了, 在配对成功的二十秒内,将主机上的装音框取下来并重新装上,然后咱们此时就激活了无线唤醒功能哦,只有第一次需要这样操作一下,之后是咱们直接点 home 键就进来了, 这个时候我们就激活了无线唤醒功能,以后就都可以按 home 键,三秒就可以自动打开此位置主机啦,整体的按键声音也特别清脆,它的手感我特别喜欢,然后它的摇杆用了比会摇杆更好的 tmr 空气摇杆, 然后他的摇杆用了比或者摇杆更好的 tmr 摇杆更灵活,然后不易漂移,使用寿命更长,回弹功能也很好,回弹也很好。这个轮盘大家可以自由更换,是选择用轮盘还是用十字键,我个人比较喜欢用轮盘, 这样玩一些赛车游戏非常方便操作。整体是 hd 震动 pro 同款震动,感觉是有多层次的震动反馈,而且震荡是可调节的三档, 大家都赶紧去把这个本索七大不可思议,趁着十滴的好价捞到,然后以及咱们之前推的这个像素风咖啡馆也最近十滴了,大家快点去吧,过两天又结束了,别说我没告诉你们哦, 更好的手柄是可以让我们的游戏体验超级超级加倍哦,而且真的超级萌!然后推荐比较看重性能的,然后看重颜值的以及看中握把,这里的握把也是有这种纹理的,可以防手汗, 以及也是双档可调节,也可以红编程,可以设置连发,有 nfc, 可以 刷 omega, 这样的话我们就可以给自己的洞森刷一些小动物之类的,这个手柄都可以做到。 好啦,大家晚上拜拜,推荐大家快去试试看哦,拜拜,我们下期见!等我身体完全好再给大家拍露脸的视频撒拉嘿!

18:53查看AI文稿AI文稿

18:53查看AI文稿AI文稿哈喽,大家好,我是阿金志。近期这个 open club 的 龙虾项目非常的火爆,对于短时间热度过高的项目,我一般都是谨慎对待。这个 open club 的 部署教程其实一早就有粉丝提出来让我来做一期了, 我当时的话简单的攻略了一下,发现两个问题,一个是这个项目的使用场景有点伪需求,但这个不是纯伪需求,而是对于大多数人而言, 因为目前的话,大多数人他可能会想到用来编码爬虫、搜索资料等等, 但这个项目的核心内容其实不是这个,或者说以上提到那些功能,其他的方式都可以实现。第二点的话,他的安全风险比较高。 我觉得这个项目的核心功能就是他拥有一个高权限,可以执行需要命令以及读写文件等系统级别的操作, 所以这个伴随着很高的一个风险。当时我给他的回复是可以查找一些风险相关的文章, 然后目前的话只适合尝鲜使用。那今天这期教程的话,就是来教大家如何安全的部署并免费的尝鲜这个热门项目。 ok, 我 们先到我的博克这边来看一下整个文章,做一个简单的介绍。好吧, 这边的话我放了 open club 的 一个官方项目地址,大家有兴趣的可以去官方地址看一下。目前的话最新版本是二点一三,也就是昨天刚出来的一个版本, 但是这个版本目前是有问题的,我后面会给大家提到具体的项目内容的话,我这里就暂时不多做介绍了,有兴趣的可以去看一下。好吧,因为我的频道小白的粉丝会比较多一点,所以我做一个简单的介绍啊。 这个项目的话不是单纯的一个机器人聊天,他是作为一个网关的属性,简单来说他作为一个网关可以去命令多个 ai 工具来帮你去完成各种任务的操作。那这里的话肯定就不局限于聊天, 他甚至可以读写系统文件以及调用命令等等需要高权限的一些操作。所以为什么提到他的风险比较高,就是因为他有极高的一个权限。 然后这里的话我也去攻略了一些风险资料,然后这里的话也给大家放了几个案例,可以参考一下。这里的话点击可以查看一些详情,这个的话我也不具体做介绍了,大家有兴趣的可以去看一下,因为这里的话比较简单,具体的话可以去搜索一下啊。 在整个实操教程之前,我们可以先来看一下效果。好吧,当前我是把我部署的龙虾项目关联到我的 t t 上面的,我们可以来简单看一下。这里的话可以看到我简单问了一下他是谁,我们再来问一下他能帮我做什么。 ok, 我 们这里看到他做了一个回复,然后告诉我们他能做很多东西。然后这里我们可以看到我这里测试的话是英伟达最新发布的这个 gm 这个模型,新模型,然后本期教程的话也会用英伟达的免费 a p i 来做一个教程分享。 ok, 这里我们可以看一下。当前我是部署在我本地的一个讯影机上面,我讯影机安装的话是乌斑图的一个系统, 大家可以参考我这个方案,当然了这个迅影机的话是随便你可以安装到哪边,我的话为了方便直接通过本地的迅影机软件安装,你可以安装到任意闲置的电脑上,设备上都可以, 好吧。然后整个迅影机的部署和安装的话,大家可以参考之前的一些教程,我这里都有给大家放相关的链接。最需要注意点的是欧奔卡拉官方源的话,他可能需要一个网络的需求, 所以这里在很多的教程中,我都会给大家提到一个软路由的东西,这个的话是非常建议大家去做一个部署的, 可以解决到很多情况下的网络问题,这里整个环境的部署我就不过多做介绍了,好吧。然后我们虚拟机部署完成之后,我们只要通过我们 ss 软件去连接它就可以了,这样的话整体的操作会方便很多, 因为本次教程的话主要是以安全为主,建议大家在驯养鸡或者当客中去运行,这样的话可以做到一定的隔离, 不建议大家在自己的主服务器或者说生产环境中去安装和使用。然后这里讲一下最新版本,我们刚刚看到的二点一三的最新版本,它目前的话是有一个比较严重的 bug, 就是 你最新版本无法去选择对应的一个模型, 它是缺少这个引导流程的,但是我们可以通过手动修改配置文件来添加模型来使用。然后下面的话我就给大家来实操演示如何来去安装。好吧, 因为目前我这个服务器上的话是已经安装了,所以我先给大家演示一下如何去卸载,好吧,我们拉到最下面,我给大家放了一些常用命令,我们通过这个命令可以先来做一个卸载,我们在这里复制卸载命令, 然后这里的话会选择一些我们安安装的东西,我们直接回车确认就可以了。 ok, 它这里的话基本上就已经卸载完了,但这里我们可以看到 c l i 这个东西仍然安装着,对吧?然后我们通过这个命令来把它删掉,我们来复制这个命令来删除这个 c l i, ok, 删除完成了,对吧?然后我们回到最开始,我们来重新安装它,我们复制这个官方的命令,这个是快速引导安装的一个命令啊。 ok, 这里的话他就开始安装了,但这个的话是安装的最新版本,可以看到吧? 我会先安装最新的版本,然后来教大家如何来修改这个配置文件,然后正常的使用我们的模型。最后的话也会来教大家如何来更新和回滚到一个指定的版本, 这样的话我们即使更新到了最新的状态,发现了问题之后,我们还是可以回滚到老的版本继续使用。好吧,这整个过程的话可能会比较慢一点,大家要耐心的等待一下。 a few moments later, ok, 这里可以看到我们已经安装完成了,然后它自动跳到了一个引导模式,对吧?进入引导命令之后,第一项是风险提示,对的话我们必须要确认这个,我们已经知道了这个风险,然后手动确认 yes, 然后回车, 然后进入一个快速开始,然后这里我们可以看到它是直接进入到了我们的渠道选择,并没有进入一个模型的选择,对吧? 正常的流程是应该宣让你选择一个模型提供商,但是这里没有,那我们先不管 当前这个渠道的话,大家根据自己的去选择就可以了,然后本期教程的话,我以这个梯机为例,好吧?然后我们直接回车,这的话我们也可以先不设置,我们先跳过,因为我们后面还是要重新设置一遍的,因为我们要修改一下配置文件,我们这里先跳过好了, 然后这里的 skill 的 话推荐,这里虽然是推荐,但是不建议大家来安装,我们即使选择这里的默认推荐之后,这里还是可以跳过的,我们直接选择跳过就可以了。然而这里的相关的 key 的 话,直接默认 no 就 可以了,这里的钩子的话也默认跳过, ok, 这里的话也默认去孵化, 这样的话基本上整个部署就部署完成了,但是我们因为没有选择一个模型,对吧?它这里是没有任何的信息的,都是不知道的,对吧?现在的话我们就要去修改我们的配置文件来让它可以选择一个模型, 这里的话我们就需要下拉到我们这个配置文件,这里默认的配置文件的话都是在这个路径下面,我们可以通过我们的软件直接去访问它的一个配置文件,你也可以手动通过这个命令 来去修改。这里的话我们重新打开一个,然后进入这个文本编辑的命令,我们回车,这样的话就会进入到我们当前的一个配置文件里面, 大家有看到吗?但是目前的话是默认模式,我们不可以编辑,我们必须进入字母按,大家可以看到这边可以进行修改了,是吧?我们但是这里面修改的话不太方便,我们这里如果你修改完成之后按 esc, 然后退出编辑之后我们冒号 q 就 可以退出了,如果你正常保存的话就是 wq, 好 吧,这只是给大家做一个操作演示。然后我们这里为了方便的话,我们通过这个文件直接来修改,这里的话我可以直接双击它,在本地打开它。 这一打开文件之后,我简单给大家说明一下,我们重点需要修改这个 a 帧子。还有一个 model, 这里因为新版本 bug 的 问题,我们看到我们找不到 model 这个关键词,是吧?这的话我们直接可以通过伯克里给到的一个模板来去进行一个修改,我们直接复制这一个 model 一个模板, 然后我们直接在这里回车粘贴一下就可以了。这里的话注意一下这里的 api key, 我 们需要修改为自己的一个 key, 好 吧。然后这里模型的话,我这里默认给大家配置了 k 二点五和这个 gm 五, 但是因为新版本无法去选择一个模型,那我们这里不能放两个,这个两个的话可以在后续正常选模型的时候我们再去放进去,所以我们这里先要把另一个删掉,我们先删掉这一个这里的逗号,如果不小心删掉了,记得加上去啊,不然会有语法错误,这里要注意是英文逗号。 然后我们下面把 ages 改掉,我们也直接通过这个模板来修改就可以了,我们直接复制,然后改掉它。这里的话同样要先把这个模型给删掉, 然后这里的话我们还要做一个修改,我们要把它这个固定锁定它统一改成这一个格式, 这样去修改的话,我们在当前这个有 bug 的 模型中就可以正常的去使用这个模型了。这里刚刚报错了,我刚才把这里的括号多删了,然后我们重新复制一下,改一下 它这样的颜色才是正常的,然后我们重新把这个删一下,我刚刚把这个多删了,现在这个应该是正常的,我们重新保存一下, 然后我们重新上传一下,我们重新打开一个 执行这个命令,我们重新进入引导试一下。 ok, 现在正常了,我们重新进入引导,这里的话就快速操作一下,然后这里的话我们需要配置一下梯机, 这里的话我们跟着我们的这个步骤,然后去获取到它的一个 talk。 这里大家注意一下,不要用到一个假的机器人,一定要认准这个官方的提示,然后它这里的每月用户活跃数一定要匹配上,好吧,一定是这个很多人的。 然后我们这里正常进入一个创建一个新的机器人,然后他会让你输入一个命名,然后这里的话不能重复,最后的话他会输出一个 api 给你,然后我们直接点击这个复制就可以了,然后我们粘贴到这里面,我们直接回车, 回车之后这里的话我们直接忽略,然后我们直接跳过,然后我们重新 这里的话还是默认。 ok, 这里完成之后, 我们把这个之前的关掉,我们这里再重新打开一个界面,然后我们要回到机器人这里,我们回到机器人之后要进行一个 start 操作,我们要授权一下,我们输入 start, 然后他会给你一个授权码,我们直接去运行这个授权命令,我们复制一下粘贴, ok, 这里的话就授权成功了,然后这里我们再重启一下网关, ok, 重启成功,我们再回到这个界面, ok, 我 们可以看到当前的模型已经识别成功了,对吧?然后我们尝试在这里发个消息, ok, 它这里就可以正常的回复你了,那说明我们这个就部署成功了。 ok, 到这里的话就是整个最新版的一个部署就完成了。下面的话我来教大家 如何来去回滚,以及在正常的模式下面我们如何去配置我们的英伟达的 api, 然后可以做一个模型切换的一个操作。 ok, 这里的话我们需要用到我们的一个回滚命令,我们直接来复制它,我们直接来执行这个命令, 因为这一个版本的话是我昨天测试的时候是正常的,所以我们直接回滚到这个版本就可以了,我们直接回车, 这整个回滚的话基本上跟安装差不多,所以我们也要等比较久的一个时间。 a few moments later, ok, 这里的话我们可以看到这里的话已经更新完了,整个更新的话基本上就相当于重新安装了一次,然后我们重新进入引导模式,看一下, ok, 这里的话他就正常的进入了,我们选择模型的一个键面,对吧你如果你是对应这里面的提供商的话,你去选择对应的去 使用你对应的 key 就 可以了。但是我们这边英伟达的话是不在这个范围里面的,所以我们这里直接点击这里跳过,然后我们可以在这里面找到我们配置的英伟达的选项,我们往下拉一下,这里看到我们配置的英伟达的一个模型, 这可以看到我们这里配置了一个 k 二点五,对吧?那我们直接回车就可以了,然后这里的 t g 的 话还是原来的 t g, 所以 我们不用去改它,我们直接跳过,然后这里还是跳过也跳过,然后我们直接重启就可以了, 这些操作的话跟之前的操作是一样的,没有问题,但是我现在给大家看一下如何去放多个模型,好吧?我们这里可以把之之前的关掉,先 让我们回到这个配置文件,我们仍然打开我们的簿刻,然后把我们这个复制进来, 我们把这个一整个替换, 然后把这个也一整个替换, ok, 直接保存,然后这里重新上传一下,然后这里我们重新打开一个窗口,然后执行我们的一个引导命令, 我们这里还是选择我们的英伟达,这也可以看到有两个模型的,对吧?然后这里我们选择我们刚刚新配置的一个 gm 的 模型,我们选择它,然后这里应该配置过了,我们直接跳过就可以了, 对,全部跳过,然后重启一下, ok, 这我们可以看到它的模型已经切换到 gm 了,对吧?然后我们尝试问一下这个机器人它当前的一个模型, 这里的话可能是当前这个模型用的人比较多,所以我等了一会他才反应过来,这是他回复过来的,然后我再问他一下, 这我们可以看到这里的话是同步的,它会在这里输出完成之后再反馈到我们这个窗口这里来, ok, 它把这里所有的信息都反馈到这里,大家可以看到,是吧? ok, 到这里的话整个 部署就全部完成了,然后也能去正常的切换模型了,是吧?然后我们也可以正常的去使用英伟达的一个免费 api。 最后我再提一下这个英伟达的免费的 a p i, 因为它的算力是共享的,所以当用的人多的时候肯定会出现比较慢的情况,那这个我在之前提过了,只适合你用来做一个尝鲜的使用,不适合你去做一个生产环境的使用,好吧? 另外在整个部署过程中,如果涉及到其他的相关操作命令的话,大家可以通过这个链接直接到官方的一个文档去做一个参考,好吧, 这里的话有官方详细的一个教程说明,这里的话可以切换成中文,然后这里的话有很多的教程文档,大家有什么问题都可以到这里来找一下,好吧? ok, 那 今天的教程基本上到这里就结束了,如果你觉得这些视频对你有帮助的话,记得一定要给这个视频点赞、评论、转发,好吧,最后如果你还没有关注我的话,一定要盯我的频道哦,那今天的视频就到这里,下期见,拜拜。