粉丝2.4万获赞4.5万

相关视频

02:02查看AI文稿AI文稿

02:02查看AI文稿AI文稿下面呢我们用了这个大地的论里头的这个数据的划分,把这个百分之三十的数据用来做训练,百分之七十的数据呢,百分之七十的数据用来做训练,百分之三十的数据用来做测试, 然后用了做逻辑回归啊,用的 l i 的一个政策化默认是 l 二啊,也就是有他没他都一样,不用这个参数一样,那么得到的 这个结果呢?是这个逻辑回归呢,他的这个在训练级上的这个评分是百分之八十五,也就会有百分之八十五的准确率,在这个测试题上有百分之八十二的准确率, 那么这同样的这个是近零分度啊,那么这个是在训练体上是百分之八十六七十九啊,下面这个呢是 svm 里头的 fsvc 在春运上面的话,相对来说表现比较好,百分之百预测准确,但是呢他在测试题上呢只有百分之八十三的准确率, 下面这里呢是这个这个随机森林, 随机森林,那这个呢就是呃,在测试级上百分之九十九,在训练级上呢,在在训练级上百分之九十九,在测试级上百分之九十三。 那么从这四个模型上来看的话,这个模型啊,也就是随机森林这个模型的话,他的整他的测试题上的准确率是最高的啊,百分之九十三的准确率,那么我们一般情况下这个训练模型呢,都是使用这种测试题来看他的评分的好坏。那么接下来呢,我们把这个图 做了一下考试化, 那么这个是三种模型在训练级上的一个评分,我们从这个图上能看得到这个随机森林和 svm 都是比较高的, 这个呢是在测试机上我们能看得到这些森林是明显高于其他的。

07:26查看AI文稿AI文稿

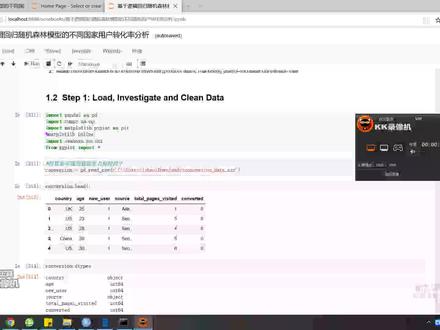

07:26查看AI文稿AI文稿大家好,今天我所要给大家介绍的案例是记忆逻辑回归森林随机森林模型的不同国家用户转化率分析啊,我所用的软件是丘比特。首先我们把数据加载到数据框, 我们可以看一下他的数据是有大有国家年龄、新用户啊,以及来源氛围、广告和出生引擎。 我们看一下这个数据有呃,三十一万六千两百行六例。 那我们检查一下是否有任何控制,嗯,发现并没有找到控制。然后我们检查一下是否有奇怪错误的数据,我们也可以看到他的年龄大于七十九的数据,有两个是一百二十三和 和一百一十一,而与三十多万的数据点相比只有这两个,因此我们可以删除这两条记录,就是年龄大于年龄为一百二十三和年龄为一百一十一的数据,我们再检查一下是否已经删除了, 我们可以看到他变成九十八了,确实少了两个。嗯,然后我们再做一下可视化分析,就是新老用户的可视化分析,我们可以看到老用户是三十多万,而新用户是一呃一万,明显是老用户比较多。 我们再做一下国家的转化率分析,我们看到中国的转化率是百分之零点一啊,可以看到他的转化率相比其他三个国家是非常低的。通过可视化也可以看到, 我们看一下每个国家的用户总数,其中中国是七十六万,德国是一万啊,十三万啊,我们看一下啊,每个国家的用户转化数啊,中国的是一百零二,是非常少的。 然后我们做一下图,也可以看到中国的转化率是比较低的。嗯,然后我们再看一下那个通过建一下回归模型 啊逻辑回归,它是一种机器学习分类算法,适用于预测分类因变量的概率。然后在逻辑回归中, 应变量是包含编码为一或零的数据的二次二元变量。那我们首先第一步是 是嗯导入模型,然后将数据拆分为训练级和测试级,训练级用于训练阶段,然后测试级适用于呃验证阶段,然后模拟你和你和模型,然后预测训练级, 然后我们看一下他训练呃训,看一下他的准确性是百分之九十八点六,然后我们再测试一下精度也是百分之九十八点六,然后训练精度训练记录是百分之九十八点六二, 然后得到一个呃模型,我们看到他的那个德国、英国和美国的国家的转化率更高,然后随着年龄的增长,他的负就是转化率下降,然后新用户的转化率更低,也是负的。然后我们加插啊 交叉验证,交叉验证是为了避免过度离合,我们用十倍交叉验证来训练我们的逻辑回归模型,我们可以看到他的呃进入能量是百分之九十八点六二, 我们可以看到平均进度仍然十分接近逻辑回归模型的进度。也就是说我们可以得出结论就是我们的模型翻化的很好。然后我们再混淆啊,我们看一下混淆矩阵,就是 嗯,他的这个表示,因为他有九呃九万一千四百八十八,也就说九有九万一千四百八十八个未转化的被预测为未转化,有九百六十五个转化了的仍然被预测为未 转化,就是说呃,九六五和三五八,他是错误预测,九幺四八八和二零四九是正确预测。 那我们再计算一下精度、抓回率和他的支持率,我们看到精度啊,平均精度是零点九九,他抓回率也是零点九九,然后他的,嗯,支持也是啊,支持有版,嗯。 然后介绍完逻辑回归,我们再介绍一下随机森林吧。随机森林算法是一种骑车分类算法 啊,我们选择随机生理的原因是因为他可以需要很少的时间来优化,然后对于一场直,他的不相关变量连续性和第三变量,他很强大,比较强大。 首先我们第一步是加载随机森林分类库,然后我们让随机,我们让随机数有预测性,我们出现相同的一种数字, 然后我们呃查,然后我们就是计算训练分的期的准确率,我们看到百分之九十八点三五和逻辑回归比逻辑回归的百分之九十六点要低一点。然后我们 同上楼,同逻辑回归一样,我们也是做一个交叉验证,可以看到他的版平均得分非平均准确度的,他的得分非常接近于模型, 也是十分好的。然后这个混淆体重也是一样的,比如说有个十百千,有九万、一千、两百九十万 五个和两千零三个数据是正确预测,然后一千零五十九个和五百零三个数据是错误预测, 然后我们也得到了一个分数,我们可以看到他的同那个逻辑合规是一样的,就是德国、美国和英国,他的转化率比较高, 然后这个随着年龄的增长,他的,嗯,他和逻辑回归不一样,随着年龄逻辑回归是复数,然后随机生灵是随着年龄增长,用户转化率变高。 然后我们再,我们再就是预啊,预测一下新的, 我们稍微改变一下权重,我们也可以看到他的新的模型 和旧的模型 就是他的,就是他的那个访问的总页面是不一样的,访问的总页面是零点,旧的模型是零点八零,新的模型是零点零零五六。 最后我们可以通过逻辑回归和神经随机生理模型都是一个总结性的阶段。就是 啊该网站的年轻用户具有较高的转化率,比如说年龄比较年龄比较小的,还有就是德国的转化率最高,但是他的人口是最少的,以及现有用户的转化率要高的很多,还有中国的转化率极低,好了,我们就是我的。

8数苑统计 02:23查看AI文稿AI文稿

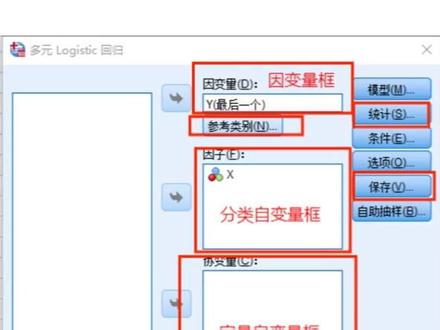

02:23查看AI文稿AI文稿sbss 操作步骤讲解系列第二十六课多元 logistic 回归分析 在实际研究中,因电量可能不是二分类数据,而是三个或以上分类数据, 因此引入多元 artistic 回归分析。而又因分类数据是否为有序的分类变量使用的分析方法而不同,本次讲解多元无序 logistic 回归分析的操作步骤基本要求和二元来 dr stick 回归分析相同。 第一步,先将整理好的数据导入 spss 中并复制后点击分析回归多元 artistic 回归。第二步,将对应的变量放入对应的变量框中。 定量只连续型随机数值数据,点击参考类别勾选参考类别位置。第一个类别只选项副职阿拉伯数值最小的最后一个类别只选项副职时阿拉伯数值最大的 定制指指间指定对应的参考类别,对应的数值点击继续。确定。一般来说,只需设置参考类别即可。若需要看你和优度结果,可以点击选项勾选红色框标记里的选项,点击继续。 如需要看估算响应预测实际概率,可点击保存勾选红色框中的选项,点击继续。然后多元无需 artistic 回归分析的个案处理摘要模型, 你和姓习位二方自然比检验参数估算指表结果就出来了。 将参数估算指表结果粘贴复制到表格中进行整理,将致信区间的上下限部分及参考类别项部分内容去除。也可将模型拟和信息中的负两对数自然值卡方根据显著性标记星号 放在整理好的表格下方后,将整理好的结果粘贴复制到 word 中进行表格的制作和文字描述。 学会了记得点赞关注哟,可带座指导学习交流!

583艾吖法数据 06:12查看AI文稿AI文稿

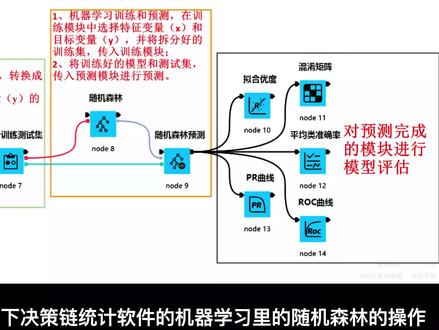

06:12查看AI文稿AI文稿这个视频我们讲解一下决策链统计软件的机器学习里的随机森林的操作。所用的视力表样本量为一百零四万八千五百七十五个样本,一共十七个变量, 十一个特征变量,一个分组变量,一个目标变量。目标变量是字符串形式,需要转成零和一的数字。首先我们拖入导入数据的节点,数据表为 c s v 格式,选中节点右边参数设置中导入数据表, 运算此节点。导入数据表 模块计算结果中预览导入的数据表, 由于目标变量是字符 穿形式,需要转换变量,投入雅变量转换,设置雅变量转换的参数 设置完成运行子节点,预览节点运行结果。 机器学习首先进行数据级的拆分, 设置数据及拆分的参数,这里是设置零点二,即百分之八十为训练级。设置完成运行此节点。 拖入随机森林节点。拖入随机森林预测节点。 连接节点,注意连接节点位置不能连错,此步骤是将训练级和测试级分开,导入下一步节点。 随机森林节点设置参数,选择好目标变量及特征变量, 参数设置完成运算此节点。 开始拖入模型评估的各个节点,这里选了混淆矩阵、拟核优度、平均类准确率、 p r 曲线、 rogue 曲线。 连接好各个节点, 在连接节点时注意鼠标状态的切换,节点的连接需要转成连接器状态。 开始设置节点的参数,此时我们发现变量选择中多出了几个,这些多出的变量就是上个节点得到的参数,是为了提供给模型评估所用参数设置完成 运行此节点,并查看相应评估结果表。 好啦,我们的机器学习随机森林就做完了,可以参考交互式总结报告的视频讲解,形成完整报告了。

08:28查看AI文稿AI文稿

08:28查看AI文稿AI文稿拓端 tectacter 语言逻辑回归 logistic regression 回归决策数随机森林信用卡违约分析信贷数据集原文链接, tecdac c n 二三三四四在许多网站上都可以找到一个流行的德国信贷数据及 german credit, 其中包含了银行贷款申请人的信息。该文件包含一千名申请人的二十条信息。下面的代码可以用来确定申请人是否有信用,一 及他或他是否对贷款人有良好的信用风险。有几种方法被应用到数据上,帮助做出这种判断。在这个案例中,我们将看一下这些方法。请注意,本利可能需要进行一些数据处理,以便为分析做准备。我们首先将数据加载到 r 中 一 credit read cisco credit head control zip 这段代码在数据上做了一个小的处理,为分析做准备,否则就会出现错误,因为在某些文件的某一列中发现有四类因素, 基本上任何四类因变量都被覆盖为三类。继续进行分析。快速浏览一下数据,了解一下我们的工作内容。你可能会立即注意到有几个变量很显眼。我们要排除他们信贷期限,月信贷金额和年龄。未 什么。我们在这个模型中试图把重点放在作为信用价值指标的数据分类或类别上,这些是分类变量,而不是数字变量。申请人有电话吗?申请人是否已婚?是否有共同签署人?申请人在同一地址住了多长时间这类 事情。关于这些因素,重要的是我们知道他们与贷款决定的关系。良好的信用与某些因素的组合有关,从而使我们可以用概率将新的申请人按其特征进行分类。在数据中,这些问题的答案不是事,或不是,或十年答, 答案被分组为更广泛的分类。我们需要做的是删除真正的数字数据,时间,金额和年龄。保留分类因素。我们排除,选定列。然后我们创建一个简短的函数,将 整数转换成因子。现在我们有了有用的数据,我们可以开始应用不同的分析方法。方法一,逻辑回归 logistic regression 第一步是创建我们的训练数据及和测试数据级。训练级用于训练模型,测试级则用于评估模型的准确性。 我们把数据及分成任何我们喜欢的大小。在这里,我们使用三分之一,三分之二的分割。在这个阶段我, 我们将使用 gri 函数进行 logistic 回归。在这里,我们有选择 d 使用模型中的变量,但现在只是用五个变量来确定信用度的值。完成后,我们继续将我们刚刚创建的模型拟合到测试级 it is 衣上,并准备进行第一次预测。我们已经拟合了模型。现在我们将使用 rocker 包来创建预测,并以曲线下面积 aix 来衡量性能。 iac 越大说明我们的模型表现越好。 1 perfe performance pride 一 tph fpl 让我们描绘一下结果。我们将通过寻找。哎呀,看来结束这一部分。这不是一个造 高高的结果,但让我们看看是否可以用不同的方法做的更好。方法二,另一种 logistic 模型。在这种方法中,我们将建立第二个 logistic 模型来利用我们数据集中的所有变量,其步骤与上述第一个模型相同。一, perf performance pride r, k, p, s, p, l, r, plate per of r 包括所有的变量。我们并没有得到多少改善。一个好的规则是尽可能保持模型的简单,增 更加更多的变量会带来很少的改善,所以坚持使用更简单的模型。方法三,回归数接下来,让我们试着用回归数的方法来分析数据。我们的大部分代码与上述逻辑模型中使用的代码相似,但我们需要做一些调整。请再次注意, 我们正在研究我们模型中的所有变量,找到他们对我们感兴趣的变量。信用度的影响, 1 tree model apart credit ability litter credit a calibration 1 二 library apart plat 三, pro trimado type 二, extra 一 1 perf 三, performance breed 三, tpl, epf 二, platform 三考虑到我们的树状模型的复杂性, 这些结果并不令人满意,所以我们不得不再次怀疑第一个例子中更简单的 logistic regression 模型是否更好。 方法四,随机森林与其建立一棵决策树我们可以使用随机森林方法来创建一个决策树森林。在这种方法中,最终结果是类的模式。如果我们正在研究分类 模型或预测的平均值。如果我们正在研究回归随机森林,背后的想法是决策数很容易过度。你和所以找到森林中的平均数可以帮助避免这个问题。你可以想象这 比创建一颗决策数在计算上要求更高,但 l 可以很好的处理这一工作。通过努力,我们得到了一个有点改进的结果,随机森林模型是我们所尝试的四个模型中表现最好的,但是这需要判断结果是否值得付出额外的努力。 方法五,比较随机森林很 logistic 模型好了,我们已经看了使用两种基本分析方法的各种结果,逻辑回归和决策数。我们只看到了以 alc 表示的单一结果。随机森林方法要求我们创建一个 决策数的森林,并取其模式或平均值。为什么不利用所有这些数据呢?他们会是什么样子呢?下面的代码创建了一个图表,描述了我们的随机森林中每棵树的 ax 分数和逻辑模型的数百种组合。首先,我们需要一个函数来进行分析, 一, function 二, it is simple 一 and raw credit says 三百三十三三, summary logistic model 三 四, fitlock some product logistic model 三, top response new data credit it is 二,这部分代码的运行需要一段时间,因为我们要对数百个单独的结果进行列表和记录。你可以通过改变 valse 对象中的技术来调整模型中的结果数量。在这里我们选 选择计算两百个 x 一对或四百个单独的结果。你可以看到我们从前四个模型中得到的结果正好处于分布的中间。这为我们证实了这些模型都是有可比性的。我们所希望的最好结果是 i a e c 达到 084, 而且大多数人给我们的结果与我们已经计算的结果相似,但是让我们试着更好的可视化。首先,我们将对象转换成一个数据框架。我们创建几个新图,第一个是密度等高线图,第二张是高密度等高线图,给我们提供了数据的概率区域。一 with aid box plot f e e v i r。 无论我们以何种方式描述我们的结果,都必须使用数据来做出合理的贷款决定。这里有一个问题,这些可能是我们使 用这些模型所能得出的最佳分数。但这些结果对于确定贷款申请人的信用价值是否可以接受,这取决于贷款机构所使用的信用标准。在最好的情况下,看起来我们的模型给了百分之八十二的机会向良好的信用风险提供贷款。对, 对于每一百万元的贷款,我们最多可能期望得到八十二万元的偿还。平均而言,我们预计会收回大约七十八万元的本金。换句话说,根据我们的分析,有百分之七十五到百分之八十的机会重新获得一百万元的贷款。 这取决于我们使用的建模方法。当我们把贷款申请人加入我们的数据库时,如果我们要把他们视为良好的信贷风险,我们希望他们聚集在高密度图的最暗区域。 除非我们收取大量的利息来弥补我们的损失,否则我们可能需要更好的模型。

11拓端tecdat 03:28

03:28![机器学习集成学习之随机森林原理 随机森林本质上是基于决策树的Bagging集成学习模型,因此,随机森林的建模过程总体上可以分为3步[3]:

第1步,对原始数据集进行随机采样,得到多个训练子集。

第2步,在各个训练子集上训练得到不同的决策树模型。

第3步,将训练得到的多个决策树模型进行组合,然后得到最后的输出结果。

如图9-2所示为随机对样本点和特征采样后训练得到的若干决策树模型组成的随机森林。从图9-2中可以看出,即使同一个样本在不同树中所归属的叶子节点也不尽相同,甚至连类别也可能不同,但是这也充分体现了Bagging集成模型的优点,通过“平均”来提高模型的泛化能力。 #机器学习 #集成学习 #树模型 #跟我一起学机器学习 #随机森林](https://p3-pc-sign.douyinpic.com/image-cut-tos-priv/e465a338a29d76f72a9c1393084b46cf~tplv-dy-resize-origshort-autoq-75:330.jpeg?lk3s=138a59ce&x-expires=2086488000&x-signature=vJAYO7C1eGqLbYkWmqVDZyaROBU%3D&from=327834062&s=PackSourceEnum_AWEME_DETAIL&se=false&sc=cover&biz_tag=pcweb_cover&l=20260215120431176D99EBD341839B0FA0) 20:1842跟我学机器学习

20:1842跟我学机器学习

猜你喜欢

- 2.1万杰驰电竞