softmax编程教程

粉丝2950获赞9088

相关视频

07:39查看AI文稿AI文稿

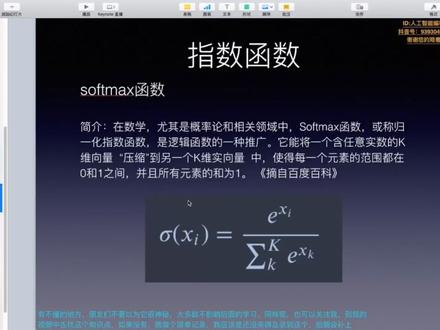

07:39查看AI文稿AI文稿大家好,今天我们来看深度学习 deep learning。 在前面我们讲过,如果对于二分类任务来说,在输出,在输出层,我们可以采用 sigmal 的计划函数来进行变换, 那么如果对于多分类任务,我们应该选择什么样的计划函数?我们今天就来看。 首先看一下实验的该要神经网络,既可以用于分类任务,也可以用于回归任务,那不同的就是根据情况来改变输出层的激活函数。 一般而言,回归问题用横等函数,而分类问题可以用 super max 函数。对于二分类任务来说,我们可以使用 sigma 函数,因为 sigma 函数它反 返回,它的值域可以返回到零到一之间。而如果是多分类任务,我们可以我们一般选择 soft max 函数,我们来看一下,我们先来介绍一下 soft max 函数, 在数学中,尤其是概率论和相关领域中, softback 函数是逻辑函数 sigma 函数的一种推广, 它能将一个包含任意时速的 k 尾项链压缩到另一个 k 尾时项链中, 使得每一个元素的范围都在零一之间,而且使得所有元素之和为一。那么这个特点可以就相当于是将 soft max 的结果认为是一个概率值,所以这样的话, 每个元素就代表了属于某个分类的一个概率之越大,那么概率也就越大,属于这一类的可能性也就越大。所以这就是使用 soft x 来进行多分类任务, 多分人任务的一个原理,因为它可以计算出这个样本属于每个类别的一个概率值, 所以 soft max 广泛用于机学习和深度学习中的多分类任务,那么在深度学习中, soft max 常用于多分类任务最后一层的激活函数, 用于输出某个样本属于某个分类的一个概率值。 softmax 的公式就如下面所示。而我们的 cm 标 我们将使用拍摄来实现 softmax 函数,并且通过数学推理与代码对 softmax 的实现方式进行一个改进。首先我们来 soft max 进行基本的实现,根据我们 soft max 的一个函数公式来进行计算, 给定我们 h, 然后计算 a 的一个 me 方,就是 e 的 h 方,也就是我们需要求解的值, 可以使用 long pad 点 sum 来进行一个求和,所以这些运算都是为了让我们的实现我们 soft max 做准备。然后我们就定义一个 soft max, 使用 python 来定义, 根据上面的公式,我们先计算一个它的 miss 方,然后再计算出它的球和最后再计算它的比值,最后输出的就是 y, 然后是避免 soft max 的一个溢出。上面的 soft max 函数的实现虽然正确描述了 soft max 公式,但是计算机有一个缺陷,它就是溢出。 soft max 函数的实现中会进行指数函数的一个预算,但是其实指数函数的值就很容易变得非常大, 如果这些在超大值之间进行除法运算,结果会出现一些不确定性的情况,所以因为 计算机它的表示是有一定范围的,所以这就造成了一个溢出的问题。我们可以对原始的 soft max 进行一个改进,就如下面这个这样所示, 在分者分母上都乘上 c 这个任意的长数,然后把这个 c 转移到指数函数中, 对它进行一个对数变换计划 rock c, 最后把 rock c 替换为另一个 for c 撇,再进行 soft max 指数函数的运算,是加上某个常数,并不会改变运算的结果,这里的 c 撇就是使用的任何值, 但是为了防止溢出,一般会使用输出信号中的最大值,那么下面就是一个对比的情况。首先实现我们原始的说 max 函数,由于上面的结果太大,我们的指数由于太大,所以它最后输出的结果都是一些缺失指,嗯嗯嗯,没有被正确的计算。那么为了防止 运行上面定义的 softener 函数,也会收到一些警告,就是警告溢出无法返回有效值。 此时如果我们设置一个输入函数中的最大值,注意这里是幺零,幺零,那么重新进行 soft max 计算,它就会计算得到正确的输出。 根据上面的逻辑,重新定 softmax 的拍摄函数并运行,就增加了一个防止溢出的对策。 然后再来看 soft max 函数的一个特性,如下面代表所示, soft max 函数的输出是零到一之之间的时数,并且它们的输出值的之和为一。 输出总和为一是 soft max 函数的一个重要特性,正因为这个特性,我们才可以把 soft max 函数的输出解释为概率。 然后下面的就是计算,看一下 soft softmax 和 sigma 还做了一个对比,因为既然 softmax 是 see sigma 函数的一个延伸,那么我们再对它进行一个对比,首先定义的出 sigma 函数,并将它进行计算, 就得到了外值,这是经过 sigma 函数变换得到的值,对它所以值相加为和进行求和,那么它的值是二点五三,这就不满足我们相加求和为一的这个特点, 所以不能使用 sigma 函数的值来代替这个样本属于这个类别的一个概率值。我们再来看一下 sigm soft max 函数, 我们定以 soft max 函数并计算它的一个概率值,并最后对它的概率值求和它等于一,所以这既然等于一,而且它的值都是零到一之间,所以这个特点就我们可以 使用 soft max 用于多分类任务,这也是对多分类任务使用 soft max 的可行性的一个验证,谢谢大家。

29跨象乘云 59:47查看AI文稿AI文稿

59:47查看AI文稿AI文稿大家好,我是王木头,上一次给大家介绍了体度下降法,没把这个概念介绍清楚,我把原来举例子的神经网络给升级了,以前只能判断单一分类是猫还是不是猫,结果给升级成一下,能判断很多分类。 这个分类到底是怎么升级的,我当时并没有说啊,这个过程其实并不是那么显而易见的,并不是说在苏苏城增加更多的感知机就能做到,他还需要把最后的那个激活函数给换掉,从原来的 siri 的函数换到 super max 函数。 我在去了解骚夫的 max 函数的时候,看到很多地方都在提最大商这个概念,其实通过最大商就可以把四个 boy 和骚特 max 在底层上给统一起来。不止这样啊,了解最大商可以帮助我去了解神经网络,甚至是整个机器学习的本质。 所以这一次呢,我就打算和大家一起来看一看,到底什么是骚夫的 max 函数,什么又是最大商。为什么我会说通过最大商能帮助理解及其学习 短袖 训练神经网络,用梯度下降法,这个优势还是很明显的,他可以少走很多的弯路,同时他的计算形式也相对简单。不过他的劣势也很明显,就是他的计算量仍然非常庞大。所以呢,我就打算继续学习一下,看看大佬们是如何优化和改进梯度下降法的。 其中就有一个方法,就是在隐藏层把隐藏层感知机的技波函数换掉,从原来的 siri 的换成歪六函数。这其实也很容易理解 siri 的函数,如果你的数值恰好是在这一部分的话,那这里的梯度是非常小的,如果这个梯度在反向传播,传播到前面几层,那几乎不剩啥了,这个就叫做梯度消失。 如果换成歪六函数,那就没有这个问题了。歪六函数如果是大于零,这又是一条直线,各个地方梯度保持一致,这个就能避免梯度消失问题。这件事我马 就能理解了,不过心中马上也会产生另外一个问题,那就是 red 函数,他的最大值是可以无穷大的,那我们在训练神经网络的时候,那个神经网络的损失函数,不论是几大死亡不记法,还是交叉商,他都是基于概率的,也就是说最后那个输出值必须是零到一之间才小, red 函数是不具备这个特征的。那怎么办呢? 直接上来看啊,也很简单,就是在最后一层用 ccouny 的,前面用五百六,只要最后一层用了 ccouny 的,那就可以把原来的数值又重新归到零到一之间,然后这个时候再用损失函数也没有问题, 那是不是这样子呢?其实这个可以,但是他还是有一定问题的,那就是如果用 cd 贸易的函数的话,他只能解决一种分类的情况,如果一下有很多分类的话,那可能就要出问题了, 因为四个贸易的函数,他只能解决一个感知机的输出结果归一,他并不能保证多个感知机,也就是多个分类的情况,他们加起来 也归一。就比如说吧,最后判断的结果很可能就是是猫的概率百分之六十,是狗的概率也是百分之六十,那是猫或是狗的概率加起来就是百分之一百二了,这显然不对吗?那怎么办呢?这个时候就是骚特 max 出场的时候了,其实继续使用 c 跟贸易的也不是不行,关键是要看最后的任务是什么, 如果最后的任务就是给动物分类,这种结果是护翅的啊,是猫了就不能是狗。是这种情况的话,那还就是要用骚的 max。 那如果是另外一种情况,就比如说我的视频上传到网站了,需要给我的视频打标签,那这个标签就不是唯一的了,他可能既是知识类的,又是一个人讲的,又是寄送知识的等等等等 这些要想给做出分类来,那用骚特 max 就反而不合适了,可能还是要换回 sumory 的。所以啊,不要看到是一个多分类问题,就马上用骚特 max, 具体还是要看情况的啊。那说了这么多了,到底这个骚特 max 是什么样子的呢?为了能解释清楚什么是骚特 max 这个函数, 我们需要回忆一下之前讲的只有一个感知机的时候是什么样子的。这个是当一个神经网络,他的速度层只有一个感知机的时候,我们可以这样来表示, 其中这个 z 啊,就是那个限行计算的结果,然后通过激活函数运算之后得到一个 a, 在这可以看到啊, l 代表的是他第几层,在这 l 就代表的是输出层, k 代表的是训练级里的第几个数据。如果按照我们之前的那些例子来说的话,那其实就是这个一二三 m, 这这个 k 具体代表的是那个哪个图片这里得到了一个线性结果,通过机构函数计算之后啊,通常也就是这个贸易的函数得到的是一个 al, 这个 al 呢,因为是在零到一之间,所以说我们就可以把它看作是一个概率,也正是因为有了这么一个概率,我们才能把它拿过来,不论是用交叉商还是说 和他等价了极大私人估计法,把它看作是一个概率之后,比较两个概率分布之间的差别,然后创建一个损失函数。这个损失函数我们前面讲了两期,这就不再详细讲了。其中这个外呢,其实就是对这个训练的数据进行人工的打标签, 判断他到底是猫还是不是猫,是猫是一,不是猫是零。这个是我们之前介绍的只有一个感知机的情况,那现在需要把它扩充了,不是一个感知机了,在输出层有多个感知机就变成了这个样子。 其实这个式子还是不变的,只不过这里的每一个 z 和 a 就变成了一个项链, z 他其中有一二三四,一直到 i 有埃个分量,每一个呢,其实对应的就是一个感知机, a 也一样。那这这个计划函数呢,就不能随便用这个 mory 的,我们这一次讲的是 supremex, 其实 也就能知道这应该是骚夫的麦克斯,不过我们的目的是学习骚夫的麦克斯,现在我们就假设不知道这是骚夫的麦克斯, 我们只把它看作是一个激活函数,只不过这个激活函数他有一些条件,当满足这些条件之后,看看他是什么样子,是不是和骚夫的麦克斯是一样的。那这个激活函数他应该满足什么条件呢?我们可以来看一下。 首先他应该表示的是一个概率,这个应该是非常确定的,因为只有当他是一个概率的时候,才能放到损失函数里面进行比较,也就是我们前面讲的交叉商或者是吉达斯兰估计法才能被用起来, 但是他用了方式呢,又和之前不太一样了。为什么这么说呢?可以看到啊,以前的外他就是一个值,要么是零,要么是一,但是现在外他对应的是多个分类的结果,所以说啊,他应该是一个限量了,每个限量的分量 代表的是一个分类,一代表的是猫,二代表的是狗,三代表的是鸭等等等等。而他具体的值呢,应该是这个样子的,如果是猫的话,那猫是一,其他都是零。如果是狗的话,狗是一,其他都是零, 这是人工打标签打出来的,那同样经过激活函数计算之后, a 也应该是对应的一个项链,这个项链里的每一个值他代表的是一个概率, 那是概率的话,那我们其实就能知道有两个条件了,第一个就是概率的值必须是大于等于零的,第二个是所有这些分量的和应该是等于一。 第一个很好理解啊,概率不能小于零。第二个他等于一,他其实就代表了任何一个图片,或者说一个数据输入给神经网络,他都应该有一个分类,不论他对和 错啊,他都应该有一个确定的分类。所以说把每一个分类的概率都加起来,那他就应该是百分之百会发生的事,那就是一吗? 现在我们根据这一个条件,他应该是个概率,其实就能知道两个条件,第一个他应该是大于等于零的,第二个等于一,那这个又能带来什么结果呢?我们可以一个一个的来看啊。 我们先来看第一个 a 是怎么得到的,是通过类进行计算的,对吧?而那个线性计算的结果,他是可能从富无穷到正无穷的, 我们需要把它再重新转化一下,投射成至少是一个大于等于零的范围。那这个其实马上就能想到啊,用 evd 将 z 作为 e 的指数,这样计算的结果,他的定义欲是富无穷到正无穷,但是他的值欲一定是大于零的,当然这就没有等于零的情况啊, 不过没有关系,这里问题不大,所以说啊,在这就可以把 e 给引进来了。那我们到这能把激活函数就看成是这个样子吗?对 z 的每一个分量进行这样的计算以,然后以 z 的值为指数,如果只是这样子的话,那其实他只能满足第一个条件,他没有办法满足第二个条件。 所以说啊,只是这样的话,在这个计划函数是不成立的,我们还需要继续转换。那这一部分呢,只能把它当做是一个中间过程,我们可以把这个函数设为 t, 这里每一个计算结果呢, 看作是一个 t 的项链, t 对应的是它,然后依次往下, ti 对应的是这个,那怎么对它进行一个归一处理呢?其实也很简单,就是把它当做分子,所有分量的和作为分母,那这样子计算出来的这的一个分量一定是小于一 大于零了,而且呢,所有分量相加,就等于所有分子相加,然后再除以分母,那分母等于什么呢?分母就等于所有的分子相加,那就是等于一,所以到这就可以看出来了,这这个函数就能作为多个分类的激活函数, 那他是什么?他其实就是 soft max, 所以说到这呢,这个 soft max 还是非常好理解的,他其实就是为了满足他是概率那个条件,他既要大于零,又要等于一,满足了这个最低条件,那 super 的 max 就可以被当作是一个概率了。当然最后那个损失函数他也要有一些相应的变化。 大家还记得之前讲的那个交叉商吧,这个就是交叉商的计算公式,本来呢是由我们计算出来的一个概率和标签里的那个值进行交叉商运算,算的结果,数值越大就代表两种概率模型相差大, 数值小代表两种概率模型的相差小。之前只有一个分类的时候,这个还比较简单,现在呢就相当于是每一个分量都要单独的进行这样的计算,哎,也就是这一部分,然后再把所有的训练数据再统一的进行这么一次计算, 最后加起来就是整体的损失函数,可以看到这个比只有一种分类的那种情况呢,多了一层这样的循环,这个循环就是把每个分量都进行这样的计算。好到这这个骚分 max 我们其实就能算是理解了, 如果你去了解的话,你肯定也都听说过稍后的 max, 他其实就是一个扩大版的 ccouny 的,他们之间到底有什么关系呢?我们其实也能来看一下,我们可以看啊, ccoune 的,他的计算公式呢?是这个,这个直接看可能还看不出来,没关系,我们可以把它变个形,变成这个样子,得到了,是 他,这个其实就眼熟了啊,这个是分子,这个是分母,是不是跟骚夫的麦克斯很像?只不过骚夫的麦克斯他的分类很多,这呢只有两种情况,其中有一个情况他还不会变化, 如果我们把它看作是 t 一,它看作是 t 二,就是这样子, t 一 t 二, t 等于这个, t 二等于这个,那是一个默契的,它其实就是只有一种分类情况下的。 sofe max, 注意啊,他虽然只有一种分类,但是对于他来说,他其实是包含着两个概率的,第一个是以 t 一为分子,第二个是以 t 二为分子,只不过 t 二这个分子呢,是不会变化的。 我想看到这你应该也能明白,骚夫的麦克斯和这个贸易的他其实就是一回事,只不过是这个贸易的他只能是针对只有一个分类的情况。那骚夫的麦克斯他对应的是可以有多个分类的情况。对于我来说,我看到 到这,我其实心中还有一个小疑问,那就是在这这个贸易的他对应的是只有一个分类, 但是他这计算出来的概率是有两个啊。如果是他有两个感知机,也就是说他有两种分类呢,他应该也是能计算出两个概率来,那两个分类和一个分类,他的差别到底在哪呢? 对于这个问题,我也做了一些功课。哎,这个是只有一个分类的情况,这个是有两个分类的情况。可以看到啊,对于 t 来说啊,都有两个分量,一个是 t 一,一个是 t 二,一个是 t 一,一个是 t 二,只不过是 t 一 t 二的值,他们就有差别了。 对于这来说,他的 t 二是不会变化的,只有 t 一变化。而在这呢, t 一和 t 二他们都会主动变化。也就是说,在计算出来的概率这个方面, 只有一个分类的时候, p 一和 p 二 p 一如果发生了改变,那么他一定是因为 t 一发生改变, p 二发生了改变呢,他不是因为 t 二,而是因为 t 一发生改变。 而对于有两个赶射机,那 t 一和 t 二都是主动改编的那个情况,也就是说,你发现最后计算出来的概率, p 一和 p 二发生了改变,他们对应的这个情况都会对神经网络进行训练。 而对于最后的损失函数,你可以看到啊,这计算这个交叉商对应的是 p 一的交叉商,这计算的交叉商对应的是 p 二交叉商。也就是说,这里这个标签他是猫的标签,那这个呢,就就不是猫的标签, 在这呢就不一样了,这个标签对应的是他是猫的标签,那在这对应的标签就是他是狗的标签。虽然这个计算的结果这个外二他肯定也等于一减外一,因为他不是 猫就是狗吗?但是在意义上,他已经完全不一样了。总之啊,只有一个分类和只有两个分类,他们的计算结果是相差不大的,但是他们背后的意义还是挺不一样的,这一点大家可以仔细再琢磨琢磨。 讲到这,我想你也应该明白了,骚夫的 max 原来就是这个样子的,而且也能明白骚夫的 max 和 cen boy 的他本质上就是一回事。不过 我看到这之后,我心中还是有一些小疑问的,那就是他不是要去构造归一函数吗?那归一函数他有很多方法呀,为什么偏偏选用一亿为例这种做基本元素去构造函数呢?其实当时我没有去多想,就觉得这可能也就是一个巧合,这么构造出来的函数求导更容易,他背后也许并没有什么实际的意义, 可是随着我了解越来越多之后,我发现我当时就是想简单了,在意的背后,他隐藏着非常深刻的道理。之前的视频里我也介绍过,神经网络的一个主要作用就是他能逼近任何一种 概率模型,哪怕这个概率模型我们写不出来,描述不出来,也能逼急。具体的方法呢,其实我们前面也介绍了,就是去寻找四三只最大的那个概率模型,或者说交叉商最小的,反正他们是等价的吧。 也就是说呀,在去逼近目标的时候,我们有一个默认的前提假设,那就是自然之最大的那个概率模型与目标最接近。其实在去构建神经网络和训练神经网络的时候,不只有这一个前提假设, 还有另外一个隐藏的前提假设,只要你的激活函数选择了 sirid 或者 sopl max, 那么这个前提假设就被你默认勾选了,这个前提假设就是最大伤原理。那什么是最大伤原理呢?就比如说你对一个概率问题完全没有什么额外的信息,让你去猜概率,你会怎么猜 啊?就举个例子啊,有八支球队,他们互相之间比赛,哪八支你不知道?让你去猜每支球队夺冠的概率是多少,你会怎么猜?是不是概率评分?每 哪支球队夺冠的概率都是百分之一,那我能不能有另外的采访呢?就比如说第一支球队夺冠的概率是百分之五十,第二支是百分之二十,其他几支都是百分之五, 应该没有任何的法则阻止我这么干,对吧?但是我相信大家应该不会这么去选择,为什么呢?那背后的道理是什么呢?其实你计算一下的话,就能知道第一种猜法,他的伤是更大的, 我的第二种方法最后计算出来的商是更小的。具体商是什么,我这就不详细讲了,如果你对这个还不是很了解,你可以去看一下我前面讲交叉商那一集,在那我把商这个概念已经解释的比较清楚了, 其实不只是第一种选择方式比第二种的伤更大,而是可以从数学上证明,所有的猜测里面,第 一种方式他的商是最大的。也就是说啊,你别看最大商这个词挺专业,挺唬人的,其实还是蛮符合我们直觉的,对吧?或者说啊,最大商他其实是用商这个概念把我们的直觉给证明了。不过如果直接用最大商 的话,那对我们帮助其实没有那么大。就比如说吧,神经网络判断一张照片,他是猫还是不是猫,如果上来就用最大伤的话,那是猫的概率二分之一,不是猫的概率二分之一。你说这有什么用呢?其实神经网络或者说积极学习,他们在利用最大伤的时候,并不是完全无知的去猜的,而 而是在一定的已知事实上再去利用最大商,那这个已知事实就是那个训练用的数据集,训练用的数据集他并不是一个包罗万象的全集,所以说他有一部分是已知的,还有很大一部分是未知的,那这个位置的部分就需要用最大商来补齐了。 就比如说前面的球队,八支球队你完全不知道,那就是八分之一的夺冠概率,但是你已知了一部分信息,就比如说你知道其中一支球队是中国队,中国队夺冠的概率是百分之二,那这个时候对中国队就不能用最大伤了,剩下的那七支,你再用最大伤百分之九十八评分,每支球队夺冠的概率是百分之十四。 当然了,我觉得球队的这个例子呢,还是有些简单的,因为他已知的信息就已经是一个概率了,那神经网络里面可能就比较麻烦了,因为他已知的信息是一堆样本数据,一会那个训练级,所以呢,首先需要拿到训练级的数据,从中归纳出他背后隐藏的概率模型来, 然后再把这个概率模型的特征给挑出来。再然后才是让我们的目标概率模型也具有这些特征。如果只是这样子的话,那就相当于是给了你一对点,然后让你画一个连线,把所有的点都给连上,那这样的画法呢,是可以无数多种的, 也就是说啊,我们的目标函数此刻还是有无数种可能性的,那这个时候就是要利用最大商啊,把商最大的那个概率模型给挑出来,那这样呢?这个概率模型他既能满足已知的信息,又能让未知的信息上最大,到底是懂啊,但是该怎么做呢?其实总结一下的话,这个问题可以分成两部分,第一个部分是解决相同的问题,第二部分是 解决最大伤的问题。我们一个一个来看啊,首先在相同这个问题上就遇到麻烦了,虽然相同这个问题的本质上就是在比较两个概率模型是不是一样让一个概率模型和另外一个概率模型相等。但是现实情况呢,就比较麻烦。前面我们讲交叉商的时候提到过交叉商 kl 散度,但其实可以用来比较两个概率模型之间的差别。 但是问题也在这,在用交叉商或开摇散度的时候,两个概率模型他们是已知的,而现在呢,两个概率模型我们只知道半个,那怎么是半个呢?首先那个目标概率模型我们是不知道的,前面讲损失函数的时候,虽然也提到过有目标概率模型,然后进行对比, 但是那是先拆了一个呀,现在我们连拆还没拆呢,是完全一片空白。再然后,那个被作为盲点的概率模型我们其实也不太清楚,已知呢,是一堆样本数据,还需要从中归纳出背后的概率模型才行。那这种情况下,该怎么让两个概率模型相等呢?那这个就要靠 数学家们,数学家们几百年来对概率统计问题一直有研究,这个问题还是难不倒他们的。所以啊,就需要多介绍一个概念了,这个概念是概率论理的,据, 我们还是从一些简单的概率问题来进行考虑,哎,这个就是正态分布,正态分布可以算是最简单的那一类概率分布了,因为他的特征比较简单, 就是说不论你是什么样子的,只要你是状态分布,那么你一定是有两个东西来确定的,一个就是这个期望,一个就是这个方差, 只要确定了期望和方差,那你这个概率分布的样子就能被描述出来,而且是没有任何信息损失的给描述出来,那我们其实是特别希望任何一种概率分布都能用类似的方式把它给描述出来,当然真实情况里的那种概率分布呢,他们就可能没有正态分布这 简单的形式啊。不过呢,在思考这个问题的时候,还是可以以正态分布的期望和方差作为启发,以这种最简单的情况往下去考虑,看看是不是能找到我们想要的东西。期望和方差,他们等于什么呢?期望如果我们表示成这个样子,这个 x 呢,其实就是一个统计量, ex 就是在求这个概率分布上,这个统计量的期望防差呢,根据定义就是这个值啊,把他们展开以后就能得到这样的一个结果。 哎,可以看到其中的规律啊,这里是 x 的一次,这是 x 二次,然后再减去个 x 的一次。 到这呢,貌似是找到一些规律了啊,一次二次,但是这只有两个式子,让我们去归案的话,还是有点不放心,那我们就可以把这个概率分布做的再复杂一点,哎,变成了他有一定的倾斜,这个倾 整齐的长度呢,其实也可以用偏度这么一个概念来进行描述,偏度的具体定义,哎,是这个样子的,然后再继续把它展开, 就到了这个样子,哎,可以看到其中又有一个关键, x 的三次,这是在这的一个新东西,后面这个四个马,这个六,前面都是已知道了。看到这我们其实心里就有一点想法了,哎,是不是概率分布,他的特征就是和这个统计量的 一次、二次、三次这样,往后四次、五次这个东西有关呢?数学家们经过这么长时间的研究,他们还真的证明了真的是有这样的关系。而且对于这些东西, 他们还给专门起了相应的名称,这个叫一阶句,这个叫二阶句,这个叫三阶句,相应的字就叫二阶中型句, 这是三阶中心句,这个呢叫三阶标准句。具体这这个名字啊,我们不管,重点是看他 一结局、二结局、三结局,如果是一个正态分布的话,他只需要一结局和二结局就能描述出来,如果是更复杂一点,那需要三结局,那如果是再复杂呢?再通过四结局、五结局、六结局也能给描述出来。 也就是说任何一个概率分布,他的特征都可以用这样一个项链来表现。当然到这呢,还是我们归纳的一个情况,具体是不是这个样子呢?数学上他这样子是严谨的吗? 是所有的概率分布都能用这样的方式来呈现吗?哎,数学家们还证明过了,具体怎么证明的,可能就要去翻数学教材了,我这就不翻了,我只是把他的证据 信给你呈现一下。数学家们他们定义了一个函数叫做特征函数,特征函数的第一就是这个样子的,就是 把 b i tx, 这是一个负数啊,这个负数放在里面求期望任何一个概率分布,他们都可以用特征函数给表示出来,而且呢一个概率分布就对应了一个特征函数,特征函数和概率分布是一一对应的,而这个特征函数呢,你只需要把他泰勒展开,就是这个样子, 这个再变化一下,我们就会非常熟悉了,就是这可以看到一次,二次 当当当当,一直到 n 次,也就是说只要这个东西次数够多,那么任何一个特征函数都可以被唯一的表示出来,而一个特征函数他就对应的是一个概率分布,反过来也是成立的一个概率分布,他 都可以找到一个特征函数,那这也就相当于是说,不论你是什么样的概率分布,只要是你这个概率分布存在,那么他一定可以用特征函数的方式给表示出来,只要你能用特征函数表示出来,那么他就可以做泰勒展开, 做泰勒展开之后,那他一定是含有一结局,二结局等等等等,一直到 n 结局,而且还能看到啊,这个泰勒展开呢,他其实是对于这个项链的一个线性关系, 也就是说这个项链的一个线性关系就可以确定一个概率分布他的具体的样子。 那到这这个问题就简单了很多了啊,如果我们知道了一堆数据,这个数据作为样板的话,那这个样板呢?一阶距,二阶距,三阶距,一直到 n 阶距,我们都是可以计算出来的,计算出来的结果呢,又可以把这个概率分布给 唯一的表达出来。那到这我们其实就比较清楚了,如果有两个数据想知道他们两个数据的概率分布是不是一样的,那只需要去比较他们的一阶距、二阶距、三阶距是不是相同,如果相同,那么不需要计算出来他们具体的概率分布是什么样子, 就可以确定这两个数据他们背后的概率分布是一样的。当然这其实还有一个小疑问,就是数学家们是怎么知道一个概率分布他一定可以表达成一个特征函数,一个特征函数又一定可以对应于一个概率分布呢? 也是有证明的。而我这呢,只是给大家呈现一个正确的结果,放出来让大家看一下,你一看就明白了,这是这个特征函数,特征函数是求他的期望,这个期望的计算是这个样子,其中这个 fx 是概率密度函数,那对这个 概率密度函数做复利业变换的话,你看得到的是什么?是这个样子的结果,可以看到这部分 和这部分只有一个负号差别,也就是说他的负列变换和特征函数是共鄂的,他们是一个一一对应的关系, 而复利业变换和概率分布又可以做一一对应,于是一个概率分布和特征函数就能做一一对应了。 好到这其实所有的数学问题我们也全部搞定了,而我们的目标呢,其实是在不知道概率分布的具体函数表达式的时候,只知道一些样本数据的时候,还想让两个概率分布一样怎么做呢?现在就找到了方法了, 我们可以设一个函数,这个函数具体的是一个项链的关系, xx 平方, x 三次方,就是 x 的次密, 一直往下是他的分量,然后对 x 求期望, q 这个概率分布求得的期望是他 p 这个概率分布求得的期望是他只需要 q 和 p 这两个期望相同,那么就代表了 q 和 p 两个概率分布是一样的,是相同的,是相等的。 不知道大家啊,我在了解了锯这个概念之后,我是会拿出来和交叉商进行一些比较的,因为交叉商和锯,他们都是用来对比两个概率模型的。 如果是用锯去对比两个概率模型的话,我们是可以亲切的知道两个概率模型是不是一致的,那如果两个概率模型的形式都不一样的话,那用锯就很难给一个定量的表达他们到底差没有多大,那这个时候就可以利用交叉商了,交叉商就是不论你的概率模型是什么样子的,最后都会有一个定量的表达,告诉你他们差距有多大。了解了这些之后啊, 我们前面不是说了吗,一共有两个问题,一个是和相同有关的问题,一个是和最大商有关的问题。现在来看,关于相同这个问题呢,我们算是解决一半了,我们知道要比什么了,可是具体到机器学习,具体到训练级,这个情况到底又是什么样子呢?在开始之前呢,我们还是先来看一个最简单的情况,如果说 给了一些数据,你可以把它看成是一个训练级,也可以把它看成是一个样板空间,为了后面解决问题方面,在这需要先引入一个概念, p 上面有个波浪号,也就是 p q 大, 用它来代表一个经验概率,比如说从数据里面直接归纳出来的概率,那这个概率具体是什么样子呢?可以看到在这个数据里面他有两个特征,身高和性别。那就可以把这里面的所有数据都可以进行这样的计算,当 x 等于一七零,并且是难的时候,这个数量除以数据急的 总数,然后是一八零男的时候,数据级的总数占,然后 p 三等于一七零是女,你可以看一下这里还有什么情况,还有怎样的组合,把所有的身高和性别的组合都进行类似的计算,有多少个算多少个,这个屁就这么依次列下去,这个呢就是这个屁挑大的概率分布, 我们把这个 ptu 大叫做经验概率,当然这是一个结构性数据啊,像我们在神经网络里面进行学习的图片,他也可以进行这样的计算, 这个是神经网络的训练级,假如说他有 n 个图片,每个图片都可以用这样的形式来表达,比如说第一个照片就是这个照片的数据,这个呢是照片的标签,当然这个标签也是个项链啊,他又有多个分量,每个分量这里他其实代表的是他属于哪一种分类,这个就是整个训练的 样本空间,通过这个样本空间其实就可以得到一个刚才看到那个 pq 的经验概率分布,也就是这个样子,计算所有的 x 和所有外,他的数量, 最后除以整个训练级的个数,当然在这可能会有疑问啊,这里给的这个照片不可能有两个完全一样的照片,也就是说把这个颗粒度拆分到像素级别的话,那最后这个 come on 计算数量一定是个一,不论输入什么样的照片,最后结果这个概率一定是恩分之一,那这个也就没有意义了, 这样的一个结果是不能把不同的照片给区分开的,有这样的疑惑很正常,但是我们可以再往下考虑啊,把颗粒度拆分到像素级别,那只是在神经网络的输入成这个级别, 到了隐藏层,尤其是到输出层的前一层,那这的感知机的数量就没那么多了。我们其 就可以把所有的感知机就看作是一个一个的特征,特征一,特征二,特征三、特征六等等等等,有多少个感知机算多少个?那是不是在这个层次上,他的特征就不是像素点那么多了, 而是被归纳成这个样子,这个时候再去进行这样的计算,那很可能就不是简单的 n 分之一了,那这个时候这个 pq 的他的意义就能体现出来了。当然我们从样本空间里面反推出的经验概率呢,不只有这一个还可以有,这样 就是说不考虑外,只考虑 x 的时候,也能得到一个经验概率,而这两个概率就是我们接下来进行机器学习的一个先决条件了。那到这我们就可以考虑一下我们的目标了,我们的目标 不是想得到一个这样的概率,也不是想得到一个这样的概率,我们想得到的概率是他这是一个条件概率,就是当 输入 x 的时候,也就是说输入一个照片的时候,最后得出一个结论,他是猫,是狗,是什么其他动物的概率是多少? 我们的目标是想得到他这个是已知的,他这个里面包含了一部分已知的,又包含了一部分未知的,已知的这部分要完全相等,未知的那部分要用最大商,这就是我们接下来要解决问题的一个基本方针。 那这个里面到底有哪一部分是已知的?包含了他们的又有哪一部分是未知的?我们需要用最大商来考虑, 这个时候就需要对他进行一些处理了。这个就是贝叶斯公式,把它展开之后是这个样子,而上面这个呢是外发生以后的 x 的概率,这个是外发生的概率,这样一相乘,那其实就是 x 外同时发生的概率,这个和这个 原则上我们是不知道的。不在这我们就可以利用前面的经验概率了。你看,如果说我们想利用他,就可以把 px 乘过来,让 pxy 和这个经验概率相等, 这一部分相等了,是已知的,那对于未知的部分呢?其实就是这让这一部分呢伤最大。其实 px 我们也是不知道的,但是我们仍然可以用这个惊艳概率的 pq 的 x 来和他代替,这是用 px 外进行处理。按理来说呢,他也可以用 px 进行 展开,展开成这个样子,然后利用 px 为基础,然后让这部分伤最大。这两种方法应该是一样的啊,但是这是用除法,因为后面还要做编导,除法不太方便,所以说就选择了前面具体利用这部分得测的结果和前面这个是不是一样, 大家感兴趣的话可以去算一算,我自己是没有去计算的啊。好,那到这我们的目标就越来越清晰了, 让 p 挑大,这个个接句和 p 的个接句相同,这就是保证了相同的部分, 同时让 p 的这个条件概率伤最大。也就是说以这个式子为基础,那这个经验概率呢?还是要用到的,用它把这边近似代替。那再接下来我们已知的条件都在这了, 其实这只是一个大方向,具体要去计算的时候,第一步可能就遇到问题了。这个 pq 的我们是只知道概率,这个概率是通过前面去数数的方式能计算出来, 但是只知道概率是没有办法求期望的,一个期望一定是一个概率乘以一个随机变量值,然后再相加,那在这只有概率, 没有随机变量。所以说我们在这要想对他求期望,那还需要先在 x 和 y 上设计一个随机变量,然后对这个随机变量求期望。那这个随机变量怎么设计呢?我先列出来,然后再给大家解释为什么这么设计,这么设计的好处和优势是什么? 这是样板空间,我们在上面可以设计一个随机变量,这个随机变量是 x, 他有两种情况,要么是一,要么是零。 当他为一的时候是 x 和 y, 满足某一事件,对,这是某一个事件,是任何一个事件都可以。这个是我们设计出来的,只要满足他就等于一,如果不满足他就等于零。 具体是什么意思呢?我给大家举个例子,你就明白了。比如说事件 a, 这个绿色的是 x, 橙色的是歪,这个 x 的分量是脸圆长,胡子尖爪歪的分量呢?是是猫不是狗,不是鸭。 只要是满足这个事件,那他就等于一不满足这个事件,比如说胡子短,那就不是这个事件,比如说他是狗,那也不属于这个事件,他们通通等于零。那你说这个有什么好处呢?你可以看一下这个新设计出的 x 这个随机变量的概率分母是什么样子的呢? 如果满足 a 就是 p q 大,如果不满足 a, 就是一减 p q 大,这又是一个二项博努力分布。对 x 求期望得到的结果是什么?可以看到就是 p q 大,就是满足 a 的概率本身啊,那这是一个时间,那如果是 m 事件,而这个 m 个事件把样本空间里面所有可能的事件都覆盖掉,那这个 x 一 x 二,一直到 xm 对他求期望得到的那一堆的期望就是对应事件的概率。这个时候我们再去找他就简单了。他是什么呢? 他又可以设计成这个样子啊,他的分量是 x 一 x 二,也就是这些 xm 并不需要考虑 x 一的平方,三次方、四次方, 只要考虑一阶句,把所有时间的一阶句列举下来,只要 p 和 q 对于他来说相等,那么这两个概率分布就一定是相等的。 道理很简单,你看单独一个 xm, 他就是二项的伯努力分布,对于伯努力分布来说,他是比正泰分布还要简单的 总分布,他只要确定一结局,前面我们也看到了那个一结局最后出来的结果,那其实就是发生这件事的概率,发生这件事的概率确定了,那对于二项波动力分布,那这个概率分布也就确定了。所以说从这就能看出,这样设计这个随机变量的好出来了, 他的好处就是可以把之前的那个一结局、二结局、三结局全部都要考虑的问题简化成只需要考虑一结局,只不过呢需要把样本空间里的所有可能事件都列举出来, 好到这呢,其实这个问题已经解决了,不过为了方便大家理解,还可以再去多想一下, 就是设计了这个 xm 这个随机变量之后,其实就相当于是在这个样板空间之上重新设计了一个样板空间, 这个样本空间你可以看到 x 它有很多维迈,它也有很多维,整个下来,那这个样本空间的维度是非常高的。 但是只要设计出 xm 之后,那这个很多维的情况就不存在了,他就变成了只有异味的情况,这异味就是事件, 在这一维上一二三四 m 所有的表示的是这个事件,这个事件的概率我们也是知道的,那只需要对 xm 求期望,就是这个事件的概率吗?所以啊,这么设计这个函数,他的好处那其实就是把原来样本的空间这么多为很多为的情况, 最后都会投射到异位上,在异位上进行比较啊。对啊,多说一下,如果你去看别的文章,或者是别人讲这部分,很多人也把它叫做特征函数,那其实这个特征函数和前面讲的那个特征函数 不是一回事啊,如果你去看他们英文单词的话,那是不一样的,这个呢是集合论理的特征函数,如果是从英文单词旨意过来的话,他是 ndk two 方式 相当于是只是函数,而不是特征函数。这部分内容我一开始还并不清楚,在学的时候绕绕了很大的弯路。我在这呢也给大家澄清一下,你在学的时候就不要和我走一样的弯路了。 好到现在终于啊,我们那个第一个问题算是解决了,就是把那个相同的问题解决了,接下来要考虑的就是最大商的问题了。不过要解决最大商那个问题,还需要引入一个新概念,叫条件商。这是因为我们前面说的商,他其实都是考虑的普通的概率的问题,而现在呢,都换成了 p、 y、 x 这样的条件概率。 换成条件概率之后,之前的那个商的定义还能直接用吗?接下来我们就需要一起来看一看了,前面我们已经把第一 个问题给解决掉了,现在我们需要解决第二个问题了,就是这个 p 的条件概率, x 发生之后, y 的概率,这个条件概率的商应该怎么表示?我们可以看一下。在讲交叉商的时候,我介绍过 一个商的定义,他是这么来计算的, loveps, 他代表了信息量,对这个信息量求期望,那算出来的就是这个。 ps, 整个概率分布的商 定义是这个样子,如果你对这部分不了解,建议你去看一下我之前讲的交叉商,在里面我已经介绍的很清楚了,那现在我们的问题呢?是这里呢,不是一个简单的概率分布了,而是一个条件概率, 那这个条件概率的商应该怎么求呢?那是直接用这个 p y x 把这部分替换带进来算出来的商,就是这个条件概率的商吗?肯定没有那么简单嘛,所以我们具体来看一下啊。 假如说有某个事件 a, 这个 a 呢?他表达成这个样子,那我们想要知道 a 这件事对应的 p y, x 这个条件概率的商是多少,那就可以直接这么计算,是 x 已经发生了 y 呢?他有不同的值,因为是不同的分类,所以说他有不同的概率吗?啊?一到 i, 那每一个外值他对应的是不同的概率,也对应的有不同的信息量,那整个这个算出来呢?就是当 x 括号一发生之后,外的商, 如果整体来说就这么一个事件的话,那肯定就是这个样子,用 p y, x 直接带进来就可以搞定。那关键是在现在的样板空间里面, 这个事件不止一个呀,这可能是事件 a, 事件 b 等等等等有一堆,那每一个事件,那其实都可以进行这样的一个计算,事件 a 的伤对应的是 x, e 发生了 y 的概率,事件 b 呢,是 x 二发生了 y 的概率,那等等等往下一样,事件 k 发生了 y 的概率。所以说要想求这个条件概率的商,只求出单一一个事件的商是不够的,必须把整个所有商都统一考虑起来。那统一考虑,怎么考虑? 那肯定还是求期望吧。那要求期望的话,那事件 a 的上应该乘上事件 a 的概率,那就是应该这个样子,这是事件 a 的概率,事件 b 的概率,事件 k 的概率,然后再把它们加起来, 这整个才是这个条件概率的商,我们把它整理一下的话,就可以这样来定义,这个呢叫条件商,他代表的是 x 事件发生之后外的概率。注意啊,这的变量是有两个的,所以你可以看这 是一个连夹,这是一个连夹,它有两层连夹,而我们简单表示呢,就可以把它定义成这个样子。 x 逗号外代表是 x 和 y 的任意的一种组合情况,通过这样的方式来进行简写,写出来就是这个样子。 其实你可以把这就可以看成是 x 取一个具体值时他的商,然后再对这个商求期望,就是外面这个括号,外面这个括号其实就是当 x 取不同值时候的期望值是多少,这个呢就是他的值。而我们要求这个条件概率的商最大,其实就是在求这个计算的结果最大。 好,现在我们把条件商这个概念给搞明白了,那接下来我们要做的其实就是把 p、 y、 x 当做是变量去调整他,去看一看他如何取值,可以让条件商最大。那具体怎么做呢?是一个一的去试吗?那肯定不是啊,还是要用到数学方法,用 用数学方法对他进行化解,而就是这个化简的过程,可以为我们揭示答案。为什么都说这个 max 和骚夫的 max, 他们的本质是最大商,要想解开最后的谜题,这个 max 和骚夫的 max 他们为什么是这个样子,那我们只能是把这个条件伤最大这件事进行到底了。 可见商这件事我们前面已经讲的很清楚了,他的公式写开就是这个样子的,其中这里的 px 就可以替换成经验概率,用 pq 打来代替, 那后面的 pyx 就是我们的目标啊。那怎么求他的最大呢?是直接把他的最大值找到吗?啊?没那么简单啊。首先我们把这个转换一下,我们更习惯的是求最小值,所以说这个求最大也就相当于是求他的最小。本来前面有符号,把符号去掉了吗?就是从最大变成 最小,不是说直接求他最小值,而是在求最小值的同时还要满足两个条件,第一个条件,哎,就是这 要保证经验概率的,这个值与我们的目标这个概率批他是相等的。相等吗?就是相减等于零。这里面是一个项链啊,这个项链的每一个分量都相等,才能相减等于零。把它展开呢,就是这个样子, 因为对于他来说,这个经验概率我们是可以从样本里面直接得出来的,所以说在这可以把它看成是一个长数。而后面呢,把这些分量展开就是这个样子,每一个分量相减都应该等于零。 其中这个 k 代表的是事件的标号,我们前面把这个概率空间进行了转换,把多位的一个关系全部投射到了事件上,变成了一维的,所以说这是 k, 代表的是事件 的标号。这里是一个关键条件啊,不只是这一个条件,还有另外一个条件,这是一个概率啊,虽然他是一个条件概率,当 x 发生之后外的概率,但是把所有外的情况相加,他依然应该等于一, 也就是说一减他应该等于零。在同时满足这两个条件之下,求他的最小值。 怎么求呢?其实在高处上我们都学过用拉格朗日乘数法,比如说构建这么一个函数,这个就是前面那个条件商, 后面这个呢,是两个需要满足的条件,然后在这增加参数栏目的零和栏目的 k, 那原来那个在这两个条件下求极小值,就变成了整个这一个式子。求极小值,这个是拉格朗是乘数法的基础啊,我建议大家去网上搜一下,我在这就不详细展开了,要不然的话这个是 长就没法控制了。具体这个式子我们可以再展开看一看是什么样子的。重点其实是后面这些变化, 这是对 f 函数求期望,求期望,展开就是这个样子,这里是 x y 的函数,那前面就是 x y 同时发生的概率,然后把这个概率和这个具体的值相乘,然后再相加,就是这个期望。 而他呢,不是我们的目标啊,我们的目标是这个条件概率,那他还能通过贝叶斯公式展开,展开成就是这个样子了。本来这呢应该是 px, 我们还是按照前面的习惯,直接就用 pt 了给代替了,用这个经验概率把这个 px 给代替, 那最后出来的结果啊,就是这个样子。在接下来呢,还是需要大家对拉格朗日怎么求,截止有一个基础,再往下其实是可以考虑拉格朗日乘输法的一个队友。问题,原来不是求他的 几小值吗?值,当 p 和栏目呢,等于什么时候他的值为最小值,那他就可以被转化成这样的一个问题,就是先把栏目呢当做需要调整的参数, p 当做是一个长数,找到他的最大值,然后在这个最大值的情况下,再去调整 p, 找到他的最小值,这是一个原问题, 而这个圆问题和队友问题是等价的。这个队友问题呢,其实就相当于是把他们两个交换了位置,先不考虑栏目的,当把他当做是一个长数,去看,当 p 取什么值的时候,他能取到最小值,然后再在这个基础之上再去考虑栏目的, 再把这个最大值取出来,这个的结果和他的结果是一样的,如果你对这个过程不熟的话,哎,你可以自己去看一下关于拉格朗日乘输法,拉格朗日的队友问题,这方面的内容你不去了解也没有关系, 你就默认他是对的,我们需要解决这个问题,只要把这个问题解决掉,那前面的所有问题都被解决掉了。那接下来我们的目标要清楚了啊,是咱们的是常数, p 等于什么的时候,他的值最小,就是这个函数求他的吉值怎么求?哎,这里还是需要有一些高速的基础,就是对他求倒,找那个倒数为零的值。在这呢,我们把栏目的当成了是长数,所以说对 p 求偏倒, 这个函数对 p 求编导, p 是什么? p 就是我们的那个目标概率,那个条件概率,这部分求编导之后得到的是他这个是 x 乘以 love youx 这种形式的求导,这个求导是 他的导数乘以他,然后加上他的导数乘以他,最后得出来的结果就是这个。而后面这个呢,栏目的乘以一,这是一个常数求导,而等于零就取消掉了这 部分球岛,他的岛数等于一栏目的成进来就是这个东西。那再往后他的球岛这部分是个长数,长数球岛等于零,后面他的球岛 pt 大和 fk 是他的系数, 他约定系数留下,就是这个样子啊,注意这个符号,他的符号留下来在这,这是求编导对他继续化解。那其实可以观察到啊,这里有一个 pt 大,这有一个 pt 大,如果能把他们提出来就好了, 但是这没有,没关系,我们可以把这一项补上。这个呢,你可以想一下,把所有 x 的概率都加起来,那他应该是等于一,只,不过是我们想要把它提出来,所以凑了这么一个项,那有了这项以后,那就还差一步了, 这只有一个 x, 而这呢是 x 和 y, 我们想让 px 移到这个廉价里面来,能不能行呢?可以啊,这个 y 这 里是关于外的添加,而他那个里面是没有外做变亮的,所以说可以直接这么来表示,于是 这一项,这一项和这一项就可以被统一提出来了,最后就可以表达成这个样子。而我们的目的是什么?就是要求他等于零的时候, px 等于什么?他等于零就相当于是这里的每一项都等于零。 其实在这我心中还是有一个疑问的,就是为什么是每一项都等于零呢?这不是应该是连加之后等于零吗?这个 问题我其实现在都有疑惑,但是我看所有人都是在这么做,而且他们都说这个显然是这样的,结果,我真的是没有显然出来。 如果你知道答案的话,希望你把这个答案留言或者是弹幕告诉我,让我能把这个问题解决掉。但是这不妨碍我继续往下推,因为这只是一个数学技巧问题,并不影响我对整件事的理解。所以说我就继续往下了啊,有了这一题, 那就好办了,我们只需要把他都移过来,然后对他取反,就能求出 p y x。 他的具体的形式就是他 可以看到 p y x 等于这么长一串 e, 上面有栏目的零减一为指数,这个 e 又有这么长一串作为指数,这可能还比较复杂,看起来比较陌生,我再把它变换一下,应该就能感觉到熟悉了。前面的这个系数呢,我只需要对指数加一符号,就可以把它写到分母上来。上面这一串我进行一个化解,上面这一串连加,如果你用项链表示的话, 那就可以表现成这样子。栏目呢,是一个系数的项链, f 是一个函数值的项链。到这这个感觉是不是就非常熟悉了?我们前面讲的感知机进行线性运算的时候就是这种形式,那下面 这个又是什么呢?你别忘了栏目的零他是为什么引入进来的?这是为了解决最后的皈依问题,对吧?那我们就可以把这个 归一问题直接引入进来, p yx 这个条件概率,他应该最后是归一的,那根据这一条就能算出来,这个分母应该等于所有分子相加到这是不是就更加熟悉了? 我们要求的这个条件概率,他其实是等于这个样子的。上面呢,我们很熟悉,就相当于是胆汁机里的那个 z 下面呢?你看这是外,外是什么?外是所有的分类情况,那这部分就代表了是对所有分类情况的一个求和, 是不是熟悉感就越来越强烈了?那我们再来把这个细致的看一下,这个是我们计算出来的结果,外是什么?外是对应的具体的分类,他的分类的取值是这个样, 那这个过程我们就可以看成是这个样子,把 x 看作是一个图片,这个图片经过某一个过程之后会进行分类, 分类一分类二分类 i, 这个呢就对应的是这个 y 有多少个分类,对应 y 有多少个分量,每一个分量都可以计算一个在 x 为条件下的 外的概率。而我们在去学习和训练的时候,就是要去找这一个分类的概率和标签的差别,然后进行学习训练的,那这个屁值等于什么呢?这就等于这个,这是分子,这是分母。那如果我们把 这部分看作是 t 的话,那他其实就是对应的 soft max, 到这其实就非常清楚了, soft max 他是怎么来的,他是在求最大伤的时候得出来的,那这里这个 e 为什么是 e 我们也就非常清楚了。这个义是怎么引入来的?是在考虑伤的时候引入进来的伤不是要求 logo 吗?那他的逆就是义是在这个过程中引入进来的,所以并不像我们前面想的那么简单, 只要能保证最后通过激活函数输出的那个值大于零就可以了。你要是这样去计算的话,他不只是保证了他的概率,还同时保证了最大商。所以到这应该彻底明白了这个 mori 的和骚特 max 他们到底是什么?只要你的神经网络在最后一层在 输出场选择了 ccoury 的,或者是选择 soft max, 那你就默认选择了最大商的方式进行继续学习,这个才是 soft max 的本质。而他最后的那个结果,单个值大于零,整个所有的情况加起来等于一,比如归一,这个只是他的附带结果。现在我们已经 看到了啊,为什么 soft max 和 siri boy 的最后会是这个样子?是凑出来的吗?是为了好计算吗?其实不是啊,而是神经网络最后选择了他们作为计划函数,最后就保留了最大商作为基本原则, 哪怕是隐藏层里面用其他的计划函数,用 vivo 或者是其他计划函数,只要最后输出层仍然是选择他们作为计划函数,那最后你的神经网络依然是保留了最大商。其实到这这个问题还没有完,前面我们看到拉格朗日那个队友问题只解决了最小那部分问题, 那现在还有一个最大问题需要解决。我们其实已经知道啊,用最小问题相当于是可以确定概率模型的形式,最好要通过最大问题去确定整个概率模型的参数。我们在学习神经网络的时候也知道啊,去确定参数的时候,我们其实是利用了极大自然估计法,或者说是交叉商方法,现在用了一个最大商方法, 那么他们之间的关系又是什么样子呢?通过前面的推导,我们其实是完成了这一步,其实外面这一部分还没有完成, 如果外面这部分也完成了,就相当于是栏目的这个参数给确定了,那对于呢,我们神经网络,那也就相当于是 w 和 b 的那些所有的系数也全部搞定了。所以呢,我们前面只相当于是完成了一半, 通过这部分,先把 p 这个概率分布的形式给确定下来了,然后我们再去考虑栏目的这个具体参数的问题。其实只是通过这部分,我们也能了解一些机器学习的本质。我们前面做了很多工作,目的呢,都是要把这个最大伤的这种方式给列出来, 裂开了之后有什么好处?之前我们需要同时调整栏目的和 p, 而现在呢,我们就可以把问题进行了拆分。再去找 p 的时候,栏目呢可以独立出来,再去找栏目的时候, p 又 可以独立出来,也就是把原来混合到一起的问题,现在比较清晰的分成了两部分,先确定 p 的形式,然后再去确定栏目的。而这部分对我带来的启发呢,还不止这些。为什么这么说呢?我们还是要从头开始看一下啊,这一个大环套小环其实就能代表了我们所有机器学习的一个目的。 训练级是我们已知的一个样本,我们在进行继续学习的时候,其实就是想要把这个适用范围给扩大,但是这个扩大的过程不能随便扩大,他必须保证这个扩大的过程是在已知训练级的延长线上, 也就是说那扩大范围之后的结果应该与训练级里面的样本特征保持一致。这个其实就是我们一直前面在说的啊,这是训练级的一个经验概率,这是扩大之后的概率,要保证他们相同。同时呢,我们 在处理问题的时候还有这样一个近视,这个呢是保证了相同,保证了这个扩大的过程是在训练级的延长线上。那这个扩大他到底扩大了什么呢?是什么被扩大了呢?其实就是这个条件概率被扩大了,为什么这么说呢?我们拆开来一看就知道了, 如果说 x 和 y 他们本身就属于训练级,那么这个条件概率他肯定和这个经验概率是一样的。那当 x 和 y 有一个不在训练级的时候, 那 pxy 等于什么就无法确定了。那这个时候既然是未知的了,那就有最大伤的用武之地了,让这部分未知的情况伤最大, 于是这个就变成了整个机器学习的前提。而在这个基础之上,我们还可以继续一步一步的向前走,其中第一步 就是把这一部分单独拿出来,通过他就可以把 p 的这个概率分布的形式给确定下来了,确定的结果就是他这个形式他其实属于指数足这么一个概率分布, 也就是说像是二项博努力分布啊,多项博努力分布啊,正泰分布啊、博松分布啊等等等等,很多很多都属于这一个类型的,他们只要进行一定的变化,都可以用这样的形式表达出来。之前我在讲神经网络的时候,比如讲过对比两个概率模型,最大的问题 不就是不知道他们的形式,不知道怎么能让他们相等吗?现在其实我们可以确定了,通过最大商这个原理,我们其实就能知道 这个概率形式他不应该逃出这样的形式,也就是说他不应该逃出指数足这种形式好到这对于一个通用的机器学习方法来说,通过这一步就能把他的概率分布的形式给确定下来了。而在我们 去用神经网络的过程中呢,只要是在输出层,就是最后一层选择了 soft max, 或者说是选择了 ccoury 的作为激活函数,那么你就相当于是默认的进行了这样的计算, 也就说你默认的选择了最大伤原则作为你机器学习的基本原则。到这这其实只是完成了一半的任务,形式确定下来了,但是他这个参数具体是什么,可是还没有定下来呢,具体怎么定呢?我们就可以把 p 带到这个函数里面,然后得到一个新的函数,这个函数里面的变量只有栏目的,当然这个栏目的他是有很多的,他是一个项链,然后通过对他求极值,找到他的最大值, 把栏目的给确定下来。当然这个栏目的参数太多了,直接去进行计算求解的话,那是几乎不可能找出来的。所以呢,到 这一步常常用的方法就是构建一个损失函数,然后用梯度下降法等等方式训练得到,那这部分不也是神经网络用的方法吗?所以说在这个层次上,神经网络和这部分是一样的。其实到这还没完啊,其实上面还省略了一步,那要想构建出他的函数来,其实还需要构建 fx 这个函数啊, 这个函数是怎么构建的?是要把样本空间里的所有事件给找出来,而这个事件本身他依赖的应该是一个一个的特征, 那为什么这必须是人为寻找特征呢?我们前面其实也介绍了啊,如果说你搜索是一个图片,把每一个像素点的值都作为一个特征单独来去考虑的话,那最后得到的概率值是没有意义的, 除非你从中找出一些有聚合性质那些特征。就比如说你经过了理性的分析,把照片里的 猫的耳朵,猫的鼻子、胡子、毛的长短这些特征挑出来,在这些特征之上再去构建 f 函数才有意义。而这个过程呢,一般都是人为寻找的。而对应到神经网络呢,就不一样了, 神经网络寻找特征的过程,他是在隐藏层自动就完成了,通过后面的学习训练,隐藏层就会自动去调整这些特征,以方便达到训练的最好效果,这个也就能体现出神经网络的优势来。 现在机器学习都在提倡从端到端,就是说中间没有任何过程,所有包括特中学习参数调整,所有的一切能交给算法的就交给算法,不要人为的去操作,而在这就能体现出神经网络的优势了。所以总结一下的话,神经网络 他为什么要分成隐藏层和输出层?隐藏层相当于是自动找到特征,那在输出层选择 supermex 和 cem boy 的,他相当于是选择了最大商作为基本原则,那最后再进行训练,到这其实就是一个积极学习的过程。不过还有最后一个问题, 就是在进行训练的时候,这一部分是继续用最大商去调整栏目的参数,而在这呢,用梯度下降法的时候,个人选择的是极大自然法,也就是交叉商方法,因为他们是等价的,那最大商的方法和极大自然的方法,他们等价吗? 他们依然是等价的。这部分是最大伤的方法,这个是极大自然的方法。先说结论,最后最大伤的方法得出的结论是他极大自然得出的方法是他两个是一模一样的。总结的过程呢,这屁不是已经 算出来了吗?我们把它当做已知带进来,带入到那个 l 函数里面,得到的就是他这里,因为他最后等于一,这里是零,所以说就取消掉了。而在后面整个运算的过程中,主要是对后面进行拆解,所以说我用橙色给标出来了,大家可以看一下这个过程啊,把它盛进来,是这两项, 然后这部分不变,移到这,把它交换过来,到这呢,就可以发现这一项和这一项是相同的,然后把他们提出来,最后得到的是落个屁,减去正常。 而屁呢,他是可以展开的,展开形式是这个样子,他减去他,而他呢,又可以继续剪开。烙个分子减去,烙个分母,烙个分子对易为底的指数求 log, 那其实就是把上面的指数拿下来,那烙个分母呢?是这, 你看这里和他是相等的,所以说约掉最后这一部分,拿出来,符号移到这, 得到这样的结果,那这个其实就是这里这部分。这部分不就是前面一直讲的骚夫的麦克斯那个分母吗?他其实就是一个皈依化因子,保证最后计算出来的结果是皈依的。我们把它统一用 am 的来表示,放到这, 然后最后一步,这里有一个外,而在后面整个数字里面,只有 p 是和外相关的,而 p 对外求和之后等于一, 所以得到了他,这是最大伤的方式。那再来看极大自然,我们用 logo 的方式来表示极大自然啊。极大自然的计算方法是把所有的概率都连成 p 的概率能发生多少次呢?那就相当于是 x 和 y 对应事件有多少个,那得到的结果就是这个样子,我们方便计算前面 加了 bug, love 一进去以后,连成变连加就变成了这样的形式,这是计算 x 和 y 的数量,其实这只需要下面除以一个训练级的个数大 n, 这也除以一个大 n, 最后是不影响他的最大值的,但是这除以大 n 之后,他就变成了 pt 的那个惊艳概率了, 所以说自然直就可以用这样的形式来表示了,然后求他的最大值,这部分呢, p 继续展开成这样子,这个继续绕着他把系数移下来, 绕口下面这部分,等于他把这一部分重进来,得到了,是两项,这是一项,这是第二项。那这一部分就是这个归化因子吗?那这部分其实我们可以继续把它展开,可以把它展开成这个样子, 这个是我们前面一直在用的啊,利用了贝耶斯定理,可以把它拆开成这样子,和外相关的只有他,而他对于外连加最 后的结果是一外取消,留下 x, 得到结果是这个最后他的结果和他的结果是完全相同的。 到了这里啊,我们相当于是掌握了三种完全等价的方法去调整参数了,第一种是最大伤,第二个是吉他四 m 攻击法,第三个是交叉伤。而且通过这一次的学习,我也对骚和麦克斯为什么是这样子的,他和最大伤有什么关系,以及最大伤对机器学习的重要程度,我都有了一个比较通透的理解。 到这呢,我的这一次任务算是完成了,如果你喜欢我的内容的话,希望你可以关注我,并且别忘了一键三连啊。

221王木头学科学 19:04

19:04 03:16查看AI文稿AI文稿

03:16查看AI文稿AI文稿大家好,今天我们来看深度学习 deep learning, 在前面我们对神神经网络的正向传播和反向传播都进行了实现,那么在这一节我们单独来说两个层,第一个层叫 a find 层,第二个层叫 soft max 层。 看第一个层 a fight, a fight 实现实际上就是一个加减求和的一个过程。我们来看下面这个计算图, 它表示 w 和 x 求类级,然后再加上我们的 b, 最后得到了我们的 y, 所以 a 放一层,实际上就是一个加权求和,所以它非常简单。而我们也可以 使用 python 来定义一个 fi 类,那么这个类就涉及到一个前向加权求和的计算,以及一个反向求梯度的一个过程。 首先对它对它进行一个数字化, w, b 以及我们的输入 x 和梯度 w 和 b 的一个梯度,然后是前向传播,根据我们的 w 和 x 求类集,再加上 b 计算它的一个加权和,然后再定一个方法是 back well 的计算一下我们权重和偏置的一个梯度啊,这就实现了 f 类。然后我们再来看下面一个类, 叫做软入类,软入层的实现。软入作为神经网络的一个非常常用的计划函数也是非常重要的, 那么定一个 rerule 类,这个类也定义两个方法,一个是前项函数,一个是反向函数。前项函数将输入数组 x 中小于等于零的部分作为一 变为,然后输出。而反向传播就是将输入数组中的输出 等于零的部分字为零,然后输出,这就是我们,这就是 back well 的的一个反向传播。那么我们再来看 softmax with los 层的 实现,使用 softmax 计划函数来计算损失值,计算 lost, 然后定义一个 softmax 位置, lost 说同样先给定次数化,给定 lost y 和 t, 然后前向传播和反向传播,前向函数输出损失函数值,通过我们的交叉上损,交叉上损失计算得到损失值, 然后是反向传播,根据损失值来进行结构的推理, 那么这就是 a 放一层 real root 层和 softmax 层的一个简单的实现,谢谢大家。

6跨象乘云 05:12查看AI文稿AI文稿

05:12查看AI文稿AI文稿咱们学习优化小技巧, softmax 篇,那 softmax 篇呢?依赖之前的 symbol 的篇,所以优先去看下 swathmat 那边是讲的什么内容。那 softmax 篇咱们主要是针对两个类别的,两个类别是属于什么场景呢? bloodfish 跟热线 face 做检测的时候,他们通常是用两个类别类别来定义 正一样本和副样本。那通常我们会看到一个神经网络,比如说卡号,卡号卷机,最后呢是拿一个 sus max 把它变成概率,再做个输出。那注意啊,这边的概率是两个类别,一定要注意这一点,那对于多个类别需要自行推倒啊,那多个类别可以自己去做一些思考。 那咱们比如说拿到个 predict, 咱们等于 next to a post to 这两个值,咱们把先 neck 和 pose 来定义这个值啊,那咱们 probability 就是概率值啊,通常是要做一个 son max 和把 predict 变成概率。那变成概率 是怎么变的?这是 so max 的公式啊,他这个写法咱们应该都懂啊。那对于咱们通常使用的时候,咱们的条件是 positive 的预知大, positive 得分大于咱们 stress hold, 那意味着咱们是不是只需要关注 positive 就行了,对吧?所以只需要关注这一项。那咱们把 pro b 的起重新改写一下,变成一个 n 和 p, 那 n 对应的是咱们的 next to p 对应的是 post to, 不过这两项是概率,那这两项是预测值,要区分它的一个定义啊,这是预测值 prade, 它的直域,比如说负一百 到正一百,对吧?都有可能不不知道啊,无所谓。那这个 n 和 p 呢?他直域就是零到一啊,注意这个他,而且他的盒就是他的盒,就是一,那这是咱们 pro b d 体的一个定义,那咱们把这个 p 的定义咱专门拎出来,咱们写在这里,那对, 咱们日常所用的时候,咱们条件写的是 p 大于四 s 后的,所以指的是正力的得分大于咱们的预值。那咱们把这一项拎出来,看这个东西能怎么去处理它。那咱们拿到这,拿到这一项过后呢?同除以 分子分母同除以一的 pose 啊,一的 pose 是方,嗯,方,那这个分子除以 pose 这个东西也除以 pose, 咱们得到什么效果呢?就得到。嗯, 分子变成一的,然后分母呢?这个东西变成一的,因为他除以他得到一的,然后这边呢,是不是就变成了一的 next next you, 此方比上咱们一的 pose 此方。然后呢,进一步,咱们把这个东西是不是可以写成指数形式啊?是不是变成了一的 next 减 pose, 然后再进一步的,咱们把它加个负号的前边,是不是?这是不是就变成 e 的负的 pose 减那个?那进一步的,这个东西像什么呢? 是不是有点像把中间这个变成 x, 是不是就是咱们的 sigmo 的函数啊?所以咱们就能得到原来咱们的 post to 的一个概率值,实际上是等于咱们的 sigmoy 的 pose pose 减 neg, 注意啊,这个是 predict 啊,所以咱们的概率值是等于 post 减 next 做一个 sigmore 的, 然后呢,咱们就得到最终的结论就是这个,这一项,对吧?得到这一项过后,咱们是不是就可以用之前 c 墨的那,那里面的策略,对吧?所以咱们的条件是不是就变成了等价于这么个式子?就是说我对 pose 简那个做 sc 墨的就大于咱们的 ss 后的 就满足条件是跟咱们那个 sof max 的效果是完全一样的。那对于元旦吗来讲,咱们是不是要先对 pose 那个做一个 sof max, 然后得到的 n 和 p 是咱们概率值,对吧?然后再对嗯, pose two 大于 sures 后的再 做下面的事情。那对于新代码咱们怎么改呢?就把它变成了 pos 减那个大于 dcmore 的 cs hold, 那 dcemore, csol 是不是也可以提前算出来?没错吧?那这个时候咱们是不是等于说把这个 sof max 也给干掉了,所以咱们时间也能得到节省,跟 ceomore 的那个操作是完全一样的,对吧? 来,咱们看下代码,咱们定一个 sof max 的一个操作,咱们定义那个跟 pose 的值是负零点八和一点七,这随便写的啊。那咱们把它做个 sof max 做好过后,咱们得到 poseto 的一个概率是零点九二四幺四。咱们把 poseto 跟这 pose 减那个去做个 sof max, 做个 come 的啊,做个 come 的得到的值是不是跟咱们的 poseto 的值是完全一样的?没错吧? 那咱们的日常的代码你会怎么用呢?你可以看到第一次 s 后的咱们可以第一次用我的直接改算好, 跟咱们这边的这个第一次跟我的算好是一样的。然后呢,咱们拿到这个 face back, 其实指的就是 post to pose 跟咱们 leg 是这两个值啊。拿到这个值过后,咱们是不是可以算出 object 的一个 d confidence, 相当于是咱们的 d 就是那个 d sing more 的过后的值,就是 facet back, 然后再把拿这个值呢跟咱们稍后的做对比,如果大于他说明满足咱们的预值,咱们是不是可以保留啊?对不对?那咱们最后那要输出的时候是不是还要把它变成概率值啊?那是不是直接写一个四个末的,然后呢? pose 剪那个不就行了吗?是不是?那整个过程是不是等于把 so max 也给干掉了?是不是等于省掉了很多的时间?省掉了多少时间?省掉了很多次,比如说通常都是以万计的次数,对吧?省掉了很多次的一个计算,那这在一样的 在嵌入式上会有很大的一个提升。那以我之前的例子,就通常是八毫秒把它变成零点八毫秒,所以速度是非常快的,所以建议大家试一下。

21手写AI 03:21查看AI文稿AI文稿

03:21查看AI文稿AI文稿指数函数了 soft max 函数,那么它的作用是将输入值 x 压缩到零和一之间, 然后再标准化所有值,使他们的概率之和概率之和等于一。那么我这里还是百度百科上面的解释啊。呃,和他的一个公式。那么我们将神经网络输出的十个结果传入 soft max 函数,就能获得我们想要的概率和唯一的一个概率分布。 那么接下来我们就来实现一个 solo max 函数,看好他的函数啊。这里是 x x 指数,一位的 x 指数,然后下面是一个求和,也是一位的 x 指数。我们来看看具体怎么实现啊。 直接 return torch 刚才说上面是指数,直接就是 e x p x。 然后接着是我们看看还是 touch 点 e x p x 对吧。 e x p x 对的。然后给他们再求一个和,求一个和。 torch some ok? 那么这个 touch 点 esb 我们刚刚是说过的啊,是求 x 的以一为底的自然数。一为底的指数 在这个分母当中,也就是后面除后面这一部分呢。分母当中也需要计算 x 的指数,然后他对他们求和。所以这里我们要注意的是,这里的数据是十行, 每行数据只有一个一列元素,所以我在这里要对他们求和的时候需要加上参数。 ding 等于一。这个 ding 就是 dmen 选维度的意思,这个是一,也就代表是第二个维度 在列上面给他们求和。还有一点是,这里是我们是准备将上面的神经网络输出直接传到这个函数里面来计算的。 那么我们 x 的形状应该就是呃,六十四乘以十对吧。然后这里 exp 得到的结果也是六十四乘以十,然后我们公司中的分母就后面这部分呢?通过萨姆计算以后,形状变成了一个长度为六十四的项量。那么这个 除法会让这个 exp x 中的每一个元素都去除以这六十四个六十四个值。那么这个除法就会让 exp x 中的每个元素都啊,那么结果就会得到六十四乘以六十四个元素。那么这个肯定不是我们想要的结果。我们希望输出 六十四乘以十的形状的一个障量,因此我们需要将上的结果变形一下, 变成一个六十四行一列的形状,对吧?那么也就是将六十四乘十中的六十四行去除以这里的六十四乘以一的正量,每行也会一一对应。 那么这个地方听起来有点复杂啊,有点绕,但是我们只要理解拍唾弃中的广播的概念,以及如何能让所有的这些张亮具有正确的形状就可以了。

85人工智能编程 25:21查看AI文稿AI文稿

25:21查看AI文稿AI文稿大家好,从这节课开始,我们将带大家来学习麦克玛前处理的相关的一些项目。首先我们来打开软件, 首先要想进入前处理这一个 工作界面,我们现在点是没有用的,他说没有一个工程项目被选取,因此我们必须要新建一个工程项目,或者是打开一个工程项目, 在这里面我们来打开一个已有的工程项目, 我们来打开这一个工程项目,我们可以通过备注的一个图片可以大概的先知道这是一个什么样的产品, 这是一个平板的一个平板键, 因此在这一个就是导入图片这一个你有备注的这一项可以让大家一目了然。 就说如果说你做的一个 grf 的一个模拟仿真图片也可以放在这边,你就知道这是用什么样的一个版本先新做的, 点击, ok, 这样我们就可以进入前处理,点击前处理,到了前前处理这一界面当中,我们可以看到有四个 一二三四,四个四除四除窗口啊。在学习前处理相关的知识之后,我们必须要先来学习预处理前的一些准备知识, 对于且对于第二章预处理这一块,我们将打算用比较多的章节来大概来讲, 因为在这里面在预处理主要的一个功能讲解当中会有很多项知识点 坚持,我们种的一个大类是什么呢?第一个就是说先讲解预处理前的一个准备知识,然后第二个是预处理主要的一个功能讲解,然后第三个是铸造系统,就是导入前的一些注意事项。 然后第四个就是预处理中像铸造系统材料一些分配,然后是导入的顺序,或者是你导出来以后怎么来更改一些方法。 然后第五个是就是关于冷却系统的一些和排气系统这两大类,然后第六个就是 四种粒子,就是跟踪粒子或者是冷冷却的一个曲线或者是热电哦,然后是模拟结果的一个表明线,这几道像我们来安排来讲,然后顺着一步一步我们进行细致的讲解, 首先我们要知道就是预处理前的一些需要哪些哪些准备知识呢?就说首先我们第一个就是如果是在建模的时候 有几点一个建议,如果说将一个复杂的几何实体划分为简单的独立部分,就说像住建了一个模型或者是行星,或者是交住系统模具等,必须要确保每一独立的部分 彼此之间要有适当的连接。然后第三个就是要一般要使用指令的文件。 第四个就是要注意他的一个叠加的一个原理。什么叫叠加原理呢?就是说像我们导入模型的时候,如果说嗯像定模或者是动模,我们只可只用简单的一个方块就可以了, 如果是你如果是根据实际的需要导入真真实实的你的一个三 d 图档也是可以的。如果我们为了简化,我们直接就导入嗯你的一个住建,然后过后是水陆或者是其他的。我们最后一部分 我们可以呃像模具的电动电膜,我们直接画一个图框,如果是呃在这里面就要注意一个叠加原理,叠加原理指的是就是说最后导入的图形具有优先的特性, 假如说我们一开始先导入的是动电膜,如果说你导入另外跟着的,如果是像产品行枪这一块,那他有具有优先权,制动就将你一个模具实体进行挖空, 还不能说先导入产品过后导入你的一个模具材料,这样就位置顺序就撤掉了他的一个叠加原理的话,这样就很难实现。 然后第六个就是对于对于对称的一个实体可以使用就是 cutbooks 这一个功能, 然后就说相对于像 cmd 文件进行一个命名,然后让表单或者是和几何实体,然后是图数必须要相符,最后就是要将所有的实体图数保存为表, 然后存出几何要素,必须存为存在一张表当中。 像操作命令的一些方法,我们可以采用几种方法呢?第一个就是说可以用鼠标这一个命令,随便你可以点击这一命令。第二个要 结合使用呢,必须要用键盘的一个命令。然后第三个我们可以采用编辑 cnd 这一个文件的一个方式。 现在我们就来讲解预处理的一个主要功能, 功能里面的很大概我们要讲二三十项,这样第一项我们就是来讲第一个就是相遇处理的一个主要的界面,我们可以看到我们现在进入的 麦克玛前处理的这一个主要的一个界面,我们可以在这边看到他的有很多的一个菜单项,在这里面点击每一个菜单项过后,他也有很多的小的分类菜单, 我们可以看到点击文件菜单的时候,我们可以看到他有第一个添加像表了,或者是添加 iigs 这一个图档的文件,或者是导入的 cd, 然后导入 sto 图档, 然后是或者是加载 fem, 就是有线缘的一些网格,然后是建立新的表等等等等这么多功能我们都是要细致的进行,一步一步的根据来学习。 然后在第二个选择当中,我们可以看到他的一些留点呢,或者是他的一个面,或者是需要编辑的等等,这些 我们都需要像提及或者是红。 然后再如果说你打开很多张表的时候,就需要用到下面这几项功能,可以说如果说你点击下一张表,然后点击这一个,你的上一张的表就被激活启用的,可以进行编辑 这些功能在以后当中我们要进行详细的学习,然后是编辑这一项,我们可以看到他有删除, 这是你所选择的那一个文档。 在显示功能当中, 这边我们可以看到一二三四四个图框,你可以单独的显示,也可以完全的全部的显示 这重设,重设的话你就可以同样每一个图,每一个四窗界面可以的。 然后是色彩,就说你可以更改背景一个色彩,如果说我们进行更改,他会跟这里进行变化的, 他会跟这里进行变化,然后这是材料,材料当中你可以显示所有的,然后你可以显示他的材料,不同的材料可以 单独显示排气了,或者是什么都不显示,然后想帮助这一块,可你可以直接在线的一个帮助,同时如果说你可以点击这边就是实现 计时的帮助,如果说我们随便点击一个材料这一块, 我们点击这一个,他就会出现事实的指到哪一个地方,你就可以进行 通过这些帮助文件来了解他的每一项的功能和作用。 然后这是他的一个信息, 假如你每桌一样的,他所需要的一个信息像表了,或者是你的一个文件格式,或者是所有的这些我们先将关掉,然后这边是数据库, 你的一个所做的一个数据,让你所加载的机机油这种文件格式, 或者是去除加载等等,或者是整个来设置,或者是创建等等,这些 或者是本身如果说你有数据课当中有本人有副式科的,有数据扣, 这些都能够进行编辑和使用啊。在这边我们可以看到 他有一个三个简单的一个作图的方法,这是点或者是线,就是曲线,这个是做圆,或者是做圆柱体,或者是做其他的一些脆度, 这可以做成分体或者是其他的一些凸面体,这样 下面所是所需要使用的一些功能的菜单键。 像这个是材料主材料当中我们可以看到有这么多 材料公里,是就说命名公里来选取,像我们压住上面最常用的,像这个是定膜,我们可以命名,然后是冻膜,然后是料柄,然后是滑块,然后这是内胶口,然后这是流道, 然后这是猪汤口,然后是冷却系统,然后这是猪圈。像这个是属于,就是像沙星或者是沙漠, 这些是其他所用的,或者是本身的一个补充,补充的一个猫口径等等。这些 或者是在 挤压的时候就说压住当中有一种特殊工艺是挤压,局部挤压这一个工艺,那我们就需要用到他特定的一些指令了, 这是对他的一个前处理的一个界面的简单的一个讲解。在今后的使用过程当中,我们我们会根据每一步来进行对局部的进行细致的讲解。 首先我们现在因为我们是从一开始新用的,就说新来学习的那个吗?因此我们在就说开始不能去 先导入表,因为我们刚建了一个工程项目,你还没有导入你的 sto 土档,这时你还没有创建你的表,这个时候我们就需要从学习怎么样去导入 sto, 就是说你的一个土档这一节来开始, 怎么那怎么来导入土档呢?首先第一个我们要想导入土档,刚才已经说了在文件这一拆单像下面有这一个加载 stl 土档这一个功能键, 但是不是说单单的只要点击这个加载 sto 图单就就行了,我们需要配合这边的一个材料组,相应的材料组来导入, 导入的方法有哪些呢?第一个就是我们点,如果说需要点击的话,我们先点击材料主, 假如说你本身有模具的话,你可以导入你的一个定模或者是一个动模,但是我们这边没有这一个动模和定模,我们现在是需要怎么导入呢? 他有两种方法,就是说第一个你可以随便导入导入就是,但是目录里要正确就说不正确也无所谓,在后期你可以更改,但是那样比较麻烦,就说我们可以先导入其他的不导入模具, 我们直接可以先倒入,像住建这一块开始我们可以加点 住建,点击住建以后我们来点击 加载 sto 图档,然后找到相关的里的 sto 独档。像我们刚才说住建,那我们直接当中就说他是从渣包开始,他的一个导入顺序就是从模具,然后是 就说冻膜,呃,钉膜、冻膜滑块,然后如果有水度的话,你要导入一个水度,然后过后是扎包,然后是产品,我们可以先导入扎包这一个, 然后进行打开点击, ok, 我们可以看到这样这一块就导入过来了,像住建他的颜色区分是为 红色的,那我们同样属于住建这一块,这个时候我们来进行怎么样导入呢?像本人扎包跟产品这两个是同属于住建,就说这一块,那我们在这边可以添加,同时添加他的一个 地址来地地址我们点击添加就可以了, 点击添加完过后我们来紧接着导入第二个就是说像产品我们可以进行导入, 这样就可以了,这样第二个部件就导入进来了。导入进来过后我们要导入的是什么呢?紧跟着的他紧跟产品在一起的, 那肯定是内交口这一块,内交口这一块就说 导入内交口,我们是这样就是音 get 这一个,点击 in get, 同样在这边进行加载内交口,我们可以看到导入内交口 就可以了,这样内交口就可以了。在这边有一个问题,就是说我们为什么要把内交口这个单独 来去选呢?不和留到或者是一起呢?因为我们在划分网格的时候, 呃,可以采用高级网格划分的一个方法,那时就需要像对于像这个局部 本身比较臂薄的地方,我们可以进行细致的一个划分,如果说跟其他连在一起的话,你的一个划分数量就是控制起来,单独控制这一点的话是比较麻烦的。因此我们有些地方像这像扎包这个应 get 这些地方,最好是把它 单独的作为一个部部件,这是导入的一个内交口,然后我们可以来导入 流到这一块就是 get, 同样我们来点击就是流到, 点击 ok, 流到导入进来了,然后跟着流到这一块的,紧接着是什么呢? 紧接着就是料饼,料饼是这一个 同样来进行逐步的导入,我们可以看到可以找到料理这一个, 这样料饼我们就倒入进来了。 导入料饼之后我们必须下一环节要做的是哪一个呢?不,不是说你单单导入这一个料饼就结束了,而且你必须要导入一个入汤口,因为这是麦克玛当中所必需要的 那个马当中的一个料饼,他是包括什么?包括你本身的一个这一个的料饼,然后包括 一个入汤口这一块,整个一个他的一个体积数, 在这里面我们原先是没有的。因此我们就牵扯到一个要去这怎么样来画料柄的一个问题,就是说用这上面的一个作图工具怎么样来画他的一个入汤口, 这是嗯,以后我们要学习的这一个,这是导入 sto 当一种方法,就是说可以单独的进行,就说导入导入之后我们必须要做的一件事是什么呢?是把所有的 保成为一张表,把所有的保成为一张表, 也可以采用其他的方式,如果说我们导入一个,假如说我们导入一个住建,导入进来以后,然后点击这一个,每一个都要点击保存进行保存,保存 那样比较麻烦,在这边就是我们倒相当于倒完了这些部件以后,我们可以选在这边进行 选择,选择以后我们可以看体积这一选项,因为体积这一他这一元素是麦克马当中最重要的一个元素体,在这里面我们 可以看到他只有一项,其他的因为我们没有保存过来,因此我们要将他进行保存,先退回,我们退一箱先将他保存为一张表, 这是将他保存了过后,我们重新来看他,这样我们就可以看到他的几项已经全部进来了, 每一项已经全部进来,但是我们这样是不全的,因为为什么 我们还少了模具?定模就是前模跟后模。另外如果说你要模拟过程当中要模拟他的一个水路过程的话,那我们还要添加水路。 在初期学习阶段,我们嗯先利用他的一个水路,不模拟他的一个水路过程。在以后的一个课程当中我们来细致的讲解, 现在我们就是要来解决他一个本身的一个 需要去后期的一个,如果说我怎么样去画他的一个模具呢?或者是其他 的像本身他有一个通头这一个环节,就说当我们导入这些进来以后,我们可以看到 麦克马当中他不单单是只要求你有这一个料柄厚度,同时还要有一个就是很重要的一个以内,这一个就是入料口压住当中我们又可以把它叫做冲头的这一个部分。 另外一个麦克马需要注意的是什么?里面 就说他的一个系统默认的一个重力方向是微轴的副的方向,我们这个是 y 轴的副的方向,因此要进行调 调整,那也是就是后后期要学的怎么样去旋转,怎么样去平移。而在这边我们需要知道就是说大体的一个怎么样去操作就可以了。 这是我们一个 sto 档导入的一个简单的一个方法, 按照每一个材料组的分类进行细致的导入。当你导入的一个如果说同类型的材料组有几个,那必须要添加他的一个 矮栗子 想对应的来进行导入, 这是一个简单导入的方法。 好的这一节课就到这边,下一节课我们继续接着这一节课所讲的来进行降解。

47@老罗

猜你喜欢

- 2183天才少年