可灵AI3.0教程

谁能想到一段多角色、有台词、音画同步的影视级视频,现在普通人也能随便生成了。可离 ai 三点零的到来,直接改写了 ai 视频创作的规则, 五秒连续生成,自定义镜头控制、多头音精准适配。这些之前想都不敢想的功能,现在人人都可以轻松上手。接下来就带你解锁可零三点零的最新创作玩法,看完就能直接出片!点开欧米尼创作面板,复制我们准备好的提示时,这里面包括了场景细节、 角色设定、声音、语言动作等等要求,直接粘贴在对花框里。模型选择视频三点零欧米尼,再根据我们自己的需求选择模式时长比例数量,这里我选择一零八零 p 十五秒十六比九,先生成一个试试。在等待了十来分钟后,一个完整的视频就呈现在眼前, 我们来播放看,可以看到视频质感还是很不错的,画面流畅丝滑无卡顿,针针衔接自然不生硬。 人物配音,普通话字正腔圆,美式发音标准,金腔地道不违和,口型也基本贴合,可以说是很优秀了。我们再来看看图片生成,听说三点零版本可以生成四 k 高清图了, 这里我上传了两个卡通形象,让可玲帮我生成一段儿童故事,做成连环画,模型依旧选择图片三点零欧米尼模式,我们就选四 k 比例四比三吧,先试试生成六张,等待几分钟后就好了。你还别说,这生成的儿童连环画确实很高清,画风暖萌治愈,还超贴合童趣, 线条细腻,色彩鲜亮,每一页的画面衔接自然又圆润,一眼就能看出他俩是好朋友,完全贴合儿童的审美和阅读节奏,人物形象灵动可爱, 分镜排版也很舒服,就这点话往平台上一发,妥妥吸引一批家长来看啊!以上就是这次分享的核心技巧,其实他的保障功能还远不止这些, 上手多试几次就能解锁更多创作惊喜,用简单的操作做出高质感的内容。不管是陪娃做趣味连环画,还是自己创作创意视频,可连 ai 三点零都能轻松拿捏。赶紧打开 app 去实操试试,期待大家的神仙作品出炉!

粉丝52.8万获赞298.1万

相关视频

21:32查看AI文稿AI文稿

21:32查看AI文稿AI文稿零基础怎么从零到一制作 ai 视频?这是我今天想和大家分享的内容。明明用着同款 ai 工具,为啥别人的视频能一步到位,完全符合预期,可你呢?调参数, 改提示词,折腾半天,视频却像失控的列车,浪费积分不说,最终效果还全靠运气。别慌,今天这期视频三分钟带你入门, ai 视频制作小白也能轻松上手!入门!话不多说,直接进入正题, 下面我就来介绍一下如何通过四个步骤制作一个 ai 视频。这些步骤包含场景描述、文生图、图生视频和视频剪辑。第一步的场景描述可以用 chat、 七 p t、 文心、一眼通、一千、问豆包等这样的对话类 ai 来生成。第二部文生图对应的有 mid、 journey、 stable、 diffusion、 文心一格通、一万象等。第三部图生视频对应的有 pika、 runway、 pic、 verse, 还有一众国内的视频生成平台。而第四步,我们会使用 工具将生成的视频片段进行剪辑和配音配乐。关于工具可以在我们课程配套的工具资料包当中查找。大家好,我们这节课来讲解可灵 ai 的 视频生成功能。 来到可灵 ai 的 首页,我们点击左侧的视频生成分选项,可以看到当前的页面就是可灵 ai 的 视频生成页面。在最上方有一个下拉菜单,我们在这个位置可以选择不同的视频生成模型。和图片生成模型一样, 通常标号越高的模型生成的效果就越好,所以我们就保持默认的二点一。当然某些模型是不具备部分功能的,例如当前的二点一模型就不具备仅靠伪真生成视频的能力,所以大家也可以根据自己的需求选择更适合的模型。在下方有三个分页,分别是文声视频、图声视频和多模态编辑。 我们首先来看文声视频,顾名思义,文声视频就是我们写出的画面来生成对应的视频。 上节课我们讲过了,可灵 ai 接入了 deep seek 功能,所以当我们不知道该如何描述一幅画面时,也可以直接借助可灵 ai 内置的 deep seek 帮助我们 写一段画面描述提示词用于视频生成。和其他的 ai 视频生成工具不同,可灵 ai 还包含了负面提示词的写入框,不过这个位置并不是必填项,而且就算什么也不写,生成的效果对于崩坏的抑制也非常的好,所以通常这个位置呢就保持默认不填写 在正反面。提示词的右上方有一个预设选项,我们点击展开之后,就会打开预设提示词的选择菜单。如果想要新增预设提示词的话,我们点击展开的右上方的加号,在这里就可以预设提示词,并写明标题, 方便我们后续选择提示词模板。不过这里并不是很建议大家使用文声视频的功能,我们以先前我生成的一段视频为例,我们首先来看这段视频, 可以看到这段视频,它是由纹身视频生成的内容。提示词描述呢是手部特写镜头,女生的手扶过海浪最终呈现的效果,画面有种锐化过度的感觉,并且整个手的美观程度也不尽人意。我们再来看第二段视 频,可以看到这个画面当中的手就明显要好看的多,并且也成功生成了在提示词描述当中手扶过海浪的效果。 而这个视频是以手真图生视频的方式进行生成的,所以在大多数情况下,图生视频要远比文生视频稳定的多,而且本身图片生成的时间和资金成本都比较低,也方便我们先确定图片的风格和质量,再进行图生视频, 能够提高我们制作视频的效率。回到视频生成页面,我们来看最下方,可以看到有这么几个分选项。首先第一个下拉菜单是选择视频的生成模式,标准模式和高品质模式其实对应的就是生成的画质,如果单纯的做视频生成练习的话,选标准模式就好了, 消耗的点数会低一些。第二个下拉菜单是选择视频的生成秒数,目前生成五秒钟左右的视频也偶尔会出现非常不稳定的情况,就更不要说十秒钟的视频了。 所以这里建议大家生成五秒钟的视频就足够了,十秒钟的视频有极大的概率会让人物的运动出现意想不到的结果。第三个下拉菜单是选择视频的宽高比的, 目前纹身视频只有三个宽高比可选,就是我们常用的十六比九,九比十六,还有一比一。再往右边这个下拉菜单是选择一次性生成几条视频的,根据我的生成经验,同样建议大家选择默认的一条视频, 这样方便我们在得到不好的结果时,能够及时地修改提示词或者图片。最后一条创意相关,指的就是生成的视频结果是更符合提示词的描述,还是更偏向于让 ai 自由发挥,这里维持默认就可以。 有时过于遵循提示词的描述,一旦提示词当中有我们没有想到的部分, ai 也不会帮我们生成。相反,让 ai 过多的自由发挥,有时可能会误视我们提示词当中描述的内容。纹身视频的效果通过刚才的短视频我们已经看到过了,所以这里就不再重复演示。我们下面来看图声视频。 这里的图生视频又分为首尾帧和多图参考。我们首先来看首尾帧,这也是我们最常用的一个视频生成方式,它允许我们先上传一张或两张图片作为当前视频的开头或结尾。在上传图片之后,下方的输入框我们输入想要人物做出的动作以及镜头的运镜。 这里有必要说一点,通常图生视频我们就只需要描述人物要做的动作和画面的运镜就可以,至于画面的内容具体是什么,图片已经给到了 ai 充足的信息,不需要我们再重复的描述,除非图片当中某些信息很容易被 ai 误判。 比如一件金属反光质感的衬衫被 ai 误识别成了盔甲,这个时候可能需要靠提示词让生成的视频在运动过程中物品保持一定的稳定。我们下面再来看运动笔刷这个功能, 目前这个功能仅在一点五模型下支持使用,我们点击切换,在切换完成后,我们点击去绘制,就会打开一个新的窗口。通常想要便利的使用这个功能,我们可以勾选上方的自动检测区域,此时我们的光标就会变成一个快速选区比对,我们这里选中人物的头发或者上半身,或者整个的身体。 选中完成以后呢,如果有多选的部分,可以点击左上方的橡皮擦选项,去擦除多选的部分。此时画面当中显示为绿色的区域,就是待会我们需要它运动的区域,这些区域不只可以选中一个。如果画面当中存在多个物品, 我们希望每个物品的运动都受到我们的控制。可以看到右侧一共有六种颜色,可以用来标记六种不同的物品。标记完成后,我们用鼠标点击区域右侧的轨迹选项,此时我们的光标就变成了一根用来汇聚移动轨迹的画笔。 例如我们想要人物朝着画面的左手边去运动,我们就用这个画笔从右向左滑动,此时整个的轨迹就会变成一个往左手边纸上的箭头。 生成视频时,人物就会往左手边这个方向进行移动。在右侧下方这个区域还有一个添加静止区域的选项,也就是说,如果我们不希望画面当中的某样物体运动,我们可以点击静止区域这个选项,然后在左侧的图片中进行会制,这样一来生成的视频结果 我们用静止区域选中的部分就不会发生运动了。确认无物之后,我们点击右下方的确认添加,这样一来生成的结果就会更受我们的控制。在运动笔刷下方还有一个运镜控制,我们点击使用,可以看到此时右侧会弹出一个选择菜单,可以支持我们选择一些常规的运镜, 有水平运镜、垂直运镜、推进拉远或者垂直水平摇镜、旋转运镜等。不过我们可以看到,当我们选择一个运镜方式之后,上面的笔刷运动就会提示与运镜控制互斥,使用后将移除运镜控制的提示。这就意味着两种功能无法同时使用, 大家可以根据自己的需求选择其一。不过经过实测,可连 ai 的 这个功能在控制能力上并没有我们想象当中那么好。与此同时,它所使用的模型版本为一点五版本,与目前的二点一版本在版本号上差距过大,所以生成的视频质量不会特别的好, 因此这个功能我们就仅做了解,不再赘述。我们回到首尾帧,这里刚刚我们只添加了一张图片作为手帧,但其实只要我们的视频模型版本在一点六及以下的话,是可以同时添加首尾帧的,也就是可以控制整个视频的开头和结尾是什么画面。我们以这个视频为例, 可以看到视频当中的狐狸变身为了一个在宫殿当中的少女,之所以会有这样的变身效果,就是得益于首尾针的功能。我们分别生成了两张图片,首针是一个狐狸,而尾针我们生成了一张由这只九尾狐幻化的少女。 这个短视频在生成的时候甚至没有写提示词,就直接达到了这样的效果。由此可见,首尾真生成视频在镜头的过渡上可令 ai 做的还是十分智能的。我们回到视频生成页面来看多图参考,这个选项和图生图的多图参考类似,视频生成的多图参考也允许我们分别上传人物主体、 背景以及画面当中其他需要的元素,最终让这些元素或者风格都出现在生成结果的视频当中。例如此时我们上传一张人物的图片,再上传一只小黄鸡的图片提示词,我们就写少女手捧小黄鸡,然后点击生成,大约五分钟左右,我们的视频就生成好了,来看一看效果如何吧。 可以看到整个视频对于两者的结合还是非常不错的,人物的动作也比较自然,唯一存在一些问题的地方就是手和小黄肌交互的部分,这也是目前绝大多数 ai 视频生成模型的痛点,也就是复杂的结构在与复杂的结构交互时会出现明显的崩坏, 这种情况目前还无法避免,我们只能期待将来视频生成模型能够具备更好的效果。回到视频生成页面,我们最后来看多模态编辑,这个功能也是目前比较少用的一个功能, 他允许我们上传一个视频片段,再上传一张图片,然后通过提示词的描述,将所上传图片当中的某一个内容去替换掉视频当中的某一个内容。我们就以这个视频为例,我们上传一个手轻轻抚摸小牛肚的视频片段。 图片方面,我们依然上传刚刚用过的小黄机提示词,我们就写是图片一中的小黄机替换视频当中的小牛肚,我们可以将鼠标悬置在视频上传窗口的上方,此时右上角就多出了一些图标,分别是编辑从历史选择、本地上传以及删除 后三个都是字面意思,我们来看编辑点击之后呢会展开一个新的窗口,在这个窗口当中我们需要做的事情就是选择增加区域,然后将整个视频片段全部选中,同时点击视频画面,通过自动选区功能将我们需要替换的物品进行选中,然后点击右下方的确定。 至于图片编辑窗口,这里有一个选择主体的功能,点击之后会展开一个窗口,这个窗口就是用来选择框选主体的,如果画面当中有多个物体,我们需要用这个窗口去选择我们需要拿去替换的物品,这里我们也不需要过多的操作, 最后我们直接点击右下方的生成就可以了。 ok, 我 们现在来看一看生成的效果如何吧, 可以看到生成的效果还是非常惊艳的,在将元素进行替换之后,整个手在触摸小黄肌的时候,小黄肌毛发的运动非常自然,并且整个的视频表现也十分稳定。不过相比于正常制作一个图生视频进行元素替换,需要消耗的点数会更高,所以通常这个功能不会用于替换 ai 生成的视频。 更推荐大家实际拍摄一段视频,然后将图片的内容去运作替换实际拍摄视频当中的某项物品,这样的操作会相对更实用一些。我们回到多模态编辑窗口, 除了替换元素之外,可以看到这里还有增加元素、删除元素等操作,这两项功能都是字面意思,具体的操作方法也和我们刚刚讲的没有太多区别,所以这里就不再重复演示。那么到了这里,我们有关于可灵 ai 的 视频生成功能就全部讲解完了, 可以看到这些视频生成功能有好有坏,不同的模型、版本、功能和操作都会对视频生成的结果产生影响。 在众多操作当中,我比较推荐大家使用的依然是徒生视频的方式,先生成手帧、尾帧图片,然后再通过提示词描述让可灵 ai 帮我们生成对应的效果。这样的工作流,无论是最后产出的成品效果,还是时间和资金成本的使用情况, 相比较其他方式而言,都是一种最优的创作方式。我们这节课来讲解可灵 ai 的 音频生成、 ai 试音、 ai 对 口型和视频延长功能。 来到可灵 ai 的 首页,我们点击左侧分选页当中的音效生成,这样就可以来到音效生成的页面,这里提供了两个窗口,其中上方这个窗口是用来写入提示词的,这些提示词用来描述我们想要生成的音效,例如此时我们在这里写入干杯杯子碰撞,然后点击生成, 可以看到片刻之后,可灵 ai 就 为我们生成了四段干杯杯子碰撞相关的音效。我们来试听一下, 可以听出这四段音效其中有三段都生成了不错的杯子碰撞的效果,而其中有一段把杯子碰撞理解成了喝彩, 可见生成的结果依然存在一定的随机性。不过好在生成我们想要效果的概率还是比较高的。我们继续来看下方的上传窗口,这个位置是用来自动给视频配音的,我们需要做的就是点击这个位置,然后上传一段需要进行配音的视频 上传完成后,上方会提示已通过视频匹配到创意描述是否替换,我们点击替换,最后点击右下方的生成, ok, 几十秒后, ai 自动进行的配音就配好了。同样是生成了四段配音,我们分别来看一下效果。 通过这四段配音结果,我们可以感受到由 ai 对 视频自动匹配的音效效果并不尽人意,虽然确实生成了手指抚摸皮毛的效果,也生成了牛叫的效果, 但是这些效果出现的时机和画面中播放的内容并不是十分匹配,部分效果还出现了一些我们不需要的杂音,所以目前可连 ai 自动根据视频匹配音效的功能不推荐大家使用,我们可以期待未来能够优化的更好。 其实相比之下,如果大家不做商用的话,可以直接来到剪映当中,点击上方的音效选项,在这里我们可以根据左侧的标签来选择自己需要获取的配音配乐,也可以直接在上方的搜索栏搜索我们想要的效果。例如我们搜索自行车的效果,这里呢就会显示自行车铃铛、自行车路过等等音效, 点击就可以进行试听。如果需要使用这段音频的话,可以直接将这段音频拖拽到下方的时间轴上,与视频内容进行匹配。 大部分音效都可以在剪映当中的在线素材库里找到,因此目前可灵 ai 的 音效生成功能并不是十分实用。不过如果大家对视频有商用的需求,需要原创一段音频的话,我们使用它的音效生成效果也是可以的。我们接下来再来看 ai 试一功能,点击左侧的 ai 试一分选页,我们就来到了 ai 试一的操作页面。 使用这个功能一共分为两个步骤,第一个步骤就是生成一个 ai 模特,在这里我们选择性别、年龄、肤色以及对这个模特基础造型的描述。当然如果不想生成模特的话,我们也可以直接点击上方的 ai 换装。在二级分页当中有官方预设的模特造型,或者我们点击右侧的自定义分页, 在上方的窗口可以上传一张自定义的模特照片,不过可连 ai 对 我们上传的照片有一定的要求。我们将鼠标悬置在右侧的模特规则这里 可以看到,这里有对图片尺寸、文件大小的要求,同时也给出了推荐图片和不推荐图片的案例,像多人合照、坐姿或者严重遮挡、衣服姿势过于复杂等情况都是不推荐的。想要成功的给模特进行换装,像上方这些单人照、正面全身或者半身 或者未对衣服区域进行遮挡、姿势简单的图片等都是可以的。在下方这个窗口就是上传服装的位置,我们同样将鼠标悬置在服装规则这里,可以看到这里同样描述了对服装图片的尺寸要求、大小要求 以及上传的形式。像平铺的服装、单件的服装、没有遮挡的服装都是推荐的。而像同一张图片,存在多个衣服或者背景过于杂乱,花纹过于复杂,亦或是透视角度过大, 服装重叠遮挡的情况,都是不推荐的。如果我们想一次性上传多个服装,可以在左侧的分选项当中由单件切换为多件,这样就可以分别上传上衣和下装,以此来让模特一次性试穿全身的衣物。我们这里就以官方提供的模特为例,选择好之后, 我们再在下方选择一件官方提供的衣服,在最下方的位置,我们可以选择一次性生成多少张图片,以及图片的清晰度如何。选择完成之后,我们就直接点击立即生成, 可以看到最终生成的效果还是非常出色的,不仅完整的保留了人物的长相特征,同时像衣服的款式以及穿戴之后的光影效果都还原的十分自然,甚至生成的结果还非常贴心的给这件上衣搭配了一件颜色和款式匹配的裤子。 我们回到生成页面,在 ai 十一操作面板的右上方有一个使用指南,我们点击之后就可以来到可灵 ai 使用指南 ai 十一的页面,在这个页面我们可以查看 ai 十一这个功能的介绍以及使用指南和注意事项,以此来学习这个功能。同时官方也提供了一些视频教程, 我们下面再来讲解可灵 ai 的 对口型功能,不同于 ai 数字人让图片开口说话,对口型功能是让视频当中原本没有说话的人物开口说话,并根据说话的内容来生成对应的口型。要想使用这个功能有两种方式,第一种方式,如果我们生成的视频是一个人物正面的近景特写, 我们就可以使用这个功能。可以看到在右侧的预览窗口,视频的下方有一个对口型的选项,我们点击之后就可以来到对口型的页面,当然我们也可以手动的点击左侧的对口型选项,来到当前的页面,这个页面存在两个上传文件的窗口,其中上方这个窗口是用来上传视频文件的, 我们这里就选择一个官方推荐的视频,将视频上传以后会弹出一个窗口,在这个窗口当中我们可以预览视频的效果。 同时在窗口的右侧我们可以选择用 ai 进行配音或者上传本地的配音文件。如果我们选择用 ai 进行配音的话,可以在这个位置输入需要配音的内容,例如我们输入接天连夜无穷碧,映日荷花别样红。 输入好内容之后,在下方我们选择配音的音色,点击之后就可以试听接天连夜无穷碧,映日荷花别样红。每一种音色都可以在下方调节它的语速, 以适配视频的时长。除此之外,部分音色是可以调节朗读时的感情的,例如我们将下方的感情调整为高兴,然后再次点击试听接天连夜无穷碧,映日荷花别样红,可以明显感受到人物的语气变得更加开心了。 当然朗读诗歌我们就以中性的情绪来朗读就可以,至于上传本地配音的话,我们就直接点击上传或者拖拽的形式上传到这个窗口当中就可以了, 们这次演示就直接用 ai 来生成朗读的内容吧。确认好配音内容和音色情绪之后,我们点击右下方的添加配音,可以看到此时左侧的预览窗口下方会出现音频的时间轴,我们配音的总时长是四点五秒,因此并不是人物全程都在开口说话的,可以通过鼠标拖拽的方式来移动配音的位置, 以此来决定人物在什么时间段开口说话。确认无物之后,我们就直接点击右下方的立即生成,等待一段时间后视频就生成好了,我们来看一看最终对口型的效果吧。接天连夜无穷碧, 映日荷花别样红。可以看到,尤其是对于这种近景特写,人物朗读的内容和 ai 生成的口型还是十分匹配的。 我们最后再来看一看可灵 ai 的 视频延长功能,我们点击左侧的视频延长分选项,来到视频延长的操作界面。顾名思义,视频延长就是将已有的视频在结束时进行延长拓展,通过提示词的描述来延续视频的内容, 其实就相当于将一个视频结束时的画面作为图升视频时的手帧来生成新的画面。不过当前这个功能就只支持我们从历史创作中去选择,我们就以这个视频为例,先来查看一下这个视频的效果, 可以看到当前这个视频就是一个简单的人物动态效果,我们可以尝试将这个视频进行延长内容,我们就描述 人物伸手挡住镜头,镜头变暗。如果觉得自己的提示词描述内容并不能得到理想的效果,也可以通过 deepsea 来优化我们的描述。最后我们在下方选择相应的参数,然后直接点击立即生成。 ok, 延长后的视频生成好了,我们来看一看效果如何吧。 可以看到最终生成的效果还是十分流畅的,不仅在后半段相对的符合提示词的描述,同时在第五秒和第六秒之间, 就是原视频和延长视频之间的衔接处也并没有发生明显的衔接卡顿或者是画面突变的情况。因此,各位同学想要延长某一个由 ai 生成的视频片段的话,不妨尝试一下视频延长功能,效果还是不错的。那么以上就是本视频的全部内容了,到了这里,有关于可怜 ai 的 全部内容也都给大家讲解完了。 可以感受到,虽然可怜 ai 主打的是一个视频生成,但像图片生成、图片编辑、对口型视频延长等功能,使用的体验和生成的效果也都相当不错。其实我们的视频更新到这里, 已经和大家一起看了不少 ai 视频创作平台,也鉴赏了很多其他作者生成的优秀短片。我们不难发现,虽然每个视频平台有着不同的功能和视频生成的特性,但最终想要取得好的 ai 视频生成工具, 在给人们带来便利的同时,也对使用它的人提出了更高的要求。 ai 时代是一个容易诞生超级个体的时代,繁琐枯燥的工作被 ai 接管之后,人的价值会更加突出。因此,如何让自己的思维能力和学习能力在更深更广的维度上实现突破,这才是我们需要聚焦的问题。

376AI视频制作教学 23:20查看AI文稿AI文稿

23:20查看AI文稿AI文稿各位好,欢迎收看本期视频,本期内容非常劲爆,因为可灵三点零刚刚震撼发布,未经抢先体验了四天,为了测试这个新模型,我已在可灵上毫至四万积分为大家测到极限,这样大家就能通过这个短视频快速掌握我们这四天摸索出的所有干货。 所以本期视频我会展示我们生成的所有最佳作品,然后会毫无保留的分享所有提示词。我们还会拆解摸索出的各个关键点,这些技巧能实实在在的帮你大幅提升生成效果。废话不多说,直接上干货,这些都是我们这几天搞到的最佳作品。 welcome to cling 3.0, she tell me at your puppet arms it's game time okay, i have to show you guys my new signature scent because it is literally a dream, it's so light and floral, but it stays on all day look at that mist seriously if you love vanilla jasmine you need this in your life link's in my bio they tried to silence me, but i know what i saw i love the new cling 3.0 model it's beautiful! 效果相当炸裂对吧?所以我们实际上已经生成了海量视频,接下来我就带大家一一盘点其中最出色的那些作品。那么可零三点零和它的前代版本可零二点六相比, 主要升级了哪些地方?嗯,这次升级可以说是质的飞跃,因为现在你可以生成最长十五秒的视频了,而且你还能在场景中加入多个镜头切换,并且人物对话的口音可以非常地道。 说到这个非常地道的口音,我们不妨想想其他那些也能让角色开口说话的视频生成模型。比如我们就会想到 google 的 vivo 三, 不过 google vivo 三也有它的局限性,因为它生成的声音听起来很单薄,机器人感太重。自 vivo 三点一版本发布以来,我们并未进行太多重大升级,因此这个新模型在语音对话方面有了质的飞跃, 他能处理多种口音和语言,这功能相当给力,因此大家可以尽情去探索和把玩这个新功能。现在你甚至可以为视频添加描述性音效,你可以通过输入提示词,让特定的音效出现在视频里。 比如在这个开场镜头中,我们就特意输入提示词,要求生成一个特定的音效。要生成这个音效,我们只需输入 sfx, 然后加上冒号,再输入描述。比如一种巨大的能量充能音效,如同涡轮全速运转,这个音效打破了最后一帧画面的寂静,于是我们就成功生成了这个特定的音效,效果拔群, 大家能听到那种轰的低音音效,非常有穿透力。这正是因为我们在场景描述中特意加入了这段提示,所以这个功能同样非常酷炫。 接下来这个新模型的另一大优势想必大家刚才也看到了,那就是你可以对同一场景的不同部分进行剪辑,并保持高度的一致性。例如,如果你的视频里有一个角色,你想切一个他嘴唇的特写镜头, 现在你就能轻松实现。如果你想切换不同的侧面特写和拍摄角度升降镜头,你想怎么拍就怎么拍。所有这些操作都可以在你设定的任意时长内完成,你还可以生成短至三秒的视频, 不必非得生成十秒或五秒那么长的视频,而这在旧版模型里是硬性要求,所以这无疑也是一大优势。接下来这个镜头大家注意看,我们成功实现了一种前所未有的效果,酷似机械臂操控相机快速变焦推进。这种效果在 ai 生成的视频里 可是头一回见,所以我想重点讲解一下,并原原本本地告诉大家我们用的提示词,这样你们也能在自己的项目里用上它,牢牢抓住观众的视线。那么要生成这个效果,我们用的提示词一字不差。是这样的,提示词是镜头快速从左向右横向平移, 紧接着一个急促的推向面部特写大家看,如果我们从头播放,效果是这样的, 瞧,镜头先是这样向右横移,然后猛地推向面部,而且你还可以在视频中精确指定时间点,来让你想要的特定效果在那个时刻出现。因此我们设定的参数范围是零点五到零点八。 这意味着它必须在极短时间内跟上那种疯狂的镜头运动,因此它会迅速完成动作,让你得到那种超酷的机械感效果。接下来我们设定了快速拉远镜头,以及一个从右到左的快速横移,不要环绕物体的圆周运动。机械臂摄像机控制 加速要干净利落,但不能有抖动,面部保持稳定,辫子保持完好,服装不能出现违影。所以我们这里其实用上了一点负面提示的技巧。 所谓负面提示,说白了就是告诉 ai 我 们不想看到什么情况发生。我们的做法就是直接说不要抖动,确保面部稳定,辫子保持原样,还有服装不能有违,这基本上就是说衣服不会变形,也不会凭空多出些奇怪的东西。这样一来,我们就得到了这种超酷的镜头效果,说真的,看起来帅呆了。 接下来是这个我剪辑在一起的小片段,其实它是由三个独立的视频组成的。做这个的时候,我只用了 google nano banana pro 来生成一张我戴着美式橄榄球风格面罩的图片,因为超级碗快到了,我觉得这个主题挺应景的。而我们给可灵 ai 模型的唯一指令就是它愤怒地大喊,比赛时间到了对吧?结果出来了, 确实让人没要求,但它居然自动加了剪辑进去。 说实话,我不但不生气,反而觉得效果挺不错的。接下来这个镜头,我们其实尝试了好几种不同的拍摄方案。 现在用可灵的新模型,你可以用那种自定义提示生成器。 hicks field 也有类似功能,就是你可以把整个视频的镜头规划都写进去。也就是说,你可以在描述第一个镜头时,用一段话把你想呈现的画面写清楚, 然后下一段话描述下一个镜头。就这样,一个个镜头规划下去,你还可以上传一个起始画面,用它来定下整个视频的基调、艺术风格这些要素。就拿这个例子来说,我们上传的第一帧画面是一群美式橄榄球运动员即将走出通道。 我们给的提示词,嗯,内容相当丰富,我们会在视频简介里留下链接,所有用到的提示词你都能看到。云桥网络频道免费获取提示词我们确实为第一部分写了这么一段复杂的提示词,并且还指定了它的时长只有一秒,也就是说,我们可以自主设定这个片段第一部分的时长, 来看看效果。第一秒就是刚才看到的画面。第二部分我们设定了手持拍摄的晃动感镜头,快速且不那么完美的摇移,还带点轻微的变焦。所有这些动感十足的效果都是我们通过提示词实现的。顺便说一句,如果你不擅长写提示词,别担心, 我会把我们用来出这些效果的。自定义 gpt 工具分享给你。云桥网络频道免费获取自定义 gpt, 这是个超级好用的资源,能帮你轻松做出非常棒的效果。于是我们在这里设定了两秒的提示时长,我们希望那个小片段能在那个位置呈现出来。 接着就是第三个镜头,这个镜头呈现出一种将所有动作镜头拼接组合的效果,画面充满了这种充满动感的运动模糊风格, 这太棒了!因为我们现在能通过提示词在视频中直接生成运动模糊效果。搁以前,这根本是想都别想的事,像 google、 vivo、 三核可灵这类以前的模型压根就不支持运动模糊效果,它们总会自动把画面修复得清晰平稳。但用了这个新模型, 我们终于能如愿以偿地实现它了。这样一来,我们就能在视频里加入自定义的视觉特效了。这功能简直太实用了,这在我们制作高动态动作场景时尤其管用。来看下一个场景,一位运动员正在此处奔跑,他正全力向前冲刺。 大家请看,当我们播放这段时,可以看到他奔跑而过,同时镜头向下摇,跟拍他的双腿。如果我再从头放一遍,这段镜头的运动非常流畅,手持感十足,看起来超级真实。说真的,这效果简直绝了。 接下来,这个镜头色彩更丰富,更具照片写实感的纪录片风格,镜头带有手持拍摄的感觉,我们为此使用的提示词是一个照片即写实的连续视频镜头场景设定在一个夜间举行冠军决赛、人潮汹涌的美式橄榄球大型体育场内。我们还为不同的参赛队伍设定了外观提示。 不过关于摄像机运动,最核心的提示要求是,就是要切实呈现出那种紧迫感和混乱感,并且让摄像机运动带有轻微的晃动和即时应激般的抖动。于是我们得到了这个非常精彩的镜头。 我觉得这效果简直绝了,并为即将发生的精彩事件做足了铺垫。这里我们还实现了非常美妙的前景深效果,摄像机焦点对准了前景的主体背景,也呈现出漂亮的虚化效果。但你会发现,之所以效果如此出色,首先它在艺术上的完整性就非常棒, 色彩看起来惊艳夺目,非常出彩,没有变形,真的是一点变形都没有。而这在很大程度上要归功于我们非常扎实的提示词。 所以先别急,在视频结尾,我们会给大家奉上那个免费的提示词工具。不过我想带大家深入剖析一下,为什么这些视频个个都效果拔群?因为等各位以后自己动手生成内容时,这些洞察会非常有用。 接下来这个简直让我惊掉了下巴。所以说,这简直是当下制作 u g c 内容的一款神器。想象一下,制作一条十五秒长的咪塔平台广告,你可以随心所欲地切到任何想要的场景,并且能保持超高的画面一致性。 要知道,在这之前你只能用 sara。 sara 在 模拟人类表演方面功力深厚,但我认为这个新模型在这方面的表现更是堪称惊艳,这也就是它看起来如此逼真的又一原因。因为其中的人类表演效果 比起前代模型有了质的提升。那么有了这个工具,我们自然可以通过提示词进行控制。大家看这里的提示词,实际上我们已经像这样为它添加了时间编码。例如,我们设定了从零秒到四秒这个片段,然后又设定了四秒之后的下一个镜头。而且我们还可以为每一个时间片段指定镜头的风格。 例如第一个镜头,我们使用了一个定场中景,镜头背景是一间卧室,你就能用这个工具来制作十五秒长的 ugc 风格咪塔平台广告。你可以先用 google nano banana pro 来构思你的画面,确保产品风格统一,一切就绪。构思好画面后,把它上传到可灵,然后你就能得到这些惊艳的效果。 接下来就让我们看看实际效果。 okay, i have to show you guys my new signature scent because it is literally a dream, it's so light and floral but it stays on all day look at that mist seriously if you love vanilla and jasmine you need this in your life links in my。 这效果太牛了! 说真的,我觉得这简直让人目瞪口呆。大家可以看到,在提示词里,我们连音效也一并设定了轻柔明快的原声吉他旋律,这一点也很有意思, 你甚至可以直接在视频里指定想要的音乐,这意味着你都不用费心去找符合氛围的背景音乐了,直接交给 ai 来搞定就行。也就是说,你不仅能设定对话音效和音乐,还能实现口型同步和丰富的视觉效果。 这真是一个划时代的模型,我们现在能用它玩出太多花样了。我感觉在过去的四天里,我们就像是在揭开它神秘的面纱,并且我们要从中发掘尽可能多的价值。但我认为这将是一个巨大的革命性的突破, 未来将涌现出大量的中小企业,他们都将急需这些特定的技能。而现在有了这个新模型,你就能轻而易举地满足他们的需求。因此,这其中蕴藏着巨大的商机,等着你去把握 好了。言归正传,我想带大家看看这个镜头。现在这个更多是从电影制作的角度来分析的,因为这个镜头我想试试看我们能不能做出一些特效,让火焰从中世纪那种小火把里窜出来。首先,这个镜头要是用传统方法拍,不知道得安剂多少次,烧掉多少钱。咱们直接播放一起看看效果。 they think me fragile porcelain but porcelain shatters blades。 注意到没,整个镜头力火焰一直在陆续点燃,这效果真是绝了。而且我觉得我们当时的提示词力肯定包含了这个要求,再提醒一下所有提示词,银桥网络频道免费获取!这镜头简直神了对吧?台词也写的超棒,演技更是让我惊掉下巴。 要知道,能让他说出这样的台词,我们还专门提示了特定的音效,心跳声、重击声,在整体音效设计中微弱的加速,随后声音戛然而止,一片寂静。他压低声音,嗓音低沉而冷峻。接着我们还针对他的嗓音部分给出了具体的提示,当然,自定义提示助手能帮你搞定这些。再来看一个蓄势案例。 这张图是由谷歌 nano banana pro 生成的单张图像,不过我想这张图其实是用 mik jennie 生成的。然后我们把它导入到可灵模型里,我们针对它生成了各种不同的角度和镜头。那么我们一起来看一下吧! they tried to silence me, but i know what i saw i love the new cling 3.0 model it's beautiful! 说真的,太震撼了对吧?光是看看这人眼睛里的细节就已经叹为观止了。要知道,如果我们再仔细看看他的一致性和真实感,比如你甚至能拼判断出他们脸上特定的雀斑和斑点, 你会发现这些细节从头到尾都保持绝对一致,对吧?看他鼻梁这有个小印记,脸颊这也有个小印记,即使镜头拉近,同样的印记依然清晰可见。鼻子上有相同的印记,所以确实让人叹为观止。接下来这个我是真想测试一下它的性能极限以及角色的演技,看看我们能创造出多么逼真的效果。 我还想试试看能不能做出一个酷炫的转场镜头,在这个镜头里,角色将饮料泼向镜头,看看液体与镜头会产生怎样的互动效果。那么我们一起来看下效果。 so you want the a i t。 好 的,但就液体效果来说,这已经相当惊艳了。视频的最后一针液体确实见到了,镜头上视觉效果简直炸裂。不仅如此,角色本身的演技也相当出彩, 声音也和角色很搭,连口音也是我们特意提示生成的,这简直太神了。另外,这个模型在音效和音乐方面也很有意思。这里有两个镜头起始画面是一样的,我想给大家看看他们的不同之处,以及从同一个起始画面能衍生出怎样不同的电影风格。那么一起来看看吧! we keep it moving i'm focused yeah cut to cut! cut to cut! 以前, 当你使用像 google vo 三这类模型时,你可以切换到另一个场景,但现在你连切换到这个提示词都不用打了。 实际上你可以直接用镜头制作器,要知道可琳已经内置了这个功能, hix 六也有这个功能,所以你基本上可以分别为每个镜头写下提示描述。如果你只想用一个总的提示词来搞定,也可以这样操作。你可以在提示词里写上跳切档, 然后你大可以写下接下来你想发生的任何情节,然后它就会自动切换到下一个场景。所以我们现在就像导演一样在发号施令。我们就像导演在精心打磨每一个镜头,而不是拘泥于一张图一次提示的旧模式。我们现在是生成一张基础图, 然后指挥所有不同的镜头系列全在一次生成里搞定,非常方便,帮你省下大把时间。要知道用 ai 生图来攒素材。全在一次生成里搞定,非常方便,帮你省下大把时间。要找准 x、 y、 z 这三个角度,得费不少功夫。 现在好了,在可灵力一次生成就能全部搞定,这无疑让可灵如虎添翼,实力大增。我一直是他们模型的头号粉丝,赞不绝口,而且我真心觉得这款模型目前绝对是业界顶尖水平,真是太让人兴奋了。 接下来看下一个镜头,这个场景呢,我们用的是同一个起始画面,但我们输入的提示词是这样的,我们其实是想做一个反向推进,穿过粉丝群的镜头,明白吧?而且粉丝们全都高举双手,我们还想要手机屏幕那种虚化的光斑效果,对吧?结果我们真的得到了这个超酷的镜头, 大家看,这里全是粉丝们举起的手,手机形成的漂亮光斑虚化效果也出来了,看起来特别酷,电影感十足。 这说明仅仅用一张参考图,你就能创造出不同风格的镜头。接下来我们继续玩转电影感,比方说如果我们想打造一个很酷的镜头系列,里面包含一些升降镜头,比如从高处缓缓降下的那种, 或者我们直接在这里输入提示词,那么我们来看看这个视频系列,所以画面里这个人在点烟, 接着是一个向后拉穿过战壕的镜头,然后这里有一个非常棒的摄影机游壁上摇镜头,而这又是一个独立的生成镜头,紧接在刚才那个镜头之后,镜头立摄影机摇壁向下摇入战壕。这里有一个非常棒的低角度手持拍摄的晃动场景,看看这效果有多逼真,简直绝了! 请注意,这实际上是纯文本生成视频,也就是说这不是基于图像生成的,我们这次完全是直接用文本提示词来生成视频的。我觉得测试和探索这个功能还挺有意思的,也就是说这个模型不仅能图生视频,还能纹身视频。所以刚才大家看到的就是一个纹身视频的成果。 接下来我们看到的这个生成效果,可以预览手帧和尾帧,因为这个新模型确实自带首尾帧预览功能。如果你是我们 instagram 内容的粉丝,那你肯定清楚我有多爱首尾帧预览这个功能,这几乎是我们所有视频里都会用到的功能。大家看这里, 这简直是史诗级的巨大升级。大家可以看到镜头一个非常漂亮的弧线环绕着这位女孩,她面部的细节,眼中的倒影,一切都恰到好处, 浑然天成。说真的,如今能做到这种效果,简直让人叹为观止,这效果真的太震撼了。接下来这个镜头是我在测试运动模糊效果,同时我也想试试用镜头变焦能把细节呈现到什么程度。在这个镜头里,整条街道都充满了炫酷的运动模糊效果。然后注意看这里,镜头有一个非常漂亮的推进 植逼睫毛,所能捕捉到的细节堪称惊人。为了得到这个效果,我们输入的提示词是驾驶员颧骨处的车内仪表盘水平轮廓跟胶。这基本上就是指镜头改变对焦距离和焦距的过程,从而能够对准场景中不同的物体。因此 我们实现了一个从睫毛到捕捉挡风玻璃散景中仪表盘 led 灯的根雕效果。大家看这里就有挡风玻璃产生的散景就是那些圆形的朦胧的光斑效果。我还输入了提示,让速度在灯光巴士穿过画面时从四十渐变到一百,最终以一个推向瞳孔的微距镜头结束。 现在你已经知道提示语的具体内容了,咱们再一起回看这段视频。大家看画面里这些动态效果是不是特别炫酷?再看这个从四十到一百的速度渐变效果,看起来简直绝了。 下面这个镜头我继续尝试了运动模糊效果,想试试看能不能拍出那种醉醺醺的视觉效果。这在以前很难实现,但现在借助 ai 技术已经可以做到了。 朋友们,趣事创作的方式即将迎来翻天覆地的变化,几乎是想要什么效果就能实现什么效果。这个全新的模型真的让我超级兴奋,它将为我们开拓出无限的可能性,希望你们一路看下来能收获不少干货,我们会尽全力,尽快为大家带来更多实用的 ai 教程。 非常感谢大家能坚持看到这里。对了,这是最后一个镜头,我着重呈现了角色的表演,大家仔细看这个效果, how can it not be real? what is this new model? come on, think about it and do not lie to me? 啊!简直难以置信,是不是真的超乎想象! 接下来更精彩的要来了,当我给你念这段提示词的时候,我先念一下开头部分,让你先了解一下背景情况,看看这个模型在理解特定手势方面到底有多厉害。所以当你开始细致入微的描述角色表演时,你就会发现它到底有多牛。 那么提示词的内容是这样的,这个男人显得越来越焦躁不安,就好像他刚刚听到的全是胡扯。他摇了摇头,然后开始抗议,双臂张开,像是在法庭上据理辩论。 接着他走进摄像机,然后用沙哑的嗓音抛出了一个意味深长的问题。所以当你了解了所有这些背景信息后,现在你再回看这段视频,我会一边播放一边给大家解说,你就能看出他到底有多犟了,对吧?他靠近了摄像机,他的双臂像这样张开,我们提示的所有细节都完美呈现出来了。 所以这款新模型对提示的遵循能力简直令人惊叹,效果确实非常震撼。现在我们来看看这个为你打造的免费定制 gpt。 我 们专门为你打造的,正是基于这款全新的模型,因为我想确保你能把它的功能发挥到极致。那么眼前这个就是定制 gpt 我 们已经做好的, 它底层用的是谷歌的 gemini 模型,而你只需要上传你想要的起始画面。举个例子,我们可以点开这里的希格斯场,再进入图像选项,然后下载一张你最近生成的图像,就是用 nano banana pro 生成的。 比方说,我随手下载了这里的一张图,瞧,我们就有这张图了。这画面里是马格努斯卡尔森正在下棋,它脸上汗如雨下。现在如果我想把这张图上传到这个定制 g p t 小 助手里面,接着我们可以输入指令,比如 我想要玛格努斯卡尔森的脸上慢慢渗出汗水,同时镜头缓缓推进,然后直接点击生成按钮即可。现在系统会开始为我们分析,大家看这里,实际上它会生成几个不同的精彩事例。 首先我们来看电影级运镜这个选项,它模拟的是使用轨道车进行的物理摄像机运动。你只需点击复制,然后转到希格斯场工具里,就可以针对性地输入这段提示词,直接上传进去就行。粘贴你的提示词就可以开始生成了。 这个自定义的宝石功能会提供好几种不同的选项,比如,如果你想要一个固定支点的效果,配合慢速倾斜,你就可以复制对应的代码。还有镜头与对焦相关的操作,比如前景深和变焦效果,所以它甚至能告诉你它最擅长什么,最适合用来突出微观细节。 所以如果我们想聚焦于比如说汗水这个细节,你会看到类似这样的提示。因此,慢速光学变焦结合前景深,镜头逐渐放大人物面部特征,同时背景进一步虚化, 焦点始终牢牢锁定在眼睛和汗珠上,保持极度清晰。随着汗珠在他皮肤上缓缓滑落,营造出一种令人窒息的专注或压迫感。所以这功能有趣的地方在于,你甚至可以把所有这些提示组合起来使用。 所以如果你想进一步给它们加上时间码,比如说,比方说我们想再次把图片上传到这里,我正在生成一段十五秒的视频,在前四秒, 那么就为这个时间段加上时间吧。我希望有一个慢速的推拉变焦镜头,汗水缓缓从他脸上留下,然后在接下来的镜头里,我希望镜头拉远,这个镜头大概持续三秒。接着我想要一个这个男人手的微距特写,手放在一个棋子上方,然后他慢慢的将棋子向前移动一格, 接着画面切回他的脸部特写。他显得忧心忡忡,还下意识地摸了摸下巴。这样我们就能把所有这些内容一股哪粘贴进来。现在他就要开始分析所有这些信息了。瞧,他已经自动给所有内容都加上了时间戳,这样我们就有了零到四秒这个片段, 直接复制,然后粘贴进去就行。接着复制下一段,也就是四到七秒的部分,同样粘贴进去。再接下来处理七秒到十五秒的这一段。 关于这个自定义工具 gem, 有 件事我得提一下,它偶尔会多出一些像 side 这样的标记,直接删掉就好。我们其实也尝试过修复这个 bug, 但这算是我们为你打造的这个自定义 gpt 或者说 gem 的 一个小局限吧。所以你只需要找到方括号里的 side, 手动删除即可。 然后复制这整段提示词,粘贴到 hack field 里就大功告成了。灵巧网络频道免费获取 g e m。 看,这就是我们刚才输入的提示词所生成的视觉画面,这样一来,你就能看到这个场景序列开始活灵活现了。

206云桥网络 00:51查看AI文稿AI文稿

00:51查看AI文稿AI文稿老爹,你最辉煌的时刻是什么时候?我的选手生命难道就这样结束了吗?难道说以后再也不可以打篮球了吗? 请问你喜欢打篮球吗? 非常喜欢,这次绝不说谎。老爹,你最辉煌的时刻是什么时候?是代表国家队的时候吗?而我就是现在。 麻烦你换人。

1.4万颜良文丑Jackie 15:43查看AI文稿AI文稿

15:43查看AI文稿AI文稿刻印三点零终于来了,我简直激动坏了,把它跟 vivo 三点一这类工具比比看到底谁更胜一筹?还有,跟之前的刻印老版本和 sora 二相比又如何?首先要使用这个功能,请点击这里的视频模块。 进入后,这里就会显示 ai 三点零模型。你也可以直接在这里选择模型或者切换到 ai 标签页。然后你会看到可供选择的模型,包括 ai 三点零和 ai 三。 ziramni 这个新推出的 ai 参考功能允许你上传一个视频或其他元素作为参考素材。此外还提供了 ai 编辑功能。 现在让我来为你一步步演示这些功能。首先,这个三点零版本很可能就是你最常使用的通用模型。在这里你可以设置起始帧与结束帧,并且使用多镜头拍摄功能。 多镜头是个关键功能,因为它能让你在一个视频里融入不同的场景。我来操作给你看就懂了。 new model just dropped it's clean they just dropped 3.0 and it's insane。 看到了吧,这就是多镜头功能的效果。上面那个视频我是这么做的。如果我复制这个项目的设置,你就能在这里看到多镜头选项。 看界面左边,这里列出了镜头一、镜头二和镜头三,而且你还可以继续添加更多镜头。说白了,你可以把一个十五秒的视频拆分成若干段,每段最长五秒。 因此你可以自由设定每个镜头的时长,但最长不得超过五秒。接下来,你可以对每一个镜头都进行同样的操作,而且每个镜头你都可以设定一个起始画面。你还能添加各种元素,甚至亲手打造专属元素。 举个例子,我自己就做了一个元素,就是这个红牛罐,我拿它来测试,看看整个流程效果如何。那么当你点击添加按钮时,你还可以去引用那个起始画面、红牛罐,或者你添加的任何其他元素。关于使用这个多镜头功能,我最好的建议就是像平常聊天那样去写提示词。 具体来说,我用的就是这个工具。这绝对不是广告,这只是我日常都在用的一个工具,叫 whisper flow。 它的功能很简单,我只要按住一个键就能开始说话。 我来给你演示一下。你看,我现在就按着这个键。如你所见,界面底部正在录制我的麦克风声音,然后我一松手,它就会开始描述或转写我刚说的话。我写提示词的时候用的就是这个方法,这能帮我省下大把时间。 再强调一遍,不是广告,纯粹觉得这个写提示词的小技巧很有用,分享给大家。说白了,每个镜头你都可以描述成不同的拍摄类型。比如我第一个镜头就从特写开始, 接下来是一个过肩镜头,接着再来一个特写镜头。你应该把每个镜头都视作一次微剪辑,如果觉得某个镜头太长,直接像这样缩短就行, 这样镜头的时长也就随之改变了。这样一来,你基本上可以制作各种时长一两秒的镜头。此外,你还可以添加多个不同的镜头。 我记得上线是六个箭头,也就是说,你在提示。此例最多可以描述六个不同的场景,每个大概两秒左右。创建方法就是这样,接下来选择分辨率,支持七百二十 p 或一零八零 p。 在 我看来,眼下这个功能很可能是你玩转柯影三点零时最常用的功能了。下面我给大家看几个我生成的例子, 比如这个一只大熊猫,我们来看看。 哇,看完我觉得这也太可爱了吧,现在我来试试看它能不能搞点破坏。大家可以看到,我这里生成了两个不同的镜头。我们先看第一个, 看这里就用上了多镜头拍摄手法,现在这个镜头效果可能会更好一些。 好了,展示完毕。你可能一直梦想着看大熊猫如何大闹成事, 现在角色对话也变得更自然了。目前唯一让我有点头疼的就是口型同步还差点意思。我来给你演示一下具体是什么问题,我们来看看这个镜头。这是一个由多个镜头合成的画面,具体到这个镜头,我用了四个不同的分镜来合成,我反复生成了好几次才得到满意的效果。 我先用了一个广角镜头,接着是一个中近景,然后是一个特写,接着又是一个特写,我们来看一下效果。 you know why i'm here i want my money now give me more time i'll get it you don't have time anymore。 这里面部的一致性保持的相当不错,我见过有些案例部特征在过程中会有些变化,但总的来说,眼前这个已经是最差的情况了。就我们目前看到的效果来说,这简直不可思议。 在我看来,用这个工具完全可以生成高质量的内容,而且还能一次性生成多个不同的镜头画面,仅凭一个提示词或一次生成就能做到,这简直太牛了。不过现在让我再给大家展示几个其他的功能,这些都是你现在可以用全新的 kine 三点零来实现的。 首先,大家可能没注意到,如果你把这个开关关掉,那么你就会看到一个普通的提示词输入框,这样你就可以像往常一样操作了。 你可以输入提示词,然后生成最长大约十五秒的视频。所以能生成十五秒视频是这里的一个新特性。通常你只能生成十秒的视频,而现在我们可以生成十五秒的了。我喜欢这个十五秒时长的地方在于,现在你可以创作更长的连续场景了。 通常我看到的所有 ai 生成的电影,每隔五到十秒就会出现一次剪辑切换,那是因为之前只能生成五到十秒长的视频片段,而现在你可以生成更长的视频了。唯一的问题是,正如你在这里看到的画面出现了一些变形, 理想情况下你最好把那段剪掉,所以你可能得重跑一遍,或者多试几次,这可能会让你多花点积分。 说到积分,咱们来聊聊这个模型到底有多烧钱。所以目前来看,生成一个十五秒的视频需要花掉三十积分。如果拿它跟颗印二点六比的话,价格其实差不多。这边是花二十积分得十秒,这边也是花二十积分得十秒,所以换算下来,每个模型都是每五秒十积分,所以价格是一样的。 所以从使用额度来看,它和刻印二点六一模一样,但它的实际表现到底比二点六强在哪里呢?别急,我稍后就给大家演示一下。咱们先来深入聊聊它的几个新功能。接下来的另一大亮点就是刻印三点零安尼功能。 通过这个功能,你可以在视频里添加最多七张图片或各种元素。比如你可以添加图片,什么格式的图片都行。也可以添加元素,比如像我这样的虚拟人物,也可以是其他类型的元素。 再举个具体例子,比如我手边这本红色的书,就可以把它作为元素来使用。然后再输入提示词的时候,你还可以通过输入特定指令来标记这些元素,然后在提示词里直接调用它们,无论是图片还是其他任何你想放进视频里的东西。 这样一来,你对视频内容的掌控力就大大增强了,能更精准的决定视频力呈现的内容。可惜我最近遇到点小麻烦,所以还没能把它完整的测一遍。不过我还是生成了几个其他的样例,想跟大家分享一下。首先,据说它的音频效果有所提升,那我们就用这个视频来实际测测看。 emily, if you see this then i'm sorry, i love you and please, please don't look for me the infection is spreading everywhere and it's too dangerous to go outside remember that mama loves you。 我是 说这个效果明显不如之前那个。不过话说回来,这个听起来还挺不错的,但我们要真正比个高下,对吧?就是拿它跟科隐二点六比一比,还有 google v o 三 one, 那 咱们就来比一比。我用了相同的提示词和参考图,这是科隐二点六生成的效果。 emily, if you see this, then i'm sorry, i love you and please, please don't look for me the infection is spreading everywhere and it's too dangerous to go outside remember that baba loves you。 说真的,这个版本比上一个差远了,上一个也就是三点零版本简直强太多了。咱们来比比看它和谷歌微 dior 三点一谁更牛? emily, if you see this, then i'm sorry, i love you and please please。 效果还不错,但那谷子谷歌微 dior 的 味儿太冲了。怎么说呢,我基本上一听就能分辨出来,就算你把各种视频摆在我面前,我只听不看角色,一开口你就能听出那是谷歌微 dior 三点一的动静,这个视频也不例外,一听就是它。 出于好奇,我也试了试用科影零一来生成会是什么效果,就想看看有没有区别,毕竟它也是新出的模型。 emily, if you see this, then i'm sorry, i love you and please, please don't look for me infection is spreading everywhere and it's too dangerous to go outside remember that mama loves you。 光从刚才这个测试你就能听出来,我觉得科影三点零是所有这些里面听起来最棒的。 不过如果你有不同看法,一定要告诉我,我还在摸索阶段,我试了不少提示词,但还不足以得出最终结论。咱们接着测,顺便也和 sora 两比一比。接下来就精彩了,因为我在跑这些测试的时候,我有个奇怪的感觉,就是 sora 二在多镜头处理上其实也挺牛的。 sora 二唯一的短板是,你没法真的丢一张人像进去,让它动起来,或者用它生成视频,因为它在这方面就是有限制, 而柯影则打破了这层壁垒,所以现在用柯影就能实现这个功能了,而且它生成的视频最长能达到十五秒。那咱们就实际来看看效果吧。要想公平的比较柯影和 sora, 唯一的方法就是跑文本生成视频,因为这样才能绕过所有限制条件, 所以我就从情感测试的角度来看看它的真实感到底有多犟。打头阵的是柯影三 zero, 我差点就信了,这要是段真视频我绝对信,以为真效果太顶了,好到让我都有点难过了。再来看看 sorry 二的表现, i don't know how to stop feeling like this。 背景音乐有点拉胯,但配音、演员、角色声音,还有那些细微之处,听起来都超级真实。不过现在如果你看看我们给的提示词,就会发现,我们压根没要求它生成任何对话, 所以这些对话全是它自己发挥的,这就是它们最真实的情感流露。看来 sora 二是这么个感觉,现在咱们来和 vivo 三点一比一比,顺便也听听音效。 说实话效果不赖,但他眼角那滴泪真是让我有点猛,怎么说没就没了呢?他这是在倒着哭啊,这操作是怎么实现的? 没错,要我说这选择其实很简单,就拿这次测试来说,基本就是 sora 和科影二选一,但我感觉科影这边选择更多,因为他的玩法更丰富,你可以上传自己的图片,这在 sora 二里对人类可不行, 咱们再试一个,现在咱们还在测纹身视频,不然就没法和 sora 二作对比了,所以我现在主要对比这些模型的动态效果, 我用的提示词是这样的,让这些模特为镜头摆姿势,我想看看他们对提示词的理解和执行力怎么样。动作是慢慢将头转向左侧,再转向右侧,然后微微抬起下巴。基本上就这些动作要求就是动作要轻柔舒缓,看看他们表现如何。先看科影三 zero 看起来挺自然的,现在轮到 sora 二, sora 二似乎不太清楚该怎么摆弄下巴,不过他多少还是跟着指令做了。现在来看看 v o 三一的表现。 要我说,你确实可以认为他遵循了提示词,这跟我预想的不太一样,但他确实是先往左走,然后向右转了个身,最后抬起了下巴。平心而论,虽然我不想显得偏心,但我觉得在这里柯映的表现最佳。而且我也给了这个模型公平的测试机会。我进行了多次生成, 并从中挑选了效果最好的一个,免得你们好奇我是怎么选的。接下来这个镜头动作更丰富一些,同时我也想对生成过程有更强的把控,因此我想重点考察一下它遵循提示词的效果到底怎么样。 我这里设定了一个起始针和一个结束针,画面里是两个劫匪正在撬银行的门,结果进去发现里面有一群人,然后还有个保安,他本来在睡觉,然后惊醒过来。 我去,什么情况?那咱们就直接开看吧。这里我特别想对比一下所有的 ai 模型,因为 sorry 二不让我生成这段视频。我遇到点问题,可能因为画面里出现了枪。至于 ai, 我 目前还是所有模型都在用,像 ai 二点一和 ai 二点六这些版本我都还在用,来我们看看。 先看 ai 二 one, 这个没声音,它没按我提示的那样把门踢开, 而且这家伙已经坐在那了,所以这个算是翻车了。那我们接着探 can 二 six, 同样门也没踢开,不过这家伙在睡觉,但他身体在 moaning 行变,接着他醒了,然后抓起枪。 还行,但行变还是太多了点。现在来看科影一,我是说这一脚踢得没劲儿,对,这个镜头全是行变,这根本没法用。最后是科影三 zero, 这个镜头不错,像这样踹门才是我想要的,而且我喜欢摄影师从这两人中间穿过去的运镜。这家伙在睡觉, 我们的注意力会集中在其他人身上,然后焦点会慢慢从他们的眼睛移向这边,就好像在问,右边这哥们在干嘛呢?太离谱了,真是绝了。好了,我还有一个最终镜头, 想拿来跟 y o 三点一和 sora 两比一比。可惜的是这对比不太公平,因为镜头里有人,而我没办法在 sora 二里用带人物的镜头来实现它,所以我尝试用文本提示 prompt 来生成它。不过从可引三点零开始,我们就能做出这个镜头了。我们从这个镜头开始,然后我往里加了四个不同的镜头。 首先是一个定场镜头,一个从屋顶拍摄的白色调定场镜头,接着切到一个侧面的中近景,他的头轻轻转了一下,然后一个硬切,直接给到他脸部的特写。最后再一个硬切,以从背后拍摄的白色镜头收尾。现在咱们来看看他到底有没有按提示词来。 哇,这太牛了, ai 能真的听懂你的提示并照做,这才是我喜欢的这个操作。我也用 y o 三点一试过,毕竟视频里包含多个镜头也不是什么新鲜事了,这效果比不上你亲自操作那个多镜头功能的时候。接下来我们来看看 y o 三一, 我们从一个白色的定场镜头开始, 这里他跳过了那个镜头,感觉就像是镜头切换时,他的头应该跟着动一下,接着应该切到一个特写镜头, 然后是一个从背后拍摄的镜头,但这个镜头系列不是。总的来说,我对刻印三点零的整体感受是,那就是这对于 ai 电影制作人、广告商、营销人员来说,将会是一个巨大的利器。

130云桥网络 01:27查看AI文稿AI文稿

01:27查看AI文稿AI文稿师傅,我想当导演,想拍戏先过我这一关, 时代变了,可零三点零来了,现在用一张图就能生成一整段戏,也就是说人人都能当导演了。 没错,他好这条太棒了!哎,我刚刚是不是下手重了点?刚刚那一下整的老狠了,那这次真的是人人都能当导演了。 这就是可林最新推出的三点零视频模型,现在可以一次性输出长达十五秒,包含多个镜头,而且印画完全同步的 ai 视频。它的智能分镜可以让你只用一张图片,直接生成多个角度的分镜画面,而这个自定义分镜可以更加精确的控制每个镜头的构图和运镜。 相比 vivo 三呢,它的电影感更强,而且印画同步的效果也有了明显的升级,支持画面中多个人同时说话, 还能覆盖多语种甚至不同方言。除此之外呢,可灵的多模态模型 over, 你 也来到了三点零版本,你可以通过几张图片创建你的演员角色, 再利用它的多主体融合能力,做出多角色、多物体同时互动的复杂视频场景。这波升级直接把 ai 视频的可玩性和完成度拉高了一大截。如果你也在做 ai 视频,这个版本非常值得尝试。

154小林Kara 08:21查看AI文稿AI文稿

08:21查看AI文稿AI文稿从零基础彻底教会你可零 ai! 注意,本系列视频耗时一个月,将带你一口气彻底学会可零 ai 视频制作,带你从零基础小白入门进阶!由于视频太长,本套教程分期发布,本期带你搞定免费灵感值获取方法。这套课程全程利用 ai 工具辅助, 从剧本创作、角色形象设计、分镜头图片生成,到 ai 视频生成、配音配乐、剪辑成片,每一部都给你标准化流程, 没有废话,全是实操,跟着练就能出片,真正做到零基础也能快速赚钱。更重磅的是,教程里独家整理的 ai 慢举提示词、关键词库、免费 ai 工具清单,全都毫无保留!分享、置顶评论直接领取,不用私信,不用等,现在点进去 就能暴走,咱们直接开启课程,手把手带你做出第一条赚钱的 ai 动态慢哈喽,各位伙伴们,相信很多想要入门 ai 视频的宝子会希望能够尽可能节省成本,那么这期视频咱们就来看一看如何能够在可令 ai 上免费获取灵感值, 以及如何让视频生成的速度更快。咱们打开可灵 ai 来看看第一个获取灵感值的方法。咱们看到界面的左下角,这里有一个个人头像的按钮,咱们点击一下就会来到个人主页, 可以看到中间这里有一个灵感任务,咱们点击进入就可以看到咱们完成这里的任务都可以获得灵感值。其中一个是发布素材,像咱们创作的优质图片,还有视频素材都可以发布到创意圈, 如果有其他用户通过前面所说的一键做同款的方式获取了灵感,咱们就能够获得灵感值的奖励,热度越高奖励越丰厚。 那么另外一个就是制作 ai 短片,咱们用 ai 所制作的短片被评为可灵精选选项的话,每次就能获得三千灵感值。然后是按次数入选可灵精选,可以额外获得大量的灵感值, 可以看到只要有五个入选的话,就可以额外获得一万点的灵感值。不过这里要注意一点的是,咱们获取的灵感值有效期是三十一天,大家在获取好之后,最好能够快速的把这些灵感值给消耗掉。第二个能够获取灵感值的方法, 咱们可以看到左边的这一个消息中心的按钮,咱们点击一下就会弹出来一些官方的消息,那么在这些消息中,有一些是让我们填写调查问卷的,咱们将消息信息往下拉,可以看到这里有一个填写问卷 即可获得一百灵感值奖励。通常来说,像这样的调查问卷几乎每个月都会发放一次,只要填写问卷一般就能获得灵感值, 所以在这个位置咱们同样也是可以获得灵感值的。再来看看第三个获取灵感值的方法,看到左上角的这个创意圈,点击之后,咱们再来到上节课所讲到的活动专区, 里面目前是有非常多可灵 ai 上举办的有关 ai 创作的活动,这些活动可以获取的灵感值非常的丰厚。在每个活动的下方,这里有一个火焰的标识,这个标识通常代表着当前活动的关注人数, 也就是活动的热度,一般来说关注的人越多,奖励是越丰厚的,但竞争也会同样的更加激烈一些,比如说咱们往下翻, 看到下方有一个已经颁奖的活动,这里标注大奖的奖金是一点五万美金,所以它的活动关注度是非常高的。那么咱们随便找一个上面的进入, 通常可以在活动界面直接的点击立即投稿去上传咱们的作品。那么咱们在下面还可以看到活动的投稿的详细信息, 他的一些赛道规则以及参赛的注意事项。同时咱们还可以看到下方的活动奖励,这里可以看到一等奖有三千八百八十八元的现金奖励,加上一万二的灵感值,以及蛋仔的玩偶, 这个奖金还是非常丰厚的。而且一等奖有两个名额,二等奖有八个名额。咱们继续将页面往下拉,在下方这里还可以看到其他参赛者的一些作品, 可以看到目前的参赛作品并不多,而且我们刚刚所查看到的获奖名额有二十个,所以像这样的活动咱们去投票的话,能够获奖的概率还是比较高的。 大家在创作的初期还没有充分的经验的情况下,想要去获奖的话,可以多参加一些这样的小活动。咱们在参赛的过程中还是要去看清楚他的一些活动规则, 比如说有些活动会要求作品的点赞数,或者是发布的内容会有一定的限制,咱们要查看好活动规则之后再参加比赛。这里如果大家希望自己上传的 ai 作品能够获得更多的热度,也可以查看评论区置顶评论, 考虑加入我们的 ai 讨论话题社区,咱们大家相互点赞,相互学习。回到我们的活动专区页, 需要注意的是活动目前的状态,比如说刚刚我们点击进去的这个蛋仔的活动,显示的是他的结稿时间,还有下方的一些活动,目前已经是在评奖中,或者是代颁奖以及 颁奖的状态,这就意味着已经无法投稿了,这个时候我们最多可以去鉴赏一下其他作者上传的作品, 或者帮他们去投个票。而向上方的这两个活动目前还是可以参加的,大家都可以踊跃的报名。那么接下来我们再来讲一讲获取灵感值的规则。 咱们来到会员界面,点击中间这个灵感值旁边的查看明细,再看到最下方的这个灵感值规则。在这个地方咱们可以看到通过不同方式所获取的灵感值,他们的有效期是不同的。 这里需要注意,通过常规会员所获取的灵感值,它的有效期是自发喜日的一个月,如果我是黄金会员,那么每个月是能够获得六百六十个点的灵感值, 当月如果没有用完的话,下一个月也会重置会清零。所以大家一定要注意按照自己生成视频或者图片的需求来选择合适的会员套餐,不然没用完灵感值的话就会白白的浪费。那么本期视频到最后再来讲一讲视频生成速度的问题。 大家在使用过可灵 ai 后会发现咱们生成一张图片的速度是非常快的,但是生成视频往往会要花费更多的时间。 举个例子,通常咱们生成一秒钟的视频需要的帧率是二十五帧,也就需要生成大概五张图片,那么生成一段五秒钟的视频,共计要生成一百二十五张图片, 最后还要将大批量的图片整合成一个完整的视频,所以花费的时间会要长很多,同时可令的优势就在于视频生成,所以可令上视频生成的用户数量也是非常多的,人 越多排队所花费的时间也就越长。所以大家想要提高视频生成的效率,可以考虑错峰使用。 一般工作日的下午使用的人数是比较多的,而清晨还有周末使用的人数较少,升成的速度也会更加的快一些。那么以上就是本期视频的全部内容了,如果觉得内容对你有帮助的话,可以点一个一键三连哦,咱们下节课见!

18呀米AI漫剧 01:07查看AI文稿AI文稿

01:07查看AI文稿AI文稿好莱坞完蛋了!为什么一众海外 ai 大 神在深夜集体发出这样的惊呼?就在昨天,国产模型可零三点零的发布,又一次把 ai 视频的天花板给掀翻了,甚至有人仅用两天时间就能搓出王者之路这种级别的史诗开场。 以前我们玩 ai 最痛的就是不可控,但这次可零三点零的智能分镜功能,这才是真正的降维打击。你只需要上传两张图片,选自定义分镜,输入每个画面你想要的内容, 设置好时长,一段流畅的双人打斗戏就完成了。只需定义起始帧和结束帧,他就能读懂你的意图,把那些破碎的画面缝合的天衣无缝。以前我们做视频是拼凑碎片,现在能直接生成一段十五秒的完整故事,而且是原声四 k 的 超清直出。 这哪里是模型更新,这是把好莱坞的工业流水线压缩到了你的浏览器里。当别人还在纠结提示词的时候,先知先觉的人已经开始用它拍电影了。别让你的想象力死在旧时代的工具上。

274黄一鸣AI 01:03查看AI文稿AI文稿

01:03查看AI文稿AI文稿后悔了, 既然想要绝对的力量,就不该保留你那点可怜的人性 恐惧,软弱记忆,这些粘稠的垃圾正在阻碍神力的流动。我来帮你把阻碍彻底清除。掌柜。 哈哈哈哈哈现在顺畅多了。冰主要是已经铸成了。让我们开始吧,击碎那九道枷锁去。

43VR城 00:34查看AI文稿AI文稿

00:34查看AI文稿AI文稿你是说普通人也可以拍电影了?以前不敢想的事情,如今已变成现实。可连 ai 上线三点零系列模型,直接把 ai 视频从小学生作文卷到好莱坞分镜级别,实拍级画面质感,每一帧都像真人实拍,再也没有那种假假的 ai 感。按图片分镜顺序依次输入画面,再输入修饰指令,剧情 走向由你掌控,直接圆你导演梦。关键还有生化同出多种语言,中文要是他当妈妈了呢?英文 i do, 韩语甚至方言也能生成。如果他是暴脾气呢?旅游转场轻松拿捏,韩剧氛围更是手拿把掐, ai 都能给你拍的明明白白。现在打开可怜 ai 三点零,把你的脑洞变成电影,拍出你的专属大片吧!

3691你很会演鸭 12:4534零重力瓦力

12:4534零重力瓦力![可灵3.0|初体验|多镜头提示词 嗨,就在刚刚。kling3.0可以在fal平台使用了。

主要更新为:

1. 提示词支持多个片段的划分,支持时间选择。例如时长15秒内,准确表达多少秒到多少秒是什么内容。

2. 分为标准版本每秒$0.252和pro版本$0.336

3. 一致性,支持引入人物或者产品。通过4张图片和上传3到10秒内的视频。

4.

#可灵 [话题]# #可灵3 [话题]# #AI人工智能 [话题]# #AI生成 [话题]#](https://p3-pc-sign.douyinpic.com/image-cut-tos-priv/e0d69e542052a401e1bdb226f8250446~tplv-dy-resize-origshort-autoq-75:330.jpeg?lk3s=138a59ce&x-expires=2086351200&x-signature=S7ddheHtAxvF7ph%2FdrHshzmQdc4%3D&from=327834062&s=PackSourceEnum_AWEME_DETAIL&se=false&sc=cover&biz_tag=pcweb_cover&l=20260213224550894ED9D5DCB244DBDEB2) 03:52查看AI文稿AI文稿

03:52查看AI文稿AI文稿嗨,大家好,呃,可怜三点零已经发布了,然后,呃,是刚刚发布了,我也是刚在副平台用了一下,然后我就还是拿之前一个一直没有解决的一个视频,就是这个 颈部按摩仪的 conrad these straps, so you don't actually have to hold it it just stays in place, oh shit。 然后三点零的话,他的更新就是把之前的二点六和欧万的融到一块,然后我们可以看到他这个 配置界面是稍微有点复杂的,但是其实还可以,就是你可以传入,呃,首先还是常规的提示词,然后但是这里是有一个亮点,就是他有一个 money prompt, 就是 有个 为了让你有多个镜头吗?因为他这一次的单次生成的视频长度提高了十五秒,所以他他可以让你分段的输入提示词,所以可以,并且你可以控制每一段提示词是展示多少秒,可以看到这里最短是三秒,最长是十五秒, 而且你还可以加,你可以看到,但是我这里为了快速测试就没加,还是然后这里的话,呃,这这次测试我是拿之前这个 conduit straps, so you don't actually have to hold it。 那 么我们还是把这个视频的第一帧截图给他,然后让他生成音频,那么下面这里就是他也支持首尾帧,但是这里我们就不传尾帧了。 然后接下来第二个重点,就是之前 o one 那 个模型,就是哎里面的对象的一个概念,然后我们这次是传了产品的前景的照片,以及你可以传最多,我看一下 你可以传最多三张其他角度的照片,然后我们这只就只传这个颈部按摩仪背面的照片,但是他还有一个就是你,你甚至可以传你这个产品,呃,你的产品我看一下,对 最长三十秒的,你的产品的一个视频给他也也可以,但是我觉得这个可能会效果更好,但是这里我们就不做啊。 然后当然了,这个 element 不 不仅是产品,也可以是人,你可以点击这里继续加,你可以看到最多传四个照片, 那么我们看一下效果,其实我还挺惊艳,但是有点遗憾,就是我这个提示词里面没有让这个产品展示这种按摩的效果,有点遗憾,其实我觉得最难的是这个,但是我们可以先看一下这个视频,一致性已经非常好了。 really good, comes with these straps, so you don't actually to hold it, it just stays in place wow, that's really good, it comes with these straps, so you don't actually to hold it it just stays in place this is a。 产品一致性非常好,但是我的,我,我的那个啥,我那个积分已经用完了,然后这次,然后因为这个还不是正式的,我测评这个模型的视频,我会在明天发一个完整的,因为这个费用直接把我那个剩余的积分给干完了, 然后费用的话就在这里我给大家,我给大家看一下,我马上要去睡觉了,我让 g p t 总结一下, 呃,我直接就说吧,就是,呃,有音频的情况下呢,每秒的价格是零点二五二美元一秒,好吧,就这么简单,没有音频的我觉得不用看了,肯定要有音频。 对,然后我明天会呃,再把我之前几个客户其中一个是卖那个麦克风的,这个当时一次性也是做的很差,包括这个 这个颈部按摩仪的也是很差,我都会打算用这个模型重新测一遍,并且做一个很正式的一个视频分享给出来,谢谢大家。

02:08

02:08 00:28查看AI文稿AI文稿

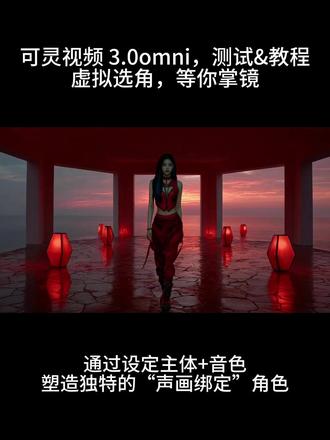

00:28查看AI文稿AI文稿通过设定主体加音色,塑造独特的升华绑定角色,先上传两张以上角色的图片和音色,并保存为主体,然后在视频三点零阿木尼 选择多个主体加参考图,描述主体之间如何互动,什么时候说台词,以及镜头如何走位切换即可一键生成保持主体一致性,最长十五秒的樱花同步的视频。

猜你喜欢

- 7691小川爱剪辑

最新视频

- 104弎