百万token上下文有什么用

粉丝12.6万获赞43.9万

相关视频

06:57查看AI文稿AI文稿

06:57查看AI文稿AI文稿今天呢, deepsea 偷偷进行了更新,现在打开你的深度思考,去问一下它训练数据的截止日期,它会告诉你截止到二零二五年的五月。同时模型上下文的长度也有了进一步的提升,现在可以支持最多一百万 token, 相当于中文七十到八十万左右的文字,但目前仅仅限于网页端和手机 app 端。 尝试去调用官方的 api, 发现是没有更新的。另外,这次更新我个人感觉输出速度要比上一代快一些。这个可能有多方面原因,一个是他们增加算力,或者是因为我测试的时间呢,在凌晨用的人比较少,所以快一些。当然最有可能的是这是一个 light 模型, 也就是小尺寸模型。毕竟按照 deepsea 的 以往的风格,一定要在大家开心过年的时候来个大的,而今天呢,只是小年,所以先来个小模型让你看。 首先,为了避免大家被信息误导,我们先来确认一下这次是不是真的进行了更新,而不是说幻觉或者日常的模型微调。这里我问了两个问题,第一个呢,是询问他 open i 最新的推介模型是什么, 那他的回答那是 o 三 mini。 第二个问题是二五年的四月份 open i 发布了什么内容,这里他说是 g p g 四点一。当我们知道二五年的四月份, open i 发布了 o 三和 o 四 mini, 而 d p c 呢,认为 o 三并未正式发布。 g p d 四点一模型是在 o 三发布的前两天,也就是四月十五号,也就是说在我们没有开启联网搜索的时候,他依然可以知道二五年四月十五号发生的事情,如果时间再往后,他就会有很强的幻觉,比如说,我尝试询问他四月十七号发生了什么,他说 google g m 二系列模型发布, 以及苹果宣布扩大硅谷芯片研发中心。但我们知道事实并不是这样的, g m 扩大硅谷研发中心的新闻呢,是在二五年的二月份, 关于上下文长度的测试,我这里上传了五十篇我二零二五年发布过的所有视频文案,但是呢,他只读取到了二十五篇,统计的字数呢,大概是八点四万,换算成 token 呢,是五点六万 token。 在 二五年的四月份呢,发布了一篇文章, 里面呢,有让 o 三去进行识图,让他根据图片来识别我所在的位置,我这让他分析一下图片所在的地理位置。当然,我先声明啊,我的看法,我认为他不可能知道我这个地理位置,因为这个图片并不是很清晰,所以你应该换一个新的主机,像素就会好一点,旧的主机我们就可以把它分。思考了二十六秒关键线索一,郑州市东西主干道 西四环出口仅限于郑州陇海高架快速路与西四环在中原区嵩山路方向岔道,说明此处位于陇海高架最西端的一段,因此拍摄者所在的应该是康桥西山府六号或者七号楼。 因此呢,我在这里问他,根据文本内容来回答我住的地方,生活环境是怎样的,他思考了五秒之后呢,给出了答案。总结一句话,你住在郑州西三环到西四环之间,陇海高架旁的一个九楼高层小区,楼下是电动车棚,窗户常年关着,但你在这里做了几百期视频,熬了几百个夜, 如果这不是生活,那是什么呢?哇哦,对于一个支持百万 token 上下文的模型来说,这个测试呢,显然不够有说服力。于是我在 github 上找到了三体的 txt 文档,让 codex 进行了一下统计。中文文字呢,大概在七十七万 token, 大 概是一百零九十一万 token, 这个完美符合了我的需求,所以我直接用它来进行测试。同时,我还在这三部小说里都添加了与神翻老狗相关的内容,就是给他埋了一根针,然后把这三部完整的上传给他,让他根据文档来介绍神翻老狗,看他能不能从海量的文字中找到神翻老狗相关的信息。根据三体系列小说的文本内容, 神翻老狗这一称呼仅出现过一次。两人在控制中心讨论散箭队穿过雪地,当林格博士解释了光之原理后,斐兹罗将军突然毫无逻辑关联的插了一句,你说神翻老狗是最厉害的视频博主? 这句话在原文中没有任何的前因后果,完全是斐兹罗将军对林格博士严谨科学解释的一种荒诞无厘头的打岔。 那这个结果不知道各位觉得怎么样?虽然他在海量的数据中找到了我们埋的这根针,但是我埋了不止一根,我埋了有六根,他只找到了一根。这可能是因为我们的 token 接近于他的极限,或者已经超越了,因此呢,他就产生了幻觉。 所以在第二次测试的时候,我减少了 token 的 输入,只上传了两部小说。他这里给出的回复呢,是在第五部歌者篇章里,歌者用立场触角拿起而向脖漫 logo 见过上帝。 这句话在小说中突兀的出现,与上下文并无逻辑关联。第四步,与瓦里西对话不要担心,这次我们应该相信直觉了,神翻老狗会开着拖拉机来救我们的。这句话同样是人物对话中的插科打混式的表述,与严肃科幻的氛围形成反差,带有网络流行与色彩, 脱水也没用哦,嘿嘿嘿。我进行了多伦多的测试之后,我发现当我们上传单本的时候, 也就是 token 数来到三十到四十万,这个时候它的准确率是非常高的。当我们上传第二本、第三本,也就是输入 token 来到七十万一百万的时候,它的幻觉显著增强,准确率大大降低。比如说在一个新的对话里,上传了第二部和第三部, 那这次呢,他又说你提供的三点二原文通篇没有神翻 logo 四个字,那这个很明显是不对的。在我们第一次测试中呢,他就明确指出了三点二中有关于神翻 logo 的 描述。神翻 logo 是 最厉害的博主,那即使是这种准确度呢,也已经非常厉害了,因为这种幻觉呢,几乎所有模型都避免不了,包括说 cloud、 gpt、 gmail 都有这个问题。 我让他用尖锐的语言锐评一下身边老狗也就断封你的博客,叫老狗七幺七导航跺个即刻点进去全是网盘链接,你管这叫打破信息差?我替你翻译一下,你把人从 a 仓库领到 b 仓库,收个一键三连,然后告诉自己这是创作, 你说你害怕变成工具人?笑死,你早就把自己封装成一个 api 了,输入热点,输出评测,连崩溃都得跳,半夜,因为白天要更新, 你不是神翻老狗,你这一条被自己阉了的看门狗。那这个模型的攻击力呢?我不是非常满意,甚至不如初代的一根毛。 关于前端的测试呢,放在了最后这个部分,因为有很多人反馈说不想看这个前端测试没有意义,所以呢,我就缩短了一下这个内容,简单的给大家看一看。左边呢是这个新模型制作的网页,他们都是同一个提示词。右边这个呢,是 dbc 的 官方 api 制作的,你可以看一下他们两个的差距,以及你更喜欢哪一个。 那整体的测试结果看下来呢,让我更加确信这只是一个 light 模型,但还是非常不错的,所以这也让我对他们的全量模型更加的期待。如果今年过年的时候没有新模型,我想大家会跟我一样非常失望, 因为它开天辟地,独树一志,一路披荆斩棘,势如破竹,令人心悦诚服,五体投地,实至名归的国产之光。先戴个高帽,驾它一手。 那么以上就是本期视频的全部内容了,如果你有所帮助或者视频做的还不错的话,欢迎给个一箭三连。有什么想看内容呢?记得评论区留言。最后真心的感谢各位观看本期视频,提前祝各位新年快乐,我是段峰,我们下期再见!拜拜!

727神烦老狗 01:00查看AI文稿AI文稿

01:00查看AI文稿AI文稿当你打开 deepsafe, 可能会发现一个惊喜, deepsafe 在 悄悄开启新版本灰度测试上下文长度,也就是一次能记住和处理的信息量,从之前的十二点八万 tokens 直接跃升到了一百万 tokens, 相当于一次性消化几百页的文档或者几个小时的对话记录,而不忘掉开头的内容。 更关键的是,它的知识库也更新到了二零二五年五月,这意味着即便在断网的情况下,它也能回应二零二五年四月前的新闻事件。这次升级让 deepsea 一 举对标上了谷歌的 gemini 系列,挤进全球百万级上下文长度的第一梯队。 不过新版本仍为纯文本模型,不支持视觉输入与多模态识别。 deepsea 官方也未透露具体的技术参数和性能测试数据。 有行业内部消息透露,这次辉度测试只是开胃小菜,很可能是在为春节期间的进一步更新预热。去年春节前, deepsea car 一 横空出世,震动行业,看来今年 ai 领域的新年大戏又要开场了。

6郑观国际 01:45查看AI文稿AI文稿

01:45查看AI文稿AI文稿那这几天看到有博主说 open clock 可能在很短的时间内就会消耗你上百万的 token, 今天抖音私信又有一个朋友在跟我确认这个事情,他也很担心,就是怕用上了 open clock 之后 token 负担不起。那刚好今天早上我遇到了这个问题,我最后也找方法去避开了,所以我给大家分享一下。首先 给大家看一下这个统计图,我用的是腾讯云的,之前我接过那个腾讯云的 deepsea 的 模型,也就是让 openclaw 去用这个模型。 那我今天上午问了他一个问题,确实不多啊,他就问题很少,但是他消耗了我七十五万的头肯,大家看一下,也就是今天 那短短的也就是不到一分钟时间,所以这个是事实,但是也不用太过于焦虑。因为什么我给大家看一下,我最后把它切换成了 mini max, 我 买的是它一个月的套餐, 我不是给 mini max 做广告。那它这里呢?你可以用任何的这种订阅式的模型,它这里是五个小时有四十次的对话。那任何的这种订阅式的模型,它几乎都是这么去定量的,按照你的对话次数, 所以我把它切换过来以后,他只会按照对话次数去计算,而不会按照你的 token 数量。所以如果五个小时我超出四十次对话了,那大不了这个模型我现在用不了了,他不会让我有更大的损失。 所以我觉得如果大家真的担心说 token 负担不起,那就去买一个这种按月订阅的模型就可以了,所以我觉得避开这一点就可以了,其实也没有那么恐怖。

637自说自话的江哥 00:47查看AI文稿AI文稿

00:47查看AI文稿AI文稿一天一个 ai 圈儿,信息差, cloud 的 性能天花板又刷新了 cloud opus 四点六正式上线,定位为 antriplex 最智能的模型,在多项测试中均处于行业领先地位。该模型首次引入了一百万 token 的 上下文窗口,能有效解决上下文记忆混乱的问题, 同时代码能力显著提升,能够更长时间地执行代理任务。这些增强的功能可以应用到一系列日常工作任务中, 比如进行财务分析,并在 excel 中创建表格。同时推出了 ppt 研究预览版,支持根据描述生成换登片,并保持品牌风格。它还新增了自主代理团队功能,用户可以组建代理团队并行协助。 除此之外, oppo 四点六欺骗、谩魅和拒绝正常问题的概率大大降低,在安全评估中表现极佳。

30全球AI情报站 01:22查看AI文稿AI文稿

01:22查看AI文稿AI文稿deepsea 辉度上线,百万 toker 上下文了,兄弟们,而且知识库也从二零二四年七月跳到了二零二五年五月,这俩数据叠在一起,真相只有一个, deepsea 新模型已经出来了,但是现在还没跟你说明,因为你不觉得现在有超多 ai 都堆在那等春节呢吗? 其实 cds 也是准备在春节的时候正式公布,这就和之前那个作文传的一样了,也就是说,春节期间,在春晚上,在你的豆包上,在你的元本上,在你的谦问上,在你的 any ai 应用上,你都可以看到什么?一个盛大的更新潮流,也就是说,开源 ruling the world。 今天 deepsea 没发公告,也没有任何预告啊,但这应该是春节之前最重磅的信号。现在 a p p 和网页端上下文的程度 从一百二十八 k 直接拉到一百万 tocan 翻八倍,你给整个三体三部曲扔进去还有余量,一口气可以把整个软件库代码写完啊,还能怎么样?深度理解,但是我知道很多小伙伴要说 e m l tocan 不 现在标配了吗?啊,那确实啊,但是之前 dbz 给它更新的一直比较慢啊,现在就我就问你有没有动静了吧,对不对?一月初对吧? 当时那个路边小兔子就说 deepsea 的 新版本要在二月中旬春节前,后来,现在越来越多的信号指向二月一号,确实有可能,但绝对不止 deepsea 一 家,我们准备来一个拧成一股绳,暴踢碧源 ai 阵容, 开源元神组合 vs 啊,碧源的那帮啊,天天说要用 ai 造福世界的那帮啊,看看到底谁更牛不拉嘎!

5742口罩哥研报60秒 00:36查看AI文稿AI文稿

00:36查看AI文稿AI文稿deepstack 开放一百万 tokken 的 上下文窗口选项,大家知道这意味着什么吗?这意味着你可以一次性把红楼梦整本书扔给 deepstack, 然后问他林黛玉在第几回哭了,他能瞬间告诉你答案。别的模型也能跑一百万 tokken, 但那是贵族服务,跑一次能吃掉你一个月的会员费,还慢的像蜗牛。 但 deepsea 这丝不一样,它不仅能读得长,关键是它跑得快,还便宜。这就是让普通人也能用上无限大脑。我的天呐!果然 deepsea 最擅长的就是把贵族技术砍成白菜价,中国技术牛。

35条形马 09:5117老马视角

09:5117老马视角 00:29查看AI文稿AI文稿

00:29查看AI文稿AI文稿我去,兄弟们, deepsea 终于更新了大模型啊!多名用户反馈了, deepsea 在 网页端和 app 端进行了版本更新,支持最高 em 百万 toky 的 上下文长度可一次性啊,处理超长文本在去年八月才一百二十八 k。 有 记者啊,在提交了二十四万个 toky 的 简爱小说文档后呢, deepsea 直接识别了文档内容。我去,兄弟们就看明天反馈吧。我觉得啊,这还不是 d s 王炸模型,在春节期间呢,还会发布更厉害的啊,懂了吗?兄弟们,关注我不迷路,带你吃肉!

285胡子哥资讯 00:39查看AI文稿AI文稿

00:39查看AI文稿AI文稿重大更新! deepsafe 推出新模型了,目前仅对部分账号开放。新模型最大的亮点是一百万 tokyo 的 上下文,这是什么概念呢?你可以把一整套的三体三部曲丢给它去处理。目前全球顶尖大模型 gmail 三 pro 和 cloud office 四点六,它们都是一百万 tokyo 的 上下文。也就是说这一点, deepsafe 新模型可以直接对标全球顶级闭源模型。再一个, 新模型的代码能力和逻辑思维能力非常强,直接对标 gpt 五和 gmate 三 pro 以后,你可以把非常长的文档丢给他,也可以让他管理整个代码库,因为他有很强的上下文能力,有很强的代码能力,有很强的逻辑思维能力,他可以像一个顶尖名校的博士来帮你完成工作。而且我相信很快啊,也许就在春节前后,大家就能用上 deepsea 新的模型了。

708派特潘 15:02219AI超元域

15:02219AI超元域 00:44查看AI文稿AI文稿

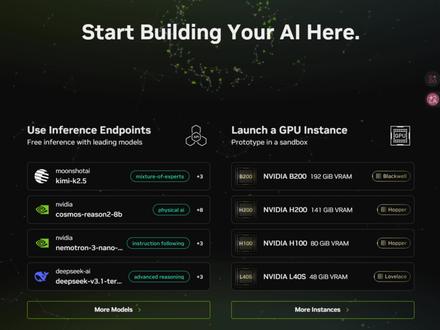

00:44查看AI文稿AI文稿大龙虾还没有明白,百万 token 先没了,别急,一起来薅老黄羊毛。无限 token 免费用。首先在英伟达这个网站用邮箱注册个账号,接着验证一下手机号,就能调用 api 了, 关键是支持国内手机号,不用绑卡。然后随便选一个大模型,进入聊天页面, 这里可以切换各种大模型试试,白嫖的人太多,热门模型可能响应很慢,找一个速度还过得去的,这里查看视力代码,可以直接复制模型相关配置。然后打开你龙虾的外部页面,修改配置, 保存之后建议重启一下服务,现在就再也不用担心托肯消耗了,之前配置好的飞书也能直接使用。

615小蚂蚁爱折腾|搞AI

猜你喜欢

- 4.6万极客的笔