如何在云服务器配置openclaw

阿里云 openclaw 一 键部署攻略,快速拥有专属 ai 助手。第一步,前往阿里云 openclaw 部署页面,找到并点击一键购买并部署。 第二步,购买阿里云轻量应用服务器镜像,选择应用镜像中的 open curl multibot 镜像内存推荐二 g b 及以上地域默认美国弗吉尼亚,时常根据自己的需求及预算选择选择完成,按照页面引导完成支付操作。 第三步,前往阿里云百炼大模型控制台,找到密钥管理,单机创建 a p i t。 第四步,前往清亮应用服务器控制台,找到安装好 openclaw 的 实力,进入应用详情放行一八七八九,端口配置摆练 api key, 执行命令生成访问 openclaw 的 token。 以上就是阿里云 openclaw 一 键部署攻略,完成以上步骤,即可快速拥有专属 ai 助手,解锁更高效的工作与生活方式。

粉丝1115获赞4633

相关视频

02:27查看AI文稿AI文稿

02:27查看AI文稿AI文稿大龙虾这波热度呢,让所有云厂商都卷了起来,基本上都出了自己的云端部署方案,今天我就用阿里云带你跑一遍,十分钟拎包入住云端版的贾维斯 open club。 说实话,本地装不是不行,但你得折腾环境配依赖,还得自己对接模型 a p p。 对 普通人来说呢,直接劝退 好。首先,我们打开阿里云的清凉应用服务器页面,在镜像这里呢,直接选择 multi boot, 他 已经把运行环境打包好了,你不用自己装任何东西。 配置的话,镜像要求最低是两盒两 gb。 地域呢,随便选,国内国外都行,国内因为有网络 bgp 优化会贵的,这里我选择国际型。确认好我们的地域, 这里我选择新加坡,因为我不是新用户啊,新户价格首次还会更便宜,最低九块九,一个月六十八块钱呢,就能直接包一年, 或者像我这样直接想尝尝鲜啊,先购买一个月,确认这些都没问题之后,点击立即付款。付款后呢,等服务器启动,服务器起来之后,进控制台,你就可以看到我们买的服务器了。点击进入我们的服务器详情页,你可以看到这里面一共需要三步,我们挨个执行就可以。第一步啊,放通端口,页面上有个一键放通,点一下就可以。 这要是你自己部署啊,这一步我估计会卡住很多人。第二步,配置我们的 api key, 还有生成 token, 这里需要跳转到阿里云百联平台,在密钥管理里创建一个 openclaw 专用的 key, 复制过来粘贴执行。 第三步,获取专属链接,点执行命令,它就会给你分配一个专属的链接,记住这个链接啊,后面点进去就能直接进入 opencloud 控制台了。到这一步啊,整个部署呢,就算完成了。看到了吗?就这么简单,一共三步,除了等服务器创建的那几分钟啊,实际动手操作呢,用不了五分钟, 完全不用碰触任何的命令。行,你就可以拥有一个自己专属的大龙虾,而且只花了一顿饭钱,这比你去买 mac mini 简直省太多了,也不用担心关机断电这些问题。那怎么验证跑起来了?你可以直接在控制台里跟他对话, 也可以像我这样呢,接入钉钉,做一个钉钉的机器人,直接在手机上艾特他,因为模型默认是帮你接入了千问三 max 的 最新版本,推理更强,都是对话呢,你的 ai 助理呢,依然会在后台帮你联网查找资料, 整理信息。那怎么能玩一些更复杂的自动化任务呢?网上其实已经有不少博主做了详细的教程,阿里云官方呢,也写了教程文档,想要的呢,我可以发给你,感兴趣的可以自己去研究。 成本上还要说一下,模型调用呢,是单独计费的,轻度玩玩呢,基本是可以忽略的。但如果你想做一些复杂的任务呢,还是建议去百炼平台购买这种扣丁 plan, 也就是固定月费可用的 token 额度呢,会更多,也更划算。所以以后这种拎包入住的云端化,才是未来 ai 普及的正确姿势,你们觉得呢?快去试试吧!

7820赛脖古 01:13查看AI文稿AI文稿

01:13查看AI文稿AI文稿腾讯云 openclaw 秒级部署教程,一键搭建专属 ai 助理!第一步,前往腾讯云 openclaw 专题页面,找到并点击立即部署我的 ai 助理。 第二步,购买腾讯云轻量应用服务器应用模板选择 open claw cloud bot 地狱,根据使用场景选择规格,选择两核二 g 及以上配置,点击页面右下角立即购买,按照页面引导完成支付即可。 如果在此之前已经购买腾讯云轻量应用服务器,并且希望在该服务器中部署 opencloud, 且该服务器中的旧数据无需保留,则可以使用重装系统的方式进行安装。 第三步,配置 opencloud, 选择已经部署的服务器,进入管理实力页面,选择应用管理,腾讯云提供了可适化界面,方便进行配置,接下来即可在界面上进行模型配置以及 opencloud 的 channel 配置。 完成以上步骤,一个私人 ai 助理就创建完成了,回答问题、搜索信息、执行任务,聪明响应,二十四小时为你工作。

18福利大杂烩 01:45查看AI文稿AI文稿

01:45查看AI文稿AI文稿openclaw windows 系统详细安装部署教程来了! openclaw, 一个能让 ai 大 模型像人一样操作你电脑的智能助手,今天就带你花两分钟在 windows 系统本地部署小龙虾。操作步骤很简单, 首先前往官网安装 node js, 这里我们直接下载稳定版本即可。下载完成后,打开文件夹,点击进行安装,安装的选项全部默认。 安装完成后,使用管理员模式运行终端,使用指令查询 node 点 js 的 版本号。 接下来开始安装相关指令,可前往评论区领取,可以看到安装已完成。接下来进行具体配置,输入指令后,这里默认为不同意,我们改成同意 yes, 这里选快速安装 quickstart。 由于我之前配置过一遍,所以这里选择更新 模型。以 glm 为例, apikey 可以 前往官网获取接入的聊天软件,我们先跳过安装 skills, 选 yes, 选择 npm 安装软件包预设 skills 我 们也跳过,这里是第三方应用的 apikey, 相关设置都选 no, 给出的三个 hooks 最好都勾选上。由于之前配置过官网服务,这里我选择重装 reinstall, 等待它安装完成。 抽象 bot, 选择 open the web ui 配置完成后,我们就进入 open cloud 界面进行简单的尝试。比如我们让它在 c 盘创建一个文件模型,回复我们文件已创建,那我们进入 c 盘检验下, 可以看到确实已经创建,说明我们本次的安装部署成功了。关注我,解锁更多开源软件操作小技巧!

2174小白跃升坊 02:37查看AI文稿AI文稿

02:37查看AI文稿AI文稿接下来我将教大家如何在云服务器部署 motobot, 以 smooth cloud 云平台为例,选择所需要的配置。镜像配置,选择 motobot, 打开创建 s s h, 点击进入时域,进入到时域列表,点击快捷工具,打开 jupiter, 点击 terminal, 打开终端,输入安装命令,按下回车安装, 这里选择 e s, 这里选择快速安装,然后使用现有配置,这里我们选择千问的模型, 点击进入这个网站, 登录你的账号,然后点击确认,返回刚才页面,选择当前模型, 这里是配置通讯软件的,先跳过 这些是配置的一些技能还用不上, 这里也选择跳过, 这里选择打开 web e y, 现在就已经安装完成了。返回刚才的实体列表,点击查看详情。 新增一个端口,协议为 h t t ps 协议,端口号为一七八九,点击确认复制,打开这个新端口的网 址,选择高级,点击继续访问。现在我们就已经进入到 motbot 界面了,返回刚才终端界面,复制一下这个 token, 回到 motobot 界面,点击 over view, 把刚刚复制到的 token 粘贴进去,然后点击 connect, 返回刚才终端界面。这里还要修改一下配置文件, 把这个 false 改成处, 保存好,然后回到 motobot 页面,刷新, 现在就可以正常访问了,给他发送信息,他现在就会自动回复你了。

60懂王强哥🫅 01:01查看AI文稿AI文稿

01:01查看AI文稿AI文稿阿里云 openclaw 快 速部署攻略,一键拥有私人 ai 助理。第一步,进入阿里云 openclaw 专题页面,找到并点击一键购买并部署。 第二步,购买阿里云轻量应用服务器镜像选择 openclaw motbot, 镜像内存必须两 gb 及以上,地域默认美国弗吉尼亚,时常根据自己的需求及预算选择。 第三步,前往阿里云百炼大模型控制台,找到密钥管理,单机创建 a p i t。 第四步,前往轻量应用服务器控制台,找到安装好 opencloud 的 实体,进入应用详情,放行一八七八九端口配置百炼 a p i t 执行命令,生成访问 opencloud 的 token。 完成以上步骤,一个私人 ai 助手就构建完成了,回答问题,搜索信息,执行任务。聪明响应二十四小时为你工作。

33福利大杂烩 03:01查看AI文稿AI文稿

03:01查看AI文稿AI文稿之前我制作了一期关于 openclaw 云端部署的教程,没想到大家还蛮喜欢的,也收获了很多的点赞和评论,在这里非常感谢大家。那么很多人问我就是如何把 openclaw 部署在本地,我今天呢就出一期简单的教程,来教大家如何一键把 openclaw 部署在本地。 本期的教程是用 macos 系统进行演示的,如果你是 windows 用户的话,可以去搜索一下网上的其他的部署教程,那我在这里做一个风险提示啊,就是本地部署的话,最好不要部署在自己的工作电脑以及有重要的隐私机密的电脑。 我们最好是部署在一个全新的或者是没有任何资料的一个 mac 系统,或者去购买一个 mac mini 进行一个部署。那么废话不多说,我们开始进行部署的教程吧。如果你的电脑没有安装 nojs 环境的话,你需要进行一下 nojs 环境的安装。首先我们来到 nojs 的 官网,我们点击下载, 你可以通过命令行进行安装,或者是直接下载一个安装程序就可以了。首先我们打开终端,然后粘贴这一行代码,点击回车,这个时候呢他就是在帮我们拉取那个 open cloud 的 安装文件, 看到这样的一行界面呢,说明我们的安装已经成功了。接下来呢我们就开始进行 open cloud 的 配置,我们输入这行代码,然后点击回车, 这边呢就是一些安全的提醒,你可以选择 yes, 然后我们进入快速配置的模式,点击 quick start, 这里呢是输入模型的一个 api, 我 们这里选的 monshift ai, 当然你可以选其他模型或者暂时跳过,我这边输的是 monshift ai 的 一个 api 模型,然后这边把 api key 粘贴进来,点击回车,然后点击这个 keep current, 然后这里呢是选择 channel, 就是 你可以去进行对话的,但是我这边呢暂时就不进行一个配置,我们点击这个 skip, 这里是进行 skip 的 配置。简单来说呢,这里就是你可以给 ai 加上一些技能,比方说一些捕取网页啊,下载一些内容啊,生成图片的功能,我们点击 yes, 然后我们把这些全部都勾选上就可以了, 然后我们点击回车进行一个安装,这边呢设置这个 api 器的话,你可以后续再设置,我这里先跳过,所以呢全部选 no, 这边是选择一个 hook, 然后呢我们把这几个都勾选上就可以了。 接下来就是到了一个 gateway, 就是 网关的安装的一个阶段,到这一步呢,基本上你的安装就已经完成了。我们可以点击 open the web ui, 然后打开个网页,之后呢就会打开一个这样的网页,这个是 open cloud 的 一个控制面板。这边 chat 这个部分呢,就是可以跟 ai 进行对话了,我们来测试一下我们的 ai 是 否安装成功。 siri, 你 好, 那么我们可以看到我们已经可以成功的收到 ai 的 回复了,这代表着你的部署已经完全成功了。

609HalfAI 04:08查看AI文稿AI文稿

04:08查看AI文稿AI文稿这可能是二零二六开年超火的 ai 工具,连续三次改名, github 上超过十万新,号称电脑里的贾维斯。 openclaw 是 一款开源自托管的个人 ai 助手,不光能聊天,还能真正接管本地设备,打通聊天平台、浏览器和各类应用,实现跨平台自动化操作。 今天这条视频教大家如何快速部署 openclo, 并把它集成到飞书里,打造一个随叫随到的 ai 员工,小白也能学会。建议先收藏。详细的文字版教程已经整理好了,视频结尾可以自取。一、 打开清亮应用服务器,并安装 openclo 镜像,进入这个界面,点击应用镜像,选择 mode 时长,这里可以根据自己的需求选择。目前有活动六十八,能用一年。点击这里, 然后点击这里,进入管理后台。二、配置 openclaw 接下来我们配置 openclaw, 打开阿里云百链,点击左侧导航栏的密钥管理单机创建 apikey, 然后回到云服务器界面,点击实力 id, 进入服务器概览页面,点击应用详情,开始配置 openclaw, 先点击这里的一键放通, 然后点击执行命令,复制粘贴阿里云百炼深层的 a p i t, 点击下一步。接下来点击执行命令就可以获取 openclaw 对 话的地址,先打开这个地址,等下还会用到。 点击执行命令,可以查看 token 配置,然后切换到 open kala 的 对话界面,点击左侧导航栏的 config, 点击该退,切换至 h t t p 页签,在 responses 区域将 enable 切换至开启,如果已经开启就不用再设置了。到这一步,我们已经可以正常和 open kala 对 话了, 接下来我们还可以进一步把 open kla 集成到飞书。三、创建并配置飞书应用进入飞书开发者后台,点击创建企业自建应用,填写应用信息后单机创建。在左侧导航栏中选择添加应用能力,选择按能力添加,找到机器人卡片,点击添加。 在左侧导航栏中点击权限管理,点击开通权限,搜索并添加屏幕上的这五个 api, 权限完成后进行下一步。点击左侧导航栏的凭证与基础信息, 查看并复制 app id 和 app secret, 点击左侧导航栏的事件与回调,点击加密策略 重置,生成一个新 encrypt key, 之后再复制 encrypt key 和 verification token 到粘贴版。四、创建飞书连接流打开阿里云 app 福洛模板中心的飞书 openklo 模板,点击立即使用添加一个新的飞书凭证, 填写凭证名称,剩下的四栏分别填入前面复制下来的信息,之后在下拉框中选中创建好的凭证。接下来创建 open kla 凭证 token, 这里填入前面获取的 open klo 凭证,填写完成后点击确定,并在下拉框中选中创建好的凭证。点击下一步。这里我们需要前往服务器详情页获取服务器公网地址, 并按页面提示填入公网 ip 端口号默认为一八七八,点击下一步,直到完成配置。配置完成后点击发布,复制并保存 weboker。 五、配置飞书机器人 返回飞书开发者后台事件与回调界面,点击事件配置,然后配置订阅方式,选择将事件发送至开发者服务器,填写上一步复制的 webhooker, 点击保存 已添加事件区域,点击添加事件搜索并添加接收消息。事件填写完成后,点击左侧的版本管理与发布,点击创建版本,填写相关信息后保存并提交审批。我们就把 open club 在 飞书里配置完成了。接下来返回飞书,在群机器人中找到 open club 并添加, 然后艾特机器人发送消息就可以实现对话,也可以让 open club 在 飞书里帮我们执行更多任务。 到这里,一个接入飞书二十四小时在线,还能帮你自动处理繁琐工作的 ai 员工就部署完成了。详细的文字版教程我已经整理好了,有需要的朋友直接在评论区扣 open club 就 能领取。以上就是本期全部内容,我们下期见。

120摸鱼的AI笔记 05:37查看AI文稿AI文稿

05:37查看AI文稿AI文稿嗨,大家好,今天给大家分享下基于 openclo 搭建本地 ai 员工的部署教程,不用花一分钱托肯, 这次我们基于汪派能用为面板来搭建搭建完全本地化的 ai 员工助理,核心是部署欧拉曼本地服务以及 gpt 模型,再搭配 openclo 作为交互入口, 数据全程保存在自己的服务器,既省钱又安全,不管是日常办公还是个人使用都超方便。话不多说,咱们直接上实操。整个实操过程分为六步, 第一,准备 gpu 服务器。第二,运维面板万帕诺安装。第三, gpu 资源配置。第四,奥尔玛模型平台安装。第五,完成 gpt 模型加载。第六, open club 个人员工构建。 我们先来完成第一步,基于腾讯云申请一台带 gpu 的 云服务器,这里选择创建一个竞价实力进行操作演示。首先我们保证服务器为 gpu 架构,为本地模型提供算力。其次,磁盘记得设置为一百 g, 方便大模型下载到本地 并开通公网 ip, 方便后续访问。最后记得提前开通应用的默认访问端口,欧乐玛应用端口、 one panel 应用端口、 openquad 应用端口。服务器创建好以后,我们直接登录腾讯云服务器,默认会享 gpu 相关驱动。安装好首次登录需要耐心等待下,登录后,首先我们通过 sudio 命令切换到 root 用户下, 然后到 one panel 在 线文档中获取一键安装命令,直接复制执行即可。进入安装过程时,先检测完成 dawk 的 安装,需要确认安装目录并下载安装 dawk, 安装完成后,开始设置镜像加速器和面板访问参数,其中输入 yes, 完成镜像加速器配置, 面板端口号输入我们已开通的端口号,最后获取面板账号及面板密码即可。登录 one panel, 登录后我们确认下 gpu 卡的驱动情况,紧接着配置好面板访问地址,方便应用直接跳转访问。配置完成后,我们进入终端开始 gpu 资源配置,首先再次输入命令行,确认英伟达显卡驱动,然后逐个输入命令,完成英伟达容器镜像安装 配置 dolphin 镜像使用英伟达的 gpu 资源配置完成后重启 dolphin 镜像,这样我们就完成了 gpu 资源使用的配置。 到这里我们基本准备好了我们的资源,接下来我们开始欧拉玛的安装,我们进入应用商店,选择 ai 就 可以快速看到欧拉玛应用,点击安装输入相关参数即可。 这里我们需要确认好版本,零点一五点四当前最新版本端口号一一四三四开启端口外部访问,最后一定记得勾选开启 gpu 支持,其他保持默认,点击确认开始安装。这里安装包含镜像拉取以及应用安装两部分,大概需要一分钟左右, 这里我们快记下。安装完成后我们到已安装应用中确认欧拉玛已经正常运行, 点击链接地址页面显示欧莱玛 is running 即可。到这里我们就完成了欧莱美开源模型管理平台安装。下面我们急于欧莱玛完成开源模型 g p t 杠 o s 二零 b 模型的加载, 大家跟上节奏,在 one panel 中找到 ai 管理,进入模型管理,点击创建模型,在模型配置页面点击快速跳转进入欧莱玛官网, 输入 gpt 杠 o s 快 速搜索到模型,点击获取模型 id。 然后我们再回到 one pan 面板,输入获取到模型 id, 点击确认开始模型下载,该模型下载大概需要十到二十分钟,这里我们快速跳过模型,加载完成后,我们就为我们的个人 ai 员工准备好大脑了,我们通过模型先验证下能否正常对话,太棒了,可以对话哦, 这样我们就为 ai 员工准备好了大脑。下面我们同样基于 one panel 来安装我们最近特别火爆的 openclaw, 进入应用商店找到 openclaw 应用,点击安装完成参数配置确认,默认端口号已经开通,下拉选择欧拉曼模型供应商并输入相关参数,具体参见如图所示。其中 gptos 二零 b 对 应我们下载的本地模型 a p i t 输入任意字母 base u r i o 对 应我们部署的欧拉姆地址。最后同样记得开通端口外部访问, 其他参数保持默认,点击确认即开始安装。安装大概一分钟左右,我们同样快速跳过,安装完成后通过安装目录获取 opencloud 访问 token, 获取后与 ip 端口 token 等于 token 值,拼接后输入 web 访问地址中, 最后点击跳转,直接选择带 token 的 访问地址就可以体验啦。让 ai 助手帮忙创建一个文件清单,到服务器对应目录查看,完成操作啦。 接着我们让他网上查询一些信息,他也可以轻松帮我们搞定。到这里我们就完整构建了一个本地的 ai 员工啦,大家速来体验呀!完全可以用 one panel 作为 ai 员工的管理员,本地,重点是本地!本地就等于安全! 同时再也不用为 token 着急上火啦!小伙伴们快来快速构建,抓紧体验啦!

3569OpenClaw开源社区 07:10查看AI文稿AI文稿

07:10查看AI文稿AI文稿大家好,你现在看到的是我在飞书里和一个 ai 机器人对话,看起来很普通对吧?但这个机器人背后的大模型不是 chad gpt, 不是 cod, 也不是任何云端 api, 它是智普最新开源的 glm 四点七 flash, 一个三百亿参数的模型。此刻正跑在我自己的电脑上,用的是一张四零七零 super 显卡,而且我这台电脑和飞书之间 隔着一台只有三核 cpu, 四点五 g 内存的小服务器,没有昂贵的云端 api 费用,没有数据隐私担忧,完全本地化部署。整个架构是这样的, 我的本地电脑运行欧莱玛和 glm 四点七 plus 模型,通过 f r p 内网穿透,让云服务器能访问我本地的模型。 服务器上运行 openclaw, 作为 ai 助手的大脑,飞书通过 web socket 长连接和 openclaw 通信。 接下来我会手把手带大家完成这整个部署过程。如果你也有一张十六 g 显存的显卡,想零成本打造自己的私有 ai 助手,这个视频一定要看到。最后, 话不多说,现在开始部署。首先下载一个适合跑模型的驱动,接着在欧拉玛官方网站上下载欧拉玛,注意选威严系统版本,不要错选,下载完成后双击运行,点击安装, 安装完成可以在终端运行 olegma version 查看 olegma 版本,运行 olegma pro 加模型名称可以下载对应的模型。最后运行 olegma run 加模型名称就可以在本地运行模型了。这里提问一下, 看到输出说明欧莱玛本地运行模型成功,下面我们开启内网穿透,这样服务器就可以调用我们本地的欧莱玛模型了。首先进入服务器 下面,在服务器创建一个 f r p 的 文件夹,然后进入这个文件夹目录下,下载 f i p 解压 f r p 压缩包,进入刚刚解压的文件目录下,创建配置文件 f r p s。 点 to mail 下面启动服务端,然后我们可以用这条命令来验证服务端是否开启。 接下来需要开放防火墙,如果大家可以打开这个页面,代表着服务器的内网穿透已经成功开启服务器的端口,让其与服务器的端口进行连接。 和服务器一样,首先创建 f r p 文件夹,进入该文件夹目录下,运行这条命令,下载客户端 f r p 的 压缩包, 对压缩包进行解压,下面同样进入该文件目录下。接下来创建配置文件。配置完成后,接下来启动客户端, 可以看到 star proxy success, 这说明我们的内网穿透已经完成了。当然我们还可以在服务器当中刻录一下这个幺幺四三四端口, 可以看到欧拉玛是有回应的。如果大家想更方便地操作服务器或者看到里面的内容,这里建议给服务器安装一下 one panel, 这里选择中文简体,因为我已经安装过了,所以这里省略了一些步骤,没安装过的朋友可以根据提示进行下一步,最终会得到面板的地址、账号以及密码。然后根据这些信息进行登录,就可以打开服务器的 one panel 了。 大家看这里就可以看到我们刚刚创建的 f r p 服务的相关文件。下面说一下如何在服务器向部署 openclaw。 首先将项目源码克隆到服务器上,接下来在服务器中运行这两条命令去安装 node js。 二十二, 接下来运行这四条命令,安装 pmpm 和 openclaw。 最后运行第五条的命令,进入 openclaw 配置向导, 运行 open cola 配置向导,这里选 yes, 选 quit start 因为我们要使用的是本地电脑的欧拉玛模型,所以这里我们先进行跳过,这里进行全选。 选第二个 intermodel menu, 这里我们删除模型,选择填入我们的欧拉玛 glm。 四点七 flash 模型选择跳过 选 yes, 这里选择 no, 选第二个,这里按空格选择跳过这部分可以都先选择 no, 这里选择跳过这里我们就选择 restart。 按回车这里选择 do this later, 然后去手动配置 olemma 模型,选择 yes。 完成 openclaw 的 配置后, 接下来需要编辑这个 json 文件,确保服务器的 openclaw 可以 正常调用本地的 olemma 模型。这里说三点编辑 json 文件需要注意的地方,第一点是 openclaw 要求的最小上下文是一万六千 tokens, 第二点是配置的模型 id 要与 olemma 实际模型完全一致。第三点是 getaway bind, 这里需要修改为滥。配置好后就可以在服务器上下载飞书插件并开始配置机器人了, 大家可以在飞书开放平台申请并配置机器人。下面需要在权限管理这里开通以下显示的权限,点击开通权限即可添加。 接着需要在事件与回调这里进行添加事件配置订阅方式选择长链接,然后添加机器人进群以及接收消息这两个事件。 注意看这里的两个应用凭证,下面会使用到 机器人配置完成后,在版本管理与发布这里进行发布,这里是清晰的飞书开放平台的配置步骤。在开放平台配置完机器人后,我们运行命令,安装飞书插件, 紧接着运行下面四条命令,在服务器中配置飞书。刚刚提醒注意的两个应用凭证,现在需要分别填在这两个命令中,然后重启 open class, 打开飞书, 添加下你配置的机器人后,便可以和它进行对话了。如果完成到了这一步,那么恭喜你拥有了一个完全属于自己的 ai 助手,可以在飞书里随时调用。而且最棒的是,它没有昂贵的云端 api 费用,没有数据隐私担忧,完全本地化部署。

07:32查看AI文稿AI文稿

07:32查看AI文稿AI文稿感谢大家对上一个视频的支持,也看到了有朋友说画面太小了,看不清,确实这个批评的对,所以今天就特别编辑了敢能转过来的版本,这样把手机转一下都横屏就能变成全屏了,大家看看是不是好的。 来了来了,腾讯官方支持的 opencloud 的 微信接入教程来了,废话不多说,现在就开整! openclaw 是 什么我就不多说了,昨天的视频有介绍,因为昨天有不少小伙伴们说 vitchy 的 接入方法有会被额加禁用甚至封号的风险, 那我们今天就来说说这个刚出的官方支持的方法,这可是官方文档提供的方法哦。那今天呢,咱们就几种火力搞定他跟企业微信的对接 好了,咱们来看看今天的作战徒步。首先呢,我们得先认识一下这位新来的 ai 员工, 然后呢,给他做好入职准备。接着呢,在企业微信里给他安排个工位,再把他和我们的四福气连上网。最后也是最关键的,让他学会怎么七天二十四小时昂然待命。当然了,万一中途遇到点小麻烦,我也准备了解决方案。 好,那咱们就从第一步开始,俗话说的好,磨刀不误砍柴工嘛,咱们先把所有需要的东西都准备好,这样后面的操作才能行云流水。 我们需要准备的东西其实就两样,第一,一个有管理人权限的企业微信账号。哎,别担心,如果你只是想自己玩一玩,测试一下,完全可以去免费注册一个新的企业号。第二呢,就是一台云服务器,而且上面已经装好了最新版的 open call, 哎,这里大家可得注意了,这有一个非常关键的区别,如果你的企业微信账号是没有认证过的, 那测试的时候直接用服务器的公网 ip 地址就行。但是如果你的账号是已经认证过的企业,那就必须一定得用一个背过案的域名,这是企业微信为了安全和规范定下的规矩,咱们得遵守。 行,准备工作做完了,咱们就正式开干。现在我们要做的就是在企业微信的后台亲手创建一个连接的桥梁,也就是我们的机器人 来跟着我一步一步来。先登录企业微信后台,找到那个叫安全与管理的菜单,点进去之后呢,再找到管理工具,然后点击创建机器人,在弹出来的页面最下面,记住,我们要选的是 api 模式。创建 好了,到这个页面了,先给你的机器人起个好听的名字,然后看到右边那个随机获取的按钮吗?点它,系统就会给你生成两串非常重要的东西,一个叫 token, 一个叫 encoding aesk, 你 可以把他俩想象成一把专属的配对密钥,只有你的服务器和企业微信才有,这样就能保证他们俩之间的悄悄话不会被别人偷听了。 好,我们又回到了这个关键的选择点,你看这张图就说的非常清楚了,左边未认证的账号直接用 ip 地址,简单方便,适合咱们自己测试玩。右边已认证的企业账号,那就得用备案域名, 这是为了生产环境的稳定和安全,这一点千万别搞混了,他直接决定了你下一步能不能成功, 这就是那个 ur 摇的具体格式,记住把你的 ip 或域名这几个字换成你自己。还有啊,特别重要的一点,后面的冒号、短捆号,一八七八九,还有那个斜杠、路径杠、 v 炕,一个都不能少哦! 注意注意注意,这里是新手最容易掉进去的坑,你在企业微信这边把所有信息都填好之后,千万千万千万不要手快去点那个创建按钮,我们得先去福气那边把刚刚生成的秘药告诉他,让他有个准备 好了,现在轮到私服器这边的操作了,这就像是一次数字世界的握手,我们得把刚才在企业微信那边拿到的信物,也就是那两个密钥亲手交给我们的 openclo 私服器。 这一步操作啊,超级简单,登录你服务器的 openclo 管理后台,找到应用管理, 然后在 channel 也就是渠道配置里选择企业微信。接着把刚才我们复制的那两个宝贝 token 和 encode a s t 粘贴到对应的框里,点一下应用,当你看到保存成功的提示时,就说明服务器已经认识这位新朋友了。 好的,服务器那边已经准备就绪了,现在我们可以满怀信心的回到企业微信的那个页面,然后狠狠的把那个创建按钮给按下去。 连接成功了,但这只是第一步,我们总不能每次都开着服务器的控制台窗口吧,那多麻烦。所以接下来咱们要学一个专业技巧,让我们的 ai 助手能够七天二十四小时全天候在线。 好了,现在打开你的命令行端端,我们要开始敲代码了。看到这一长串命六,你先别怕,我给你解释一下它的作用,很简单,就是告诉服务器系统,嘿,就算我这个用户下线了,也请让我的程序在后台继续跑着, 你把它整个复制粘贴进去,回车你会发现他什么反应都没有,这就对了,说明他已经敲掐的生效了。 接下来是第二条命令,这条命令是把我们的 opencloud 安装成一个系统服务。这么作的好处是什么呢?就是以后万一服务器重启了,这个服务也会跟着自动启动,就不用我们每次都手动去开了,非常省心。第三步,万事俱备,只劝东风。 输入这条命令,就相当于按下了启动按钮,从现在开始,你的 ai 助手就已经在后台正式上岗,开始为你工作了。 当然了,为了保险起见,我们最后再检查一下他的工作状态,输入这条命令。如果你看到了屏幕上这个绿油油的让人安心的 active running 字呀,那就说明一切完美,恭喜你,大功告成。 当然了,在配置过程中,谁都可能遇到点小磕小胖,不过别担心,我已经帮大家准备好了一张安全网,把最常见的问题和解决方法都列了出来。 所以大家记住这个关键点,如果你看到服务没有正确响应,这种报错别慌,百分之九十的可能性就两个,要么就是你的 ur 格式写错了,比如端口号忘了加, 要么就是顺序高反了没有先去私服器保存密钥,就手快点了创建,只要你跟着我们刚才的步骤,一步一步来,这些小问题都能轻松解决 好了。到现在,一个完全属于你自己的七天二十四小时在线,而且数据绝对安全的 ai 数字员工就已经正式上线了。那么问题来了,你准备交给他的第一个任务会是什么呢?快去想一想吧!

79学习AI每一天 07:42查看AI文稿AI文稿

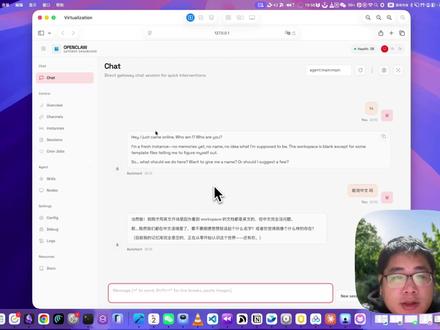

07:42查看AI文稿AI文稿今天教大家怎么把这 opencode 装在这个虚拟机上,为什么要这么安装呢?第一呢, mac 虚拟机不会花你一分钱,你不用花钱去买什么云服务器的,你在 windows 上也可以装 mac 虚拟机,你在 mac 上也可以装 mac 虚拟机,很安全。 第二呢, opencode 的 真正潜力要发挥的话,必须要安装在一个 mac 系统上,所以本期教程呢,就是一个保姆级的虚拟机安装教程,在 mac 系统下 windows 的 话也很简单。第二呢,就是教你如何安装 note gs, 这是后面用一系列 ai 工具的标配,比如说 cloud code, 各种 ai 工具都需要用到 node js。 第三的话就是来配置新版的这个 open code, 就是 以之前的 cloud board 要安装一个虚拟机啊,然后这里有条命令,按回车,它就开始安装了, 然后这不允许,当然允许也行,但是有有一定风险,还是不允许吧。然后这个时候呢,我们就要开始干什么呢? 我们要检测一下它这个能不能安装成功了啊?已经安装成功了,就这么简单。然后接下来呢,就要安装虚拟机了, 假如你网络比较好的情况下,安装这个就行了,就是后面的是它的镜像文件了,但你的网络不好的话,一般都是不行的。不行怎么解决呢? 不行怎么解决呢?你就把它这个东西安装下载到本地,然后按照这条命令来开始安装它,我现在按回车,然后我就让它来安装,现在我告诉大家怎么去找这些固件。 好,这里有一个专门下载这固件的网站,然后这里你就选吧,选设备啊,我的是 mac, 你 也根据你的设备来选,然后我的是 emix 嘛,我就选 这里。有个问题是你一定要选跟你系统版本一样的啊,这是最靠谱的,就是我试过选比自己系统版本低的是不行的,然后点这个, 然后点这个下载,下载也会很慢,这个时候怎么办呢?你就得用那些百度云的云下载啊,来下载了,这样子你就能把它下载到本地了。就是你用一个专业的云下载工具把它下载下来,或者你等这个下载 好,我们回到这看它安装 看一下啊,我们现在的这个这个虚拟机是在关闭状态,然后我们要启动 这里就很麻烦了,一一系列东西, 这里选中国大陆设置为新机, 然后点继续,以后继 续点击取消啊,这个因为我们不不想登录这个 apple id, 然后这个账户和密码你必定要记住,因为等一下要用 这个就稍后设置啊, 点击跳过, 点击同意, 点击继续吧,要点击继续,稍后设置 siri 也关了,都不需要, 以后继续继续手动下载更新 开始使用,我点这里获取 node js, 然后你看到这里有一堆命令,对不对?然后复制这个, 然后按这个回车, 它就会告诉你,你有个东西没安装,然后把这个复制粘这个按, 然后这里它就会启动一个这个东西,然后你点安装就行了,你还要同意一下, 我这里显示这个软件已经安装完成了,我们点击完成 它,这里呢就会去去安装了。 好,现在已经安装完成了,然后复制这个这里面这行命令,然后再粘进来,这样回车, 然后接下来复制这个命令,这样回车。这两步的命令呢,就是想让这个东西生效, 然后现在利用这个工具来装这个 node js, 你 看它这里就下载了, 然后通过这个命令来检查一下版本装对了没 啊?都已经安装好了,安装 node js 环境特别重要,以后你想用 curl code 的 话也要这么安装。 然后第二步就是登录了,嗯,现在就输入这个命令,启动这个配置流程吧。你这选 yes, 快 速开始 选择 kimi ko, 然后这里粘进来,我选这个模型,然后这跳过钻石给我。 no, 这个跳过, 这里点允许这里找 web ui 打开 啊,就回我了,现在的话就已经在一个虚拟机配置完成了,至于后面怎么连接飞书呢?怎么去这个 multi book 呢?呃,我后面会继续出教程了,对不对?然后今天先这样吧。

73铁锤人教AI 06:54查看AI文稿AI文稿

06:54查看AI文稿AI文稿哈喽,下班了,今天我们来聊聊 openclaw, 我 觉得有必要啊,因为太热了这个话题,我想给它降降温, 为什么呢?因为这是一个在 getop 上引起广泛关注的一个项目,而且目前各家云厂商都上线了相关的云服务器,支持大家去部署这个产品。那么这个产品怎么定位哈?它其实是一个 个人助手,或者叫一个通用型的 ai agent, 它可以接入,比如说一些计时通讯工具,你可以通过这种计时通讯工具给它发消息,然后它呢帮你调度一个云端的电脑,或者是你本地的电脑,它可以完成一系列的任务。 那么我一开始看到这个产品的感觉,就觉得它跟 coldbody 这种产品非常非常的像,为什么呢?因为它们都是通用 agent, 就是它可以通过调用电脑里的各种工具, ai coding 的 工具,或者是电脑里的一些网页浏览的工具,通过 m、 c, p 等等,它可以去完成很多的任务。 当然因为授权范围的不同,它肯定是比 cloud code 或者 code body 编程类的工具,它能做的事情更多,而且它的主动性更强。 举个例子哈,你可以在你的一些即时通讯工具上直接说,你帮我发一个什么样的文档给谁谁谁,他可以直接执行。那你帮我把这次会议机要转成一个非常清晰的文件,帮他变成一个网站,他也可以非常快速的完成。 甚至是你可以跟他说,你调用这个电脑的录屏功能,帮我做一个什么样的 ppt, 它也可以完成。所以就是当你给 ai 配了一个电脑的时候,而且这个电脑它拥有所有的权限,它跟你的权限是一样的,跟人的权限是一样的时候,那它可以解锁很多的能力。 当然这里面有两个核心的概念,或者说核心的机制,让它跟 ai coding 的 产品有本质区别。第一个叫 gateway, 就是 相当于一个调度中台,它可以在这个调度中台上 接收信息,接收完以后分配任务给到不同的电脑中的工具,然后哎完成最后交付。那它是一个调度中台,那这个调度中台就可以实现一个 实时在线,就是二十四小时一直在线,它可以保持着这种这么一种激活的状态。那这也是为什么你说它可以持续不断的收到你的消息,就是因为它是持续在线这么一种状态。第二个非常关键的机制呢,叫做 heartbeat, 叫心跳机制,类似于给了 ai 心跳,让它可以跳动起来了。它什么意思?它每隔一段时间它会去扫描一下这个系统里有没有新的需求进来,比如说你的邮箱 有没有收到新的信息,比如说你之前有没有设过闹钟提醒,比如说每天八点去帮我扫一下整个今天的 ai 行业的资讯,或者是每隔一段时间我要去看一看有没有新的任务给到我。通过各种即时通讯工具,我就可以开始激活 ai 干活。 所以你从这里可以看到他有一个非常主动的一个机制,他会主动去扫描,他会实时待命,主动扫描,所以这个就跟像 coldbody 里你跟他去做交互, 拿到一个任务,完成一项工作就有很大区别,他就是处于一种实时待命的状态,而且会主动接到信息就开始干活,所以这个就是一个本质上的区别哈。 但是我觉得这个东西我为什么前两天没讲呢?就是因为我觉得它跟这种通用型的 agent ai coding 的 工具没有本质上的区别。假设说像 cloud code, 像 code body, 它们如果也想做一个类似的功能的话,实际上是完全可以做到的,只要给 ai 更多的授权就可以实现。 或者说你只要再弄几个移动端的交互的方式,你也可以在移动端指挥你的本地电脑完成这样的工作,其实没有一点难度。那为什么 大家都没做,为什么就只有这个 open cloud 在 做这件事?我觉得是大家对安全和效率中间怎么平衡的一个考虑, 就是你到底给 ai 多大的授权?我们知道它的上限其实是非常高,可以完成很多任务,而且很多任务上是超过我们自己的能力的。那这种情况下安全的问题怎么考虑?比如说现在如果是 这个东西被劫持,因为他有权限很高,那如果一个一个一个不法分子告诉你的电脑,说把这个人的电脑的内容全都删了,或者说把这个人的电脑中关于什么什么的内容发给某某邮箱,那他就可以实现了, 它就可以实现对你电脑的一个操控,对你个人数据和隐私的一个操控。所以其实这种安全问题是非常重要的一个问题。之前大家说中国人可能不在意自己的隐私,愿意拿隐私换便利,那接下来 ai 时代 那生产力是非常高的,这个上限是非常非常高的,那你愿意把你的安全拿出来多少去交换这种生产力的上限?我觉得这是一个摆在我们每一个人的面前的问题。因为 ai 的 能力现在 不是技术来去束缚的,而是你的这个治理的原则束缚的。你到底要给他多大的授权?你相信他到什么样的程度?你愿意给他几千块钱,让他帮你买东西,对吧?这样的一些问题,我觉得可能都是我们接下来要考虑的一些关键的问题。 我之前觉得像 coldbody 这种产品已经非常够用了,在我们的日常工作中哈,当然我也不满足,因为我前两天还在说怎么给 ai 更大的自主性,让它自己去跑这个 a 阵的能力。但是对于这种 openclaw 这种形态, 我自己心里目前还没有完全接受,当然我可以接受一个新的电脑去做一些尝试,但是因为他现在还有很多问题,比如说 token 消耗非常大的问题,比如说这种安全不可控的问题,所以我觉得目前不是一个非常理想的形态。当然最后 可能再往前走一下,很多产品也会去考虑这些问题,会给用户更多的选择,然后给用户。我觉得现在用户已经很很很少有能力去控制自己的这个数据的安全了。但是我们在这个 ai 时代到底要在 ai 面前变得这么透明吗? 也许有一天你会发现你让渡的这个权力本身可能比效率更重要。对,最近我在考虑这个 ai 时代的权力,到底我们要给 ai 多大的权力? 如果他的能力已经非常非常的高了,如果他的加入到人类社会中,真的已经能够给人类带来非常非常多的注意的时候, 我们愿意给他主体性,我们愿意给他授权吗?我们愿意给他权力吗?我觉得这些都是一些要考虑的问题,跟大家分享这么多哈,我觉得这也是一些非常非常前沿的命题,有机会再跟大家探讨,拜拜。

3562晓辉博士 09:24查看AI文稿AI文稿

09:24查看AI文稿AI文稿你想不想拥有你自己的 ai 小 牛马,并且通过域名去访问它?哈喽啊兄弟们,没错,还是我。今天我将手把手教你部署 open club, 并且实现通过域名访问。 相信我真的十分简单,只需要一步一步跟着我去操作。那么废话不多说,现在开始。首先你需要一台云服务器和一个域名,还有一个可用的 a p k。 云服务器的选择尤为重要。 这里我推荐使用优誉云的香港服务器,这也是今天演示使用的服务器。我们先来看一下服务器延迟,把测试 ip 粘贴到 itdog, 可以 看到全国全绿,平均延迟四十一毫秒。 注意尽量选择香港五区的机型,因为这个区按照主播的教程,百分之百可以部署成功。主播今天使用香港五区 b 型进行演示,我已经替你们试过了,一合一既带不动,这个已经是最经济实惠的方案了。咱们直接点击购买 系统,选择乌班图二四即可。然后来到用户中心,找到你的机器,单机来到控制面板,在上方复制你的机器 ip, 然后来到 finno 首,接下来跟着主播操作, 机器的名称随便填写,主播这里就写香港币了。主机,这里粘贴刚才复制的机器 ip。 然后咱们再回到优域云,复制一下机器的密码,粘贴到密码一栏, 用户名填 root, 然后点击确定。 如果你还没有安装 fanout, 那 么在左侧菜单的技术支持中找到资源下载。在这里我已经放好了最新版的 fanout, 直接下载安装即可。好的,咱们回到 fanout, 双击刚才创建的连接,连接上服务器会来到这个页面, 接下来打开我的技术簿克,点击 opencll 部署教程。接下来复制第一行命令,回到非那上,再输入框粘贴执行,执行完毕,再回到技术簿克,复制下一行, 依旧是粘贴执行,这里是在安装 n p n 包管理器,执行完毕,复制第三条命令,回到非 no 手执行,这里是在安装 nojs。 安装完成后,回到技术博克,复制下一行。再次回到翻招社执行,这里是在使用 n p m 安装 openclaw 主体,这一步的时间会长一些,在这个过程中会伴随数条警告信息,这个是正常现象,不必惊慌。 安装完成,再次回到技术簿克,复制下一条,回到非拿手执行,这里会卡住一段时间,耐心等待即可。这一步是在出使画 open 框,出使画完成会出现 open 框字样, 这时用鼠标点击一下输入框以外的区域,然后用方向键切换到 yes 同意协议,然后选择默认的 quickstart, 快 速开始,直接按下回车确认即可。接着来到模型配置页面, 这里随意选择你需要配置的模型。主播,这里使用 g l m 四点七进行演示,因为主包购买了智普的编程包, 你可以选择别的模型进行配置。来到对应平台的控制台,复制你的 ipad key, 回到 fna 手,在输入框内粘贴执行。接下来选择模型,直接回车,选择默认的即可。 接着来到对话方式的配置页面,因为今天我们将用到的是 y b y, 所以 直接选择 skip 跳过即可。接下来的操作和主播保持一致即可。 这里需要按下空格后再按下回车,这里是需要你配置生成图片,生成语音等平台的 api, 一 律选择 no 跳过即可,如果之后需要可以再配置, 接着等它加载完即可显示视频中的内容,即加载完成。接着咱们回到技术博克,复制下一行命令,回到非拿手执行这里,发现刚才执行完没有退出,按下 ctrl 加 c 退出即可,然后再次粘贴命令,回车执行, 这里再安装一 panel 面板,用于反带输入。二、按下回车,选择简体中文,这里保持默认,直接按回车,这里问咱们是否安装 dak, 输入外后按下回车。 dak 将用于 openrest 的 安装。接下来设置面板基本信息,主播这里全部保持默认,直接全部回车了。 一、 panel 安装完成会显示面板登录地址,账号密码等信息,这里直接复制外部地址,然后在浏览器打开输入账号和密码登录, 然后点击左侧应用商店安装 openresty, 出现 t s k n d 后关闭页面, 然后来到你的域名的控制台主包,这里使用阿里云的域名演示,点击域名解析,如果你也使用的阿里云,则需要关闭这烦人的广告。然后点击添加记录 主机记录,填写你想设置的子域名主包,这里填爆它。回到 finner 手,在左上角复制你的 ip, 粘贴到记录值一栏,然后点击确定, 接着回到一 panel, 在 左侧依次点击网站证书, 点击申请证书主域名,填写你的子域名加主域名主包,这里填写 b o t, 点 l i h u, 点 s i t, 接着选择手动解析,然后点击确认,再点击申请 复制你主域名前面的点的前面的内容,回到域名解析页面,点击添加记录,记录类型改成 txt 主机记录,这里粘贴刚才复制的内容,然后再回到 epson 复制记录值,粘贴到记录值这里,然后点击确认, 然后回到 e mail, 点击确认,在右侧会自动开始申请证书,显示申请成功后关闭页面即可。然后再点击左侧网站,点击创建网站, 选择反向代理域名,和刚才申请证书时填写的一样主包,这里是 b o t 点 l i h u 点 s i t e 勾选起用 h t p s 艾克密账户选第一个代理地址,填幺二七点零点零点幺冒号幺八七八九,注意一定要是英文冒号,然后点击确认。接着咱们来访问这个网址, 那么恭喜你拥有了自己的小牛马。页面右上角可以切换量,按主题 还可以看到当前 open com 仍不可用。 回到 finner 向上翻找,找到 dashboard 信息,复制偷看等于后面的一大串代码。来到 opencore 的 overview 页面,再给退 token 这里粘贴刚才的内容,然后点击 connect 会发现仍不可使用,但报错变化了。 此时再次回到我的技术簿克,复制管理设备部分的第一行代码,回到 finner 内粘贴执行,执行完毕会看到一个设备 id, 然后回到我的技术簿克,复制最后一行代码,回到翻到手,粘贴到输入框,使用上方的 request id 替换掉代码内的替换 id, 然后按下回车执行。出现以下信息则是执行成功。现在再回到 opencll, 点击 connect 会发现现在已经可以开始使用了,可以在首页给他发送消息, 可以给他设定一个人设 channels 页面,可以设置聊天 app, 比如主流的纸飞机、 whatsapp 等。 skills 页面可以安装更多 skills, 让你的 openclaw 更加强大。 好了,那么今天的教程就到这里,咱们下个教程,再见。拜拜。

04:43查看AI文稿AI文稿

04:43查看AI文稿AI文稿最近 openclaw 特别火,相信大家都有关注,这款工具的命名已经调整,从最初的 cloud bot 到 modbot, 再到近期正式定名, openclaw 发展速度非常快,背后也有不少话题度。 了解的朋友都知道, openclaw 的 常规部署流程并不简单,网上虽有相关文档,但需要操作大量命令,调整各类配置参数, 仅 config 文件的设置就需要花费不少时间。而就在昨天,费志云在 epanel 应用商店正式上架了 openclaw, 这个便捷部署的方式直接解决了大家的痛点,从上架到现在, openclaw 的 下载安装量已经达到三百六十六人次, 在 epanel 应用商店的下载排名直接冲到第二,甚至超过了麦 c 果,火爆程度一目了然。而且 epanel 官方文档 也为其标注了全网最快最简单的安装部署指南,今天就带大家快速看完这个部署方法,实操一遍到底有多简单! opencall 是 可部署在个人设备的自托管 ai 助手, 支持对接飞书、企业、微信及 discord 等海内外社交办公工具,默认文本对接后能通过对话终端向电脑发指令,完成各类操作,实用性极强。接下来重点看一 panel 上的一键安装步骤,整体操作非常简单,小白也能轻松上手。 第一步,打开 epanel 应用商店,搜索找到 openclaw, 点击安装。第二步,按提示输入基础配置参数,包括容器名称、版本、 web ui 端口、 bridge 端口以及模型提供商模型 apikey、 openclaw web 页面访问令牌 token, 还有是否开启端口外部访问,这些部署的必要参数都界面可化了,同时参考 epanel 给出的配置说明,需输入对应的模型提供商和模型 id。 目前 openclaw 已支持 minimax、 deep seek、 quan、 timi、 openai、 gemini 等主流模型。最后一步提醒提醒大家,获取访问需要的 token 令牌。安装完成后,需要进入安装目录的 data com 文件夹, 打开 openclaw, 点 json 文件,找到 getv 模块,获取 token 令牌,之后将 token 记录下来,完成 web 访问地址的拼接。配置拼接好后,会设置为快捷访问地址, 就可以直接点击跳转进入 openclaw 的 操作界面。基于以上,我们需要提前部署好的 e panel, 并申请到对应模型的 api key。 一 panel 的 安装仅需要一条命令,模型则在各模型供应商处申请即可。接下来我就用已搭建好的 e panel 环境带大家实操一遍。 在应用商店找到 openclaw, 直接点击安装容器名称,最新的一点二九版本 web ui 端口一八七八九和幺八七九零, 这些默认参数都不用改。模型方面,我准备了 deep seek, 直接把文档里的 deep seek、 deep seek chat 复制到模型输入框,再粘贴提前准备好的 api key。 token 暂时留空,按提示后续从配置文件中获取即可,需要随意勾选开启端口外部访问。这里也提醒大家,公有云服务器要提前在后台开放对应端口,避免访问失败。所有参数配置完成后,点击确认,一 panel 会自动拉取镜像创建容器, 整个过程速度非常快,很快就能显示安装成功。安装完成后,在 e panel 已安装应用中找到 openclaw, 进入安装目录,在 data com 下打开 openclaw, 点 json 复制 get 位中的 token 令牌, 再回到应用的参数定义页面,点击编辑,把 token 粘贴进去并保存记录。之后将 token 与服务器 ip y ui 端口进行拼接, 拼接格式为 ip 地址加端口加 token 等于令牌。拼接完成后,输入到 web 访问地址中,然后重建应用,最后通过点击跳转就能进入操作界面,到这里整个部署就完成了,全程没有任何复杂操作,小白也能轻松搞定。部署完成后,我们来体验下 opencloud 的 实际功能, 我直接向他发送指令,帮我整理一份系统资源清单,存储在新建的小白跃升房文件夹中。发送指令后,能清晰看到 open cloud 干活了。过程中如果某个命令获取不到信息,它会自动尝试其他命令,直到操作成功。最后它会整理出完整的系统资源清单, 还会在对应文件夹中生成资源信息、文件资源快照以及一份 random 文档,清晰标注整理的信息内容。整个过程无需人工干预,完全由 ai 自主完成。最后我们到服务器的 data workspace 目录下, 就能找到 open cloud 生成的所有文件,各类信息整理的条理清晰,这就是属于我们自己的 ai 助手,不仅能帮个人处理各类电脑操作,在企业场景中也能完成很多办公任务,实用性非常强。以上就是通过 e panel 一 键部署 open cloud 的 完整教程, 相比传统部署方式,这个方法省去了大量命令操作和配置步骤,真正实现了简单高效部署。感兴趣的朋友可以自己尝试一下。

138小白跃升坊 03:13查看AI文稿AI文稿

03:13查看AI文稿AI文稿咱们上期用那个 onigravity 连接这个 open cloud, 以最小的成本来使用 open cloud。 后来就有同学问我应该怎么用 open cloud 连接欧拉嘛?其实有三种方法,应该也不止三种方法,今天介绍几种简单的方法 来连接。第一种方法,其实最简单的,如果你还没有从 outboard 升级到 open cloud, 你 就可以用这个命令,就 alama launch cloud bot, 这里个你接运行就可以了,它会自动检测你 open cloud, 它会自动检测你 欧拉玛里边已经配置的,不管是云端,它是本地的模型,自动配置上这里话是它这里显示出错,但是没问题啊,是因为我这个本地已经运行了 open cloud 的 实力,所以它就会出错,但是咱们可以看一下它是怎么配置的,它会自动把你的配置面念改成这样。 cloud bot, 看,咱们搜一下奥拉玛,奥拉玛这里的话,你可这个很重要,它已经配置好了,不只是 cloud 的 官方云上的模型,还有本地的模型千万二点五, 包括千万四 b, 这个是我自己配置的,这样就可以直接保存。第二种的方法,配置奥拉玛的方法其实更简单,你就可以直接去它的路由 model 点路由这边就可以配置了,叫 api, 也是咱们也选这个, 它刚才是什么来着? open i competence 支持这个模型,就是 apikey, 这里是跟那个是一样的,看 baseuile 也是刚才咱们看到那个下面就是模型了,你看这里有 context window, 这边有 id, 跟跟这个跟配置文件里边其实是一样的,只不过不如看,不如看那个配置文件来的直接。咱们再说一下第三种方式,咱们说一下其实刚才的配置文件自己加,刚才是奥拉玛自己加上,第三种方式咱们自己 加上,咱们这次看我的 open cloud, open cloud, open cloud jason 这里边我也配置了,咱们看一下我的欧拉玛,这个里边是我自己 copy 过来的,从旧的那里边 大家看还是一样的,在它的跟的 jason 下边直接加一个 models providers, 里边加上,那就可以了。另外这里说一句,这里不止可以连接那个奥拉玛,也可以前连接 lm studio, 我 一直特别喜欢 lm, 它不仅支持它里边支持的模型很多,不管是开源的各种模型都支持, 这样也可以同样的把它是配成 lm studio bc u i l 这个 bc u i 我 从哪来的?咱们这里的话,因为我用 lm studio 应该知道这里是它的聊天框,这里第二个它也可以把它 的 api 暴露出来。现在我用的是千问的四 b 二五零七,这是它的在本地的地址,这里也可以用这个来配,更多的信息可以在这找到,可以填进去,也可以跟奥拉玛一样使用, 这就是三种方式配置,但是配置完之后,大家一定要记住,不管是 open cloud 还是 cloud, 已经要运行这个什么 o, 以 open cloud 为例子了,就是 open cloud it way restart, restart 完之后我们再拆开一下 status, open cloud status。 最后咱们通过 chang 来验证一下啊,你看如果运行这个命令呢,有斜杠 model 的 话,它会自动告诉你现在用的模型是哪个。好,今天就到这里了,希望可以报道你,谢谢。

2481124163362