原版的小龙虾基础上,给他做了一个 u r 的 一个重写命令窗的引导页,给他变成网页版或者是 windows 版。然后在这可以选择不同的模型, 也可以自定义自己的全局接口 网关配置。在这小龙虾,它可以自动发现当前局域网所有的小龙虾设备。 在这个配置通道,我们启动哪个,它就可以默认走哪个通道。 然后对 windows 技能做了一个全面的适配, 增强了他在 windows 环境下的一个一个技能和插件的适配,可以在 windows 电脑上也可以像 mac 一 样流畅的运行。 还有搜索,搜索方面的配置直接可消化,当我们点击完成 之后呢,他就就跳转到我们的页面控制台,并且增加了中文方面的适配。多语言 代理可以在这可以选择我们所有的内置的模型, 模型方面呢,也增加了一个工艺供应商管理和配置,它会显示每个供应商所包含的所有模型。 技能呢,给他做了一个更方便操作的页面。 其次增加了 mcp 市场,可以通过安装对应的 mcp 快 速来结合 mcp 相关的技能来实现一个正确的对话。

粉丝1195获赞4971

相关视频

06:46查看AI文稿AI文稿

06:46查看AI文稿AI文稿今天一个视频教会大家不花一分钱去安装和使用 open k 二的,然后而且是一百二十 b 的 云端模型,今天纯干货分享,按照我的操作步骤来,基本上一次就可以成功。然后如果你现在没有时间的话,可以点赞收藏加关注, 然后以后慢慢看。然后我现在这台 macbook pro 上演示,没有 mac 的 话也没有关系,只要是一台电脑就可以, windows 和 mac 都可以。然后因为 mac mini 比较省电,比较适合七乘二十四小时运行。然后我们开始第一步,首先你需要去解决自己的网络问题, 网络问题我没有办法去解决,解决完之后,你可以先打开这个网站,然后这个网站我会贴到视频的简介里面一个登录的,如果你是 windows, 它就会匹配 windows, 如果你是 mac, 它就会下载 macs 的 安装包。然后我刚下了一个,下载完成之后呢,把软件拖到 这里,因为我已经安装了,所以替换一下, ok, 我 已经其实已经有了,如果你是正常的话,现在就可以打开奥拉玛这个软件。然后你会看到这里可以选择各种各样的模型,这后面带云的这个就是云上模型,云端模型也可以用。然后我选的是这个 gpt 一百二十 g 的 云的模型,它会提示让你登录,然后你点这个登录, ok, 呃,我之前已经登录过了,如果你是一个登录界面的话,你可以选择你有的那个账号登录就可以了,很简单。然后现在已经登录了,我说一个你好, ok, 现在是可以用的。这是第一步,我们已经完成了。然后我们来到第二步,打开这个网址,这个网址我也会贴到下方,然后全是英文,看不懂没有关系,也不用翻译,有用的,其实就这几行,就这四行。然后我们首先第一步复制这个代码, copy 一下, 然后搜索终端,打开终端,这是我之前打开过的,打开终端之后粘进去,然后直接回车就行,然后他现在在慢慢安装,然后可以看到这个地方在加载,然后安装速度取决于你的电脑网速。 ok, 第一行代码已经执行完毕,现在我们打开浏览器 开始直进第二行,然后依然是直接回车,然后我们已经到这个页面了,然后现在在键盘的上下左右去切换,按左边选择 yes, 然后回车,然后有一个快速安装,我们点快速安装,就第一个不用选它,直接回车,然后这个这个页面比较重要, 他现在是让你选择是用哪一家的这个服务,然后我们不选,我们选最下面这个,然后我们选第一个,然后这里会有很多这个,然后还不用管,选这个 k 第一个。 ok, 这个地方是让你选用哪一家的聊天软件,因为你需要用聊天软件去跟他沟通,然后这个我们需要选一下,我们选第一个, 然后这里会让你输一个,呃, bot talking, 然后这时候我们先这个页面先放一边,千万不要关掉,然后我们打开我们的聊天软件,然后去搜索 bot father, 这个是之前我已经新建过的,如果你从来没有用过的话,这里应该是一片空白,然后点 start, 这里有很多选项,没有关系,点 new boot, 然后我可以这里是选名字,可以选择一个,好,我选这个名字, ok, 这里再输入你的自定义的,你可以随便自定义一个名字,他说这个不行, 那我们就随便起一个, ok, 这个名字可以,然后记得这一串,这有个 api, 把这一串字母复制一下,这就我们需要的那个 api, 然后直接粘到这个里面回车。 ok, 这里是问你需不需要技能,你可以选择是 然后第一个继续点回车这些技,这些下面就是技能,现在我们不安装,因为这些安装非常的浪费时间,我们直接回车,可以后面慢慢安装,没有关系,回车这个时候我们需要按下空格,然后再回车, 局部这些全,全是 no, 全是 no, 全是 no, ok, 全是 no, 这个也是直接跳过好,按空格再回车,好,到到这一步了可以直接启动,那这一步可以直接回车。好, 需要 u i 依然是回车。呃,如果你是 safari 浏览器的话,可能会失败,所以你要复制到那个 chrome 浏览器里面,然后现在我们就已经进入到了这个 colobot 的 这个后台里面,但是还有一个就是我们还没有给它配置大脑,现在这个页面我们关不关都可以,然后我们再新建一个终端页面, 新建一个窗口,打开我们刚刚那个浏览器,就用这个浏览器,然后翻到第三个,我们继继续复制,然后回车, 这个页面其实就在选择,就选择复制第四行, ok, 这里是让我们选择是用哪个模型,有 g p t, 一 百二十 b 的 模型,还有纤维三,也是四百八十 b 的 云端模型, 这个看你个人习惯,我现在就选这个 g b d, 好 吧,如果你选择的话可以点回车,回车点个叉就是回车,但是一次只能选一个。这个你可以后后面慢慢根据每个模型的不同属性去选,然后你选择,选择完之后,我现在选择一百二十 b 的 模型,选择之后摁 tab, 摁 tab 之后 ctrl 点回车, 这时候他问你是不是要启动这个东西,你现在摁 y 再摁 y 哦, ok, 我 们现在可以直接启动它了。 ok, 已经启动了,然后我们来到这个后台模型问一下。 ok, 已经可以启动了,进入我们刚刚新建的这个 bot 里面,点击 start, 它会发出一串神秘代码。没有关系,我们只需要这个复制这个出来,然后你把这串代码后面的换成你的,然后前面跟我一样就可以,然后复制 粘到,我们可以新建一个窗口,好,回车。好,这样就可以了。 ok, 我 们在这个页面问一下。你好, 出现这个报错的原因是因为刚才在安装过程中,我没有把安装终端给关闭,所以刚才在替换那个模型的时候没有替换成功,因为软件在运行当中,所以我在前面剪辑的时候增加了那个建议关闭的提醒,你把它关闭之后就可以不会出现这个报错。但是如果你出现这个报错之后,可以 把所有终端都关闭,然后新建一个终端,把第四行代码重新执行一下,重新选择一下模型就可以解决。 他能够解决一些比较棘手的问题,尤其是你不在电脑,你可以让他给你发文件啊,这种我觉得还比较实用的。 这个基本上就是可恶 boss 安装的全过程,然后是使用的本地的欧拉巴模型,但是云端的模型,然后如果你有任何不懂或者是有报错或者是没有解决的问题,可以私聊我,或者是在这个评论区下面留言都可以,如果看到的话会尽量帮你解决好,就这样。

2498小马beta 11:41查看AI文稿AI文稿

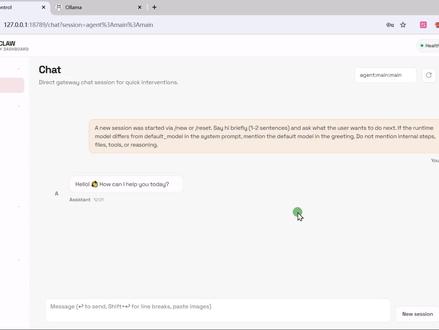

11:41查看AI文稿AI文稿cloud bot 一 夜爆火,这是一个运行在本地电脑的开源 ai 助理,短短几天内, github star 数量直线拉升,已经超过了十二万。本期视频我们带来一个 cloud bot 的 全面攻略,看看 cloud bot 比起其他的 ai agent 有 什么特色。 我准备了十几个案例的玩法大全,还会介绍一个接入飞书加国产模型的方案,让 cloud bot 在 国内网络也能顺畅使用。视频开始之前,先插入一个小插曲, 由于 cloud bot 受到 ansorepic 法务团队的压力, cloud bot 先是改名成了 motbot, 现在又改名成了 open cloud。 爬爬虾做视频的速度还赶不上它改名的速度,所以本期视频我们还是统一叫它最开始的名字 cloud bot。 cloud bot 功能跟 cloud code 和 open code 都有点像,都可以处理文件编码、调用 skills、 m c p 等等帮我们处理工作。 cloud bot 的 最大优势是可以接入各种聊天工具,也就是我们即使出门在外,手边没有电脑,只需要在聊天工具里面给 cloud bot 留个言, cloud bot 就 能自动干活,还能把屏幕截图、执行过程等信息实时同步过来,非常的方便。第二个优点是, cloud bot 自带了强大的定生物系统, 只需要用自然语言就能创建定身舞,比如可以创建一个临时的提醒,还可以定时检查收件箱通知等等,它可以智能地判断事情的紧急程度,选择是否用聊天工具跟用户进行沟通。比起传统的指令执行、指令执行这种固定的流程, cloud bot 就 具有了很强的主观能动性。 它的第三个优点是具有长期记忆,可以把记忆作为文件存储在本地,在日常的对话中能够搜索,并且把相关的记忆捞回上下文,随着日常使用,它还会主动去更新这些记忆文件,会有一种越用越聪明的感觉。好,我们先在本地把软件安装一下, 任意一个能运行 note g s 的 环境都可以部署 cloud bot。 我 最推荐就是使用 mac 或者 linux 系统的家庭服务器。 现在最火的部署方案是使用 mac mini, mac mini 的 最大好处是 mac 系统有不错的桌面环境,这样可以很方便地进行截图、操作、浏览器等等。第二点是功耗比较低, 七乘二十四小时运行,比较省电。第三个优点是 cloud bot 里面许多 skills 跟 mac 生态是绑定的,没有 mac 电脑的话,可以选择 linux 操作系统,或者在 windows 里面创建一个 linux 的 虚拟机。操作步骤跟接下来是一样的, 我选择的安装方式是 node js, 我 们来到 node js 官网,把第一个命令复制一下,然后打开终端执行一下,接着是第二个命令,第三个命令, 这样 node js 就 安装完成了。下一步我们来到 cloud bot 的 官网,在这里有一个一键安装命令,如果我们使用官网上的一键安装命令的话,注意要区分现在软件的名字,比如现在叫 open cloud, 后续所有操作的命令都应该是 open cloud 开头了,这里我选择 npm 的 安装方式, 我们看到 n p m 这里命令还是叫 cloud bot, 所以 后续我输入的命令都应该还是 cloud bot 开头了。这样我把这个命令复制一下,粘贴到命令行窗口执行一下。安装完成,我们输入命令 cloud onboard 来进行初步化。第一步,先配置 ai 模型,因为我有 open ai 的 plus 订阅,所以这里我选择 open ai, 当然下面也有很多不错的国产模型可以选择。视频的后半段,我们再来配置使用国产模型。选择 open ai 以后,再选择第二个 chad gpt 登录, 登录一下我的 chad gpt 账户,这样 ai 模型就配置完成。默认模型我选择的工具是 whatsapp 视频的后半段。我们再来看如何绑定国产的聊天工具。我们打开手机上的 whatsapp 右上角三个点已关联设备,关联新设备,扫一下屏幕上的二维码,这样就绑定完成。接下来选择预装的 skills, 按空格键打上对勾选中,这里可以按需进行选择安装下面的这些 api k 可以 全部选择跳过,然后 ai 会询问我们一些关于人设方面的问题,我们回答一下,这样就配置完成。我说你可以给我的聊天工具发一个消息,我们看到手机上收到了消息,这样就完全配置成功了。 我们先来介绍几个基础命令的使用。输入命令 cloud bot gateway, 这个是启动主程序,我们可以通过关闭控制台来停止 cloud bot 的 运行。在 cloud bot 后台运行的时候,我们可以新开一个窗口, 输入命令 cloud bot t u i 就 可以进入这个控制台的对话界面。输入命令 cloud bot dashboard, 可以 进入一个网页版的控制台,在这里可以进行基础的对话。上面还有很多配置,可以管理定身舞,管理 skills 等等。输入命令 cloud bot channel logout, 可以 退出 cloud bot 上面登录过的聊天软件,然 然后我们再输入命令 log in, 就 可以重新登录一下,因为有的聊天软件可能隔几天就会掉线,我们可以使用这个命令重新登录一下。我们来看 cloud bot 最有意思的一个功能就是它的定身物,定身物赋予了 cloud bot 的 一些主观能动性,让它变得更像一个智能的 ai 助手。 比如我输入这个命令,提醒我两分钟以后关煤气。 cloud bot 回复我,好的,已经设定成功了。我们可以在网页版的控制台 crown job, 也就是定身五这个选项卡可以看到 cloud bot 为我们设定的定身五,这里显示两分钟后执行。两分钟以后,他就把这个消息推送到了手机上,提醒我去关煤气。 cloud bot 具有操作浏览器的能力,我们需要先在 mac 里面下载一个 chrome 浏览器,我要求 cloud bot 去 m i t 公开课下载 python 课程的课件,放到我的桌面,我们看到 cloud bot 自动打开了 mac 里面的 chrome 浏览器,找到了 m i t 公开课的官网,并且搜索 python。 他 找到了几门 python 课程, 回复了我课程的编号,让我选择这里,我选择第一个。他又在浏览器里面通过课程编号找到了这门课,并且下载到了桌面,然后我要求他把它解压出来,他调用了麦克的命令行工具完成了解压,然后我要求他把第一节课的课件发给我 这里可乐豹成功找到了课件,并且完成了发送,效果不错。接下来我们来看一个把浏览器自动化跟定生物组合起来的案例。爬爬虾,作为一个科技软件类的博主,需要经常查看 github 的 热点, 这里我告诉 cloud bot, 让他查找一下 gitap 上面的热点,然后做个中文简报发送给我。 cloud bot 生成了中文简报,接下来我说每天早晨八点你都做这么一个简报发送给我。 接下来 cloud bot 生成了一个定身舞,每天早晨八点都执行这个工作。我们可以在 cloud bot 的 控制后台查找到这个定身舞,每天早晨八点都会自动执行这个工作流程,发送给我简报效果不错。除了操作浏览器, cloud bot 还有图像识别等 ai 视觉方面的能力。 这里打开 mac mini 的 设置隐私与安全设置录屏与系统录音,我们在这里搜索终端两个字,给命令行终端添加上录屏和录音的权限。接下来重启一下 cloud bot, 我 在手机里面说,请给现在的 mac 截一个图, mac 电脑当前的图片就发送到了我的手机上,可以实时的对状态进行监控。 目前为止我们依赖的是海外的聊天工具。接下来我们把 cloud bot 接入飞书,让他在国内的网络也可以顺畅使用。我们先来到飞书开放平台,点击创建企业应用,填写一个名字与描述。接下来点击左侧添加应用能力, 选择机器人。然后我们来到权限管理,点击添加权限,总共需要添加屏幕上这些所有的权限。 接下来来到版本管理与发布,填写一个版本号,点击发布。我们回到 mac 终端,输入第一个命令,安装飞书插件。第二个命令,配置 app id, app id 可以 在飞书开放平台凭证与基础信息里面找到, 把 id 粘贴到命令行里面执行一下,然后配置 app secret, 同样在凭证与基础信息里面找到同样的,把 secret 放到命令里面执行一下,下一个命令,开启飞书 channel。 最后第四个命令,把链接方式改成 web socket, 然后我们重启一下 cloud bot, 这里我总结了需要执行的几个命令,有需要的观众朋友们可以截图保存一下。回到飞书开放平台,在事件与回调这里选择长连接,点击这个铅笔,点击添加事件,然后勾选接收消息,最后点击顶部的创建版本, 我们再提交一个新的版本,这样飞书就配置完成了。在飞书的手机 app 里面,我们可以找到开发者助手,然后点击打开应用这里我打一个招呼,你好,飞书有一个非常可爱的机器人正在输入的表情,我问他现在几点了,这里给出了回答。然后我让他给麦克截一个屏, 告诉我需要先在控制台跟他对话一次,开通权限才可以截屏。这里我们来到麦克上面的控制台,跟他对话一次,允许截屏,这样截屏完成。我们看到飞书也同样可以传递文件传递截屏。我们把聊天方式换成了国内平台 ai 模型,同样也可以换成国内平台。 cloud bot 的 作者推荐使用 mini max, 这里我们来到 mini max 的 开放平台左侧,选到接口密钥,然后创建一个 apikey, 然后我们打开 mac 的 控制台,输入 cloud bot config 来配置一下模型,选择 mini max, 然后我们把刚才创建的 mini max api k 填写进来,一路回车就配置完成。来到 cloud bot 的 控制台,输入命令斜线 models, 然后我们可以选择 mini max 模型, 选择完模型以后,我们再重启一下 cloud bot, 这样模型就切换完成了。 cloud bot 的 强大之处在于它内置的 skills 可以把各种第三方的生态接入进来,比如这里的 g u g skills, 可以 把谷歌邮箱、日历文档等功能都接入 cloud bot。 我 们点击这个安装按钮,这里要提醒一下大家,安装的时候要把 mac 系统更新到最新版,否则有可能会失败,这样一键就安装完成。 来到谷歌 cloud, 我 们在左侧菜单找到 api 与服务,选到 o o 四权限请求页面,创建 o o 四客户端应用类型,选择桌面 app。 然后我们把生成的这个 json 文件保存下来,把文件拖拽进 cloud bot, 告诉他配置一下 g o g 的 认证,然后我们登录谷歌账号,并且授予权限,这样就完成了配置。接下来我让他看看我的邮箱里有什么邮件,让他总结一下。 这里 ai 提示我需要再开通一个 gmail api 的 权限,我按照它的提示把权限开通完成,它就可以读取到我的邮件了。接下来我让它把所有的邮件移动到垃圾箱,这里也成功完成了。我在手机上让 cloud bot 帮我发送一封邮件, 我们看到邮件可以成功发送,我让 cloud bot 设置两分钟一次的心跳检查,如果有发现新的邮件,就发消息通知我,我给这个机妙邮箱发送一个邮件来测试一下。这里 cloud bot 成功给到了通知,我让他总结一下邮件内容,他也完成了总结。 ai 助手对接其他生态,一个重要的渠道就是 m c p, 我 们可以在 skills 里面找到 m c p porter, 把这个 skills 安装一下。接下来我告诉 ai 用 m c p porter 来配置一个百度地图的 m c p, 我 把这个 m c p 的 说明文档贴给了他。 ai 提供了三种安装方案,我选择 streamable h d d p。 他同时要求我提供百度地图的 a p i k, 把这个 a p i k 复制一下粘贴给他,这样就完成了配置。他已经可以使用这个 m c p 查询到地理位置的坐标了,这样我们就配置完成了,我们也可以在手机里面使用,我让他查询一下从青岛太平角公园到崂山羊口景区怎么走, 这里成功给到了规划路线,效果不错。我们再来看一个 skills 的 使用,这里有一个 skills 叫做 coding agent, 它可以驱动本地的 codex, cloud code、 open code 等 ai 编程工具 直接进行编程。这里我们先把这个 skills 安装一下,我在 mac 电脑上登录了我的 codex, 接着我在手机上跟 ai 说调用 codex 创建一个贪吃蛇的游戏,我们看到程序就编写好了,这样我们就通过 cloud bot 驱动 codex 完成了一个程序的开发。

5.2万技术爬爬虾 01:45查看AI文稿AI文稿

01:45查看AI文稿AI文稿openclaw windows 系统详细安装部署教程来了! openclaw, 一个能让 ai 大 模型像人一样操作你电脑的智能助手,今天就带你花两分钟在 windows 系统本地部署小龙虾。操作步骤很简单, 首先前往官网安装 node js, 这里我们直接下载稳定版本即可。下载完成后,打开文件夹,点击进行安装,安装的选项全部默认。 安装完成后,使用管理员模式运行终端,使用指令查询 node 点 js 的 版本号。 接下来开始安装相关指令,可前往评论区领取,可以看到安装已完成。接下来进行具体配置,输入指令后,这里默认为不同意,我们改成同意 yes, 这里选快速安装 quickstart。 由于我之前配置过一遍,所以这里选择更新 模型。以 glm 为例, apikey 可以 前往官网获取接入的聊天软件,我们先跳过安装 skills, 选 yes, 选择 npm 安装软件包预设 skills 我 们也跳过,这里是第三方应用的 apikey, 相关设置都选 no, 给出的三个 hooks 最好都勾选上。由于之前配置过官网服务,这里我选择重装 reinstall, 等待它安装完成。 抽象 bot, 选择 open the web ui 配置完成后,我们就进入 open cloud 界面进行简单的尝试。比如我们让它在 c 盘创建一个文件模型,回复我们文件已创建,那我们进入 c 盘检验下, 可以看到确实已经创建,说明我们本次的安装部署成功了。关注我,解锁更多开源软件操作小技巧!

8357小白跃升坊 02:27查看AI文稿AI文稿

02:27查看AI文稿AI文稿大龙虾这波热度呢,让所有云厂商都卷了起来,基本上都出了自己的云端部署方案,今天我就用阿里云带你跑一遍,十分钟拎包入住云端版的贾维斯 open club。 说实话,本地装不是不行,但你得折腾环境配依赖,还得自己对接模型 a p p。 对 普通人来说呢,直接劝退 好。首先,我们打开阿里云的清凉应用服务器页面,在镜像这里呢,直接选择 multi boot, 他 已经把运行环境打包好了,你不用自己装任何东西。 配置的话,镜像要求最低是两盒两 gb。 地域呢,随便选,国内国外都行,国内因为有网络 bgp 优化会贵的,这里我选择国际型。确认好我们的地域, 这里我选择新加坡,因为我不是新用户啊,新户价格首次还会更便宜,最低九块九,一个月六十八块钱呢,就能直接包一年, 或者像我这样直接想尝尝鲜啊,先购买一个月,确认这些都没问题之后,点击立即付款。付款后呢,等服务器启动,服务器起来之后,进控制台,你就可以看到我们买的服务器了。点击进入我们的服务器详情页,你可以看到这里面一共需要三步,我们挨个执行就可以。第一步啊,放通端口,页面上有个一键放通,点一下就可以。 这要是你自己部署啊,这一步我估计会卡住很多人。第二步,配置我们的 api key, 还有生成 token, 这里需要跳转到阿里云百联平台,在密钥管理里创建一个 openclaw 专用的 key, 复制过来粘贴执行。 第三步,获取专属链接,点执行命令,它就会给你分配一个专属的链接,记住这个链接啊,后面点进去就能直接进入 opencloud 控制台了。到这一步啊,整个部署呢,就算完成了。看到了吗?就这么简单,一共三步,除了等服务器创建的那几分钟啊,实际动手操作呢,用不了五分钟, 完全不用碰触任何的命令。行,你就可以拥有一个自己专属的大龙虾,而且只花了一顿饭钱,这比你去买 mac mini 简直省太多了,也不用担心关机断电这些问题。那怎么验证跑起来了?你可以直接在控制台里跟他对话, 也可以像我这样呢,接入钉钉,做一个钉钉的机器人,直接在手机上艾特他,因为模型默认是帮你接入了千问三 max 的 最新版本,推理更强,都是对话呢,你的 ai 助理呢,依然会在后台帮你联网查找资料, 整理信息。那怎么能玩一些更复杂的自动化任务呢?网上其实已经有不少博主做了详细的教程,阿里云官方呢,也写了教程文档,想要的呢,我可以发给你,感兴趣的可以自己去研究。 成本上还要说一下,模型调用呢,是单独计费的,轻度玩玩呢,基本是可以忽略的。但如果你想做一些复杂的任务呢,还是建议去百炼平台购买这种扣丁 plan, 也就是固定月费可用的 token 额度呢,会更多,也更划算。所以以后这种拎包入住的云端化,才是未来 ai 普及的正确姿势,你们觉得呢?快去试试吧!

1.5万赛脖古 02:34查看AI文稿AI文稿

02:34查看AI文稿AI文稿hello, 大家好,这期视频跟大家介绍一下如何给 openclaw 选择一个性价比最高的模型,因为其实在之前的这个视频中,我主要强调了一下,就是大家可以选择千万这个模型,因为千万这个模型目前是免费的,但是目前呢,我陆陆续续收到一些反馈,他们在使用 openclaw 的 时候呢,实际上千万的免费的拓展数量已经不够用了, 所以这期视频我还是想跟大家介绍一些啊,目前收费的,但是性价比极高的一个模型,那么我最推荐呢,其实大家就是用 kimi 的 coding plan 啊,大家可以去登录这个 kimi 的 这个官方网站,然后选择 kimi code 的, 然后会进入到一个 kimi code 的 这么一个啊主页,大家往下拉会发现它目前有三个套餐,一个四十九,一个九十九,一个一百九十九的啊,本期视频不是打任何广告啊,首先我还是想强调一下,就是目前大家只需要选 四十九,每月的这个就已经足够了,那么怎么去配置呢?我也简单的跟大家演示一下,然后大家只需要打开这个 terminal, 也就是我们的终端,然后输入 openclaw, 然后 config, 然后选择模型啊,选择 local, 然后选择 model, 然后选择这里大家会可以发现有个叫 mc 的 一个英文的名字,大家选择这个之后呢,选择第三个, 然后选择第三个之后,就会要求你输入一个 kimi 的 扣定 api k, 那 这个东西从哪拿呢?其实你只需要订阅之后,你就会可以在你的控制台,然后找到你的这个 api k, 然后如果没有的话,你创建一个就可以了,那么利用这个 这个 api k 呢?就然后再输到这个同城里啊,经过我自己的实测啊,就进行一个中度频繁的交流的话,这个四十九元的套餐是完全够用的。比如说我现在给这个 opencloud 设置了大概十个左右的定时任务,然后每天会在不同的时段去执行这些定时任务。其实执行定时任务都是需要耗费大量的 tokyo 呢,那么在这种情况下,四十九元也是够用的。如果说一个免费的千万的这一个 模型,然后你的 tokyo 的 量超限了,那么你也可以给他配置一个 kimi ko 的, 但是我的建议就是大家可以同时配置这两个,为什么呢?因为 这样的话, open cloud 可以 在用完你免费的千万模型之后,它会 fall back 到你的这个 kimi code 的 这个 coding plan 里,所以大家不用担心说我配置了多个 呃,这个 open cloud 的 模型之后,它能不能够正常的工作,它其实是会有一个执行的顺序的,这个大大家不用担心。所以如果说你的这个千万的免费额度不够用的话,大家也可以去申请一个类似于这个 kimi code 的 coding plan 这么一个东西啊。 ok, 今天视频到这里,然后大家也可以去自己尝试一下。

211叶孤城 08:15查看AI文稿AI文稿

08:15查看AI文稿AI文稿喂,大家好,我是杰哥啊,我今天给大家带来一个,呃,怎么样把这个 openclaw 和这个 antigraphy 的 里面的模型呃结合起来,并且用 antigraphy 里面模型的这种方法啊? 呃,因为我们,呃例如说用这个 openclaw 的 朋友都知道这个 openclaw 呢,它使用起来非常的消耗 token, 那么怎么办呢?幸好呢,就是说我手头的旁边呢是有这个 antigravity 的 这个账号的,它里面的这个像吉米尼三模型和这个。 呃 o p u s 四点五 cking 啊,还有索尼这种模型呢,呃能力都非常强,并且呢额度也比较多啊,那我就想能不能让我的 open cloud 用这个 antigravity 里面的模型呢? 啊,这个经过搜索和查阅官方的文档呢,我们发现是可以的。好,我们打开这个呃官网的这个帮助文档啊,翻到这个 model 底下的这个模型供应商这个地方啊,我们就会发现这个地方他说有支持这个。呃,使用 antigravity 里面的模型好,这个地方他怎么说的呢?他说要启动,第一步是启动这个 google and gravity 的 插件,再一个就是登录好它这里呢,主要就是这两个命令啊,执行完了就可以了。好,我们这里来看一下啊,我们,嗯, 先执行一下啊,我们看一下我们这里当前用的是什么模型啊? 啊,我这里呢已经把这个命令发给了这个 open cloud 了啊,接着我们等待它返回 好,这个地方,它返回了啊,大家看是吧?这里呢,我们把它放大一点啊,它当前使用的是千万大模型啊,标记为标识是千万 port 啊, code model 啊,这个模型 好,我们这里呢,接着就按照啊官网说的这种两个命令啊,我们在这个那个里面来执行一下啊,我们这里呢进入到了这个,呃,我们的这个多可容器的命令,行啊,我们这里第一步我们执行 执行它的这个启动,这个什么呢? google and gravity os 的 这个插件啊, 好,这个地方大家看是吧?我们这里呢执行成功了啊,我们这里他说 opencloud 二零二六一一月三十号啊,这个版本 啊, enable plug in 啊,这个 google android gravity o whats 这个插件啊,这个插件,呃,假如说有些朋友你的那个里面没有的话,你可以先这样来确认一下这是什么呢? 找到你的这个容器或者是你的这个,呃, open cloud 它的这个代码的 代码的根目录下啊,找到这个有个叫一个程序式的一个文件夹啊,打开这个文件夹看一下底下是不是有一个叫 google anti gravity os 的 这个文件夹啊,这个就是这个插件啊,我们当当前执行的这个命令之后, 其实就是把它给起用了啊,起用了好,接着他说还要啊获得 antigravity 的 授权啊,这个地方怎么做呢?我们就执行第二条命令啊, 这个命令其实也就是那个什么呢?官网猎取的那个命令,只不过我是在这里执行,是把这个命令的后缀,是吧?大家看这个上面啊,这个后缀给它带上去了啊 啊,我们这里粘贴了之后回车啊,我们这里就得到了这样的一个链接啊,这样的一个勾勾的一个链接。好,我们复制这个链接啊,复制完了之后我们 到浏览器里面啊,我们到浏览器里面这个地方,我们来回车啊,让他访问这个链接。好,这个地方呢?他说要授权啊,我们这里点击这个账号 好,点击了之后这个地方他说要翻译,我们再点好,到了这个页面,他说,呃,那个链接不能不可达啊,我们不要担心。这个地方呢,我们就直接复制啊浏览器的这个地址,复制了之后我们回到 我们这个多克命令行里面啊,我们把它粘贴进去,粘贴了之后我们继续回车啊,回车了之后让这个多克这里继续处理好,这个地方它处理完了,我们来看一下 这个地方,它说,啊,这个 antigravity o word complete 啊,配置结束更新的这个 open cloud 下面呢,有个叫 configure json 的 文件 啊,这个授权的属性是什么呢?啊? google analytics antigravity 啊,这个 gmail 点 com 啊,用的是 google analytics oops 啊,默认的模型是什么啊?它说设置成了 google analytics 底下的克劳德 o p u s 四点五 cent 啊,用的这个模型 好,那个前面啊,我们执行那个的时候他说要干嘛呢?要重启一下这个 getaway 啊,重启一下 getaway, 好, 我们这里回到我们的这个什么呢?容器 好,我们这里到了容器这个地方啊,我们点击按钮让它停下来啊,接着再点击按钮,让我们的这个容器启动啊,我们看一下啊,再看一下这个容器, 让它启动完成啊, 好,这个地方它启动了。 好,接着我们继续回到这个 openclaw 这个页面啊,我们回到 openclaw 这个页面。好,我们还是用同样的文字啊,我们这个地方再发一遍,看一下当前啊,我们这个 openclaw 它是用的是什么模型? 好,它正在处理中。 好,我们放大一点,让大家看清楚一些啊,好,他说了什么呢?这里已经滚不下去了啊,他说当前使用的是 open cloud, 四点五 centen。 啊, google and gravity 啊,克劳德 o p o s。 四点五 centen 这个模型啊,这是 astrotik 的 点击推理模型,通过 google and gravity 平台访问。因为我自己手头有几个啊,这个 anti gravity 的 账号,所以呢,我就可以呃,把这个 anti gravity 的 账号的模型都接入到这个 open cloud 里面,这样的话,呃,我就可以呃以非常低的成本来使用到这些顶级的大模型了。 好,这个呢,是我今天这个分享的这个,呃,我们 openclaw 啊,如何来通过节省这个什么呢? 呃, token 消耗啊,降低我们这个呃一些费用的一些方法啊。呃,那个今天我的分享就到这里了。啊,谢谢大家啊,如果大家对我的这个视频有兴趣的话,可以给我一个关注。好,谢谢。

01:43查看AI文稿AI文稿

01:43查看AI文稿AI文稿openclaw 使用扩大模型加阿尔玛模型调用,实现零费用。首先来安装 openclaw, 我 的系统是 win, 第一步我们先下载 node 和 git 这两个插件,去官网进行下载即安装。 然后到 openclaw 官网,下面有安装介绍。 回到电脑桌面搜索 power 十二,点击右键以管理员身份运行,输入安装命令 是配置模型中选择,快一步步选就行了, 配置完会自动打开网页,没成功。没事,需要等三十秒刷新页面就可以了。 opencool 到这里就基本安装完成了。确认 alma 是 否运行,需要保持运行状态,然后我们让 opencool 直接指挥 alma 模型干活就可以。

114AI练练练 02:59查看AI文稿AI文稿

02:59查看AI文稿AI文稿今天给大家分享一个项目,让你用最少的钱去用上最好的模型来使用这个 open curl, 因为我们都知道这个 open curl 小 龙虾,它的性能很好,而且非常有意思,但是它的 token 消耗太恐怖了, 如果你要用 open i 的 这种 codex, 五点二,五点三这种模型的话,或者用 cloud 的 这些模型的话,它可能跑一晚上,你明天就欠费了。 今天来给大家分享的这个项目是什么?可以让你把这些 cloud code, 把这种 etgrity 这种应用 它里面的会员额度给它套成 token 来使用这个 open curl。 当然你如果要用在其他地方也是可以的,比如说你想用这 codex 这个模型去在 cloud code 里面使用也是可以的。这个项目本质上就是一个怎么样把这些会员的 token 给它套出来, 把它弄成一个标准的 a p i 的 格式,标准的 open i, a p i 的 格式,让所有的这种应用都可以去调用。 ok, 我 们来看一下,我直接给大家看一下出来的结果是什么样。提起来这个服务,就可以直接到这个网址里面去配置了,这是它的一些仪表盘,你可以配置上你的这些会员 ai 提供商是什么? 一般我们用的话,用这个 codex 的 会比较多一点,像其他的是这种 jammer 或者 ideographic 的 cloud pro, 这种会员基本上就不用考虑了,因为在国内是非常容易被封的, 所以说基本上是不用考虑的。所以为什么要用这个?它的二十美金 plus 这种会员它有一些渠道,它会比较便宜,并且最近最划算的是什么?去买那种 team 的 账号, team 的 母账号,它还可以拉四个子账号,只要几十块钱,它相当于你一共有五个这种 plus 的 二十美金的会员账号,然后你有五个 codex 的 使用量,你只要登录授权, 登录了之后,它的这个网址里面有一个 token, 你 就直接复制到这里面提交就可以了,它可能会报错,但是不用管它,你直接砍看这个配额管理,这后面就可以,只要它这儿是有的,都可以使用, 就是正常可以使用的。还有这些配置面板这些,这个提起来也很简单,大家用 cursor 或者说用 cloud code 直接全选 给它复制,让 cloud code 的 去给你做配置就行了,就 cloud code 的 这些直接给你做配置就行了,但是它还是有些坑,但是 cloud code 呢?这 coser 这些它自己就能解决,它需要自己去配置一个 key, 这个 key 随便是什么都可以。还有一个坑就是我这 cloud code 第一次登录的时候,它把这个这个东西它搞错了, 他以为不需要这个后缀,他一直告诉我这个,我让他检查,他检查了半天才知道他是要要这个的才能登录进这里,提起来也是非常方便。总体来讲这个项目还是非常不错啊,他可以把这种 codex 可以 套出来,甚至你可以把你的端口 去做个内网穿透,或者搭在服务器里面,这个项目你就可以去卖 token 了。我也用这个 codex 这个模型在我的 cloud code 里面去跑了一遍,它是真的有点慢。 codex 这个模型,但是它的准确度这些没太大问题了,感觉跟 cloud code 是 没有本质的区别的,但是效果都还是蛮蛮不错。

02:47查看AI文稿AI文稿

02:47查看AI文稿AI文稿如何给自己的 open claw 更换新的模型呢?很多同学觉得自己的模型不好用,或者说有些同学他想使用一些国际顶级的大模型,但是自己的网络却存在一些问题, 那么接下来磊哥就教你,在合法合规的前提下,我们可以去使用六百多种大模型,而且不需要解决网络问题,怎么用呢?接下来一个视频啊,给你讲清楚。 首先咱们想要换 openclaw 的 模型呢,咱们这时候打开命令行窗口啊,也就是 cmd, 那 么 windows 和 linux 呢,同样打开你的终端就行了,然后打开之后呢输入这行命令啊, openclaw configure, 好, 那这时候它就会开启 openclaw 的 配置,然后在里面咱们选择当前的机器的配置。好,在里面呢去选择 model 这个选项啊,敲回车。 好,那这里面呢就是模型了啊,我就可以去换了,那比如说我现在想要换 deep seek, 或者是我想要换其他的国际模型,又不想解决网络的问题,怎么办?这时候咱们是可以使用大模型的集成站的,那么这个大模型的集成站呢,几乎你想用的所有的模型都有,比如说像 deep seek 呀,豆包呀,还有国际大模型啊,都有的。好,那这时候 ok, 咱们就可以去选择它,然后敲回车,敲完回车之后呢,它是需要输入 api k 的。 好,这时候咱们就去获取 api k, 也就是来到它的这个 case 里面, 然后呢去创建一个 a p i k 啊,它支持的模型呢,大概给大家来看一下吧,这里面的模型相对来说还是比较丰富的,当然也有一些免费的模型,我们也可以用啊,但质量呢就不能保证了, 像国内的这些模型啊, mini, max 呀, kimi 啊啊,质朴的一些模型啊,还有国外的一些模型啊,都有的啊,当然我们目前呢总共是有六百多个模型的,当然我们也可以去搜索我们想要的模型 k 都是有的,几乎你想用的模型呢,他们家都有,但是这些模型的话是需要付费的,所以大家呢也注意自己的钱包啊。 好,然后完了之后我们要去配 k 的 话,这时候呢我们就去点击 k, 好, 然后 create 一个 k 啊,随便去起一个名字,比如说我就叫做,呃, demo 啊,这个无所谓,等会我就删了啊,然后点击 create, 然后就来到了呃,这个 api k 了。好,复制这个 api k 呢,到咱们配置页面啊,然后把它进行粘贴,然后粘贴完了之后呢,可以看到这边就有很多模型,我们是可以去选的, 然后这时候我们就可以去选择我们想要去使用的一些模型了,比如说国际的模型,我们可以往下去拉,那这时候我可以去选择一个,呃,国际模型,然后选择完成之后呢,咱们可以去敲空格啊,然后它变成加号了,就说明你已经选择了。选择完之后呢,敲回车啊,敲回车, ok, 然后继续啊,这时候 重新去启动你的 get v 服务啊,这时候它就变成了新模型了。好,那么接下来呢,咱们来看一下,输入一个 open, 然后 get v 敲回收好,可以看到了,在启动里面他的 model 已经换了,看到没?那这时候你就可以去使用你想用的六百多种模型了,但是大家一定要注意啊,大部分模型是需要收费的,所以大家一定要量力而行啊。我是磊哥,每天分享一个干货内容。

956磊哥聊AI 00:28查看AI文稿AI文稿

00:28查看AI文稿AI文稿所有人注意, open 科二免费下载教程来了,看原爱大模型,安卓苹果通用三步搞定,小白也能会。首先点击我视频右下角的小箭头分享,复制一下链接,然后返回手机桌面,在 我们自带的应用商店找到这个蓝色的小鸟,然后打开它,等待两秒会弹出一个资源包,如果没有弹出的话,我们在上方搜索出出云库也是一样的,我们点击立即查看,打开这个文件夹,然后找到工具软件合集包,最后找到你想要的内容,先保存再下载就 ok 了。

322初初小窝 16:56查看AI文稿AI文稿

16:56查看AI文稿AI文稿我们在前面安装这个 open 可露的时候,所使用的模型是智普的模型以及还有阿里百联的模型,但是这些模型的话都是属于在线的呃,它会需要很多个 talking, 那 这些 talking 呢,我们是需要花钱去买的, 那当然呢,也有人去反映这个在线的模型啊,它所消耗的 talkin 很多,所以说这个时候有人就想我们能不能使用本地的模型来部署 这个呢?当然是可以的,我们可以先到那个欧拉玛的网站上面去看一下啊,在他的首页这里面有一个 openclo, 我们点击进来啊,这里面没找着,没关系,我们往下拉一下,往下拉一下之后,因为这个 clubbot 已经改变为了这个 openclo 了,我们在这里面选择这个 openclo, 然后呢我们往下面拉,往下面拉的话,这里面的话呢,他就会有一些他所推荐我们所使用的这些模型。那么我们就建议呢,各位就是使用的时候就直接使用他所推荐的那些模型 啊,现在在我的环境这里面呢,我已经是把这些模型呢给它拉取下来了,那你使用其他的模型的话,可能还是会有一些问题的。 那下面的话呢,我们就开始去配置一下这个模型,点击这个 open clone, 然后呢我们点击这个 config, 点击 config 之后呢,继续找到这个 modus, 然后有一个 private, 然后这里面咱们就开始去添加一个模型 and you try, 那 这里面我给他一个名字叫欧拉玛好了, 这个名字你自己可以自己随便去取都可以。然后呢我们这个 api 的 这个位置呢,你可以选择这个是 compilation api key 的 话呢,这个可以随便去写 啊,因为我们的这个欧拉玛它不需要这个 k 去验证,这个你随便写什么都可以啊。 然后呢这里面我们选择 i p r k os header, 勾选上 bios ysl, 这里面的话,你就加上我们的这个欧拉玛的这个地址, 那么这里面的话,我现在的地址是端口是幺幺四三四,那这里面我们写的时候就是 h g d p 冒号本机,你你可以写任何的,你主机上的任何的一个地址都可以,零点零点幺, 这里面的话我们写上端口幺幺四三四,这里面一定一定要把这个 v e 给它加上去。 如果说你不加这个 v 一 的时候,那我们去访问的时候,他可能就是,对吧?你问他问题,然后呢他就回复的时候就是一个空的,什么都没有,所以说这里面一定要加上一个 v 一 才行。 然后呢我们继续往下拉,找到这个 modus, modus 的 话,然后呢我们选择这个 and, 选择 and 的 之后,然后在这里面 api 的 这个位置呢,我们也是选择 open i, 它的这个我们就选择 max talkings, 然后它的这个上下文的这个窗口呢,我们给它设置一个比较大的一个值就可以了,随便你去设值。 继续往下拉好,然后这里面有一个 id, id 的 话呢,就输入我们的这个啊模型的名字就可以了,比如说我这里面就直接使用 gptos 二十 d。 好, 那么然后呢我们继续往下拉,这里面有一个 and, 把它选择为这是一个 text 的, 然后这个 man talking 的 话呢,你也可以随便去写,我就直接写上一个四万就可以了。这个你随便去写, 然后给它起一个编名,我们就写成这是为一样的就可以了。这是我增加了一个模型。 那然后呢,我们你看啊,在它的官方网站上呢,给我们推荐了好几个模型,其中还有一个是 glm 四点七的,对于 glm 四点七,它这里面的话使用的是一种语音环境,我们这里面点击这个 mod 的 话,它不是让它是直接使用的,是在线的一个模型, 我们在这里面的话呢,也来给它加过来。在我的环境这里面的话,你看有一个 glm 四点七 club 的, 这里面的话,这里面呢,我也是给它拉取下来了。好,所以说我这里面再次增加一个新的模型,这几个我都给它加过来。 好,在这里面我们再次点击一下这个 and。 好, 然后呢,这里面我仍然选择的是 open i complexions。 然后呢这里面也选择 manage tokens。 窗口的话,我们在这里面你随便去写一个都可以 继续往下拉。然后这里面 id, 我 们把我们的这个镜像来给它加上去,就是 g, p, d, o, s s 的 这个 y 啊,这个是应该是选择的是 glm 四点七的,这个我们加第二个镜像。第二个模型 input 的 这个位置呢,咱们也选择 text 的, 这个位置的话,就随便去写一个比较大的值就行了。 这个名字的位置呢,我们也给它起一个命名,也叫的是 g m g r m 点 g cloud。 好, 第二个模型呢,我现在也是给它添加过来了。 那当然了,我们也可以再次去添加一个我们这里面添加的模型都是官方它所推荐的模型。 然后呢我现在再来添加一个其他的模型,这个呢,他并没有出现在官方推荐的这个文档这里面,咱们现在来看一下是否会有什么问题。我这里面选择枪顶三杠十四 b。 好, 这次去添加一个模型。好 and, 好的,现在这里面来给它收起来。好吧,这里面的话,我们仍然选的是它。好了之后,这里面选的 max tokens, 这个呢,我们就随便的去写一个比较大的值就可以了。 然后这里面 id, 我 们就把这个谦问三十四 b。 我 再说一次,谦问三十四 b, 这里面并没有出现在它的这个推荐模型这里面。 input, 这里面点击 text, 这个值呢?我们也直接输入一个比较大的值就行了。好,这样的话我现在添加了三个模型,点击 save, 咱们现在去看一下它的这个配置文件,点击打开 点击之后呢,这里面你看有一个 private 的,是百炼的,这个是我们在前面的时候已经添加过的奥拉玛。这里面的话呢,我增加了三个模型,一个是 gpt osss 二十 b, 还有一个是 grm 四点七克拉的,那还有一个是铅汞。三十四 b, 然后呢我们往下面拉,找到这个 agents, agents 的 话,这里面的话,这个模型的话咱们现在继续来给它添加过来,把这几个模型现在来给它加过来好了。好吧,呃,这里面的话,我就直接啊往后面去写, 这是一个这是一个,这是一个。 那这里面的话,我们直接选择的是维欧拉曼、 欧莱曼的这几个模型,咱们现在来手动的来给它加过来,然后 g p t o s s s 二十 b 二十 b, ok, 这个是添加过来了一个了,然后呢我们再把剩下的两个模型也来给它加过来。呃,还有一个叫做这是为 g r m 四点七 cloud 的 这个呢,我们现在也是把它的名字记 r m。 好, 那然后呢我们再次来给它增加一个,还有一个是千问三十四 b 的 铅汞三十四 b, 这个边名的话呢,我也给它起名叫做这是为铅汞三十四 b 就 可以了,那这里面的话,我现在额外的额外的增加了三个模型,那然后呢,我们现在使用其中的某一个模型,把它设置为是默认值, 比如说我这里面就是这是 default, 就是 设置的是它的默认值。 ok, 好, 我现在使用 g p o s s s 二十 b 的 这个模型保存一下,咱们现在开始去做测试,点击这个 chat, 好, new session, 打开一个新的脸际,新的绘画。 好了之后呢,咱们现在来跟他去沟通一下。你好,请问你是哪个模型? 它这里面的话,因为使用的是比例的模型,它这里面其实是会消耗比较多的这样的一个 gpu 的。 好,它这里面的话告诉我们说使用的是欧莱玛 gpt 二十 b 的 这样的一个模型。好,然后你可以随便的去交流就可以了。 好,请问是哪个模型? 好?这里面告诉我们说是欧拉玛 g p t o s s 二十 b 的 这样的一个模型了, 那当然呢,我们现在去换一下,我刚才讲咱们刚才看到的时候,它这里面实际上是会消耗比较多的 gpu, 那这个时候有的同志说我笔记本上面跑不起来,对吧?跑不起来,那么大的这个,呃,那么大的这个,呃这个模型,那没关系,我们可以直接使用什么呢?我们可以直接使用它的这个云端的这个模型, 也就是直接使用 g m 四点七 cloud cloud 的 话,它本地并没有去下载什么模型。 那这里面的话,你首先你得你要是想使用这个模型的话,首先的话你得要在欧拉玛的网站上自己去注册一个账号,记住了,你得要注册一个账号,注册一个账号之后呢?然后我们在命令行里面 去登录一下,在这里面有一个登录的这个名字。 好,欧莱玛,我们现在去登录一下,那这里面的话,你看我现在已经是登录了。那如果说你没有登录的话,比如说我举个例子来说,我现在把它给退出来,我不登录了, 不登录了之后呢,我重新去登录,你看他这里面的话是会给我一个链接,给我一个链接之后,我们在这里面把它切到我们的地址栏这里面来,他会问我们是否要去链接,当然了网站这里面你得要先去链接一下才可以, 这种方式就算是连接成功了,连接成功了之后我们才能够去使用这个云端的这个模型,我们可以试一下,好让 你好,我们来看一下他是否能够正常的去回复,你看此时是可以正常的去回复的, ok, 退出来就行了。那这里面的话,他啊我们这里面直接使用免费版的就可以了,你不用去花钱去购买什么,直接使用的是这一块免费版的,他也够我们去用的了。 那这里面的话呢,我们现在去换一下这个模型, glm 四点七 cloud 的 这个模型。好,我把它给换掉。换掉之后呢,然后我们现在重新的去跟它去做一个沟通,点击这个 new session。 好,我们现在开始跟他去交流。你好,他这里面的话就可以跟我们正常的回复了。请问你是哪个模型? 原来使用的是我们一开始刚刚所做的练习,使用的是这个 gpt osss 二十 b, 那 现在的话使用的是 grm 四点七 club 的。 那这里面你看它告诉我们说现在用的是什么?叫做是欧拉玛里面的 glm 四引擎 cloud 这样的一个模型。 那我们现在再次来给它换一个模型,我本地这里面,在我本地这里面有一个千米三十四 b 的 这个模型呢,实际上是可以正常去使用的,我们现在来打开看一下。 好,请给我写一篇两千字的作文。 那你看啊,我这里面使用的时候它是可以正常去使用的,看到了没,它消所消耗的 gpu 其实也是蛮多的,跑起来也是蛮快的,没有什么问题。我 ctrl c 终止了,对吧?你可以等一下也行。好,我们退出来吧。 好的,反正我现在就想说明的是什么呢?说明的就是我的这个千万三的这个我的千万三的这个模型啊,是 正常是可用的,对吧?然后呢,我们现在把它换到哪里面去呢?换到我们的这个 opencloud 里面来,我们看一下能否正常去使用。好,我选择这个千问三十四 b, 把它换成是默认的, 找到这个 agent 千元三十四币,那这个呢,就是我们的加载过来的这个模型呢,已经保存退出,然后这里面的话呢,我们现在再次去跟他去沟通 new session。 好,那这里面咱们现在来问一下你。好,他这个不稳定,我们也就是说使用千万三的这个模型的话,呃,他可能就不是很稳定,有的时候你看现在可能是正常的,但有的时候呢,他可能回复的时候就不是很正常。 好,你看这里面回复的时候,现在就已经是不正常了,也就是有问题了已经,对吧?那在我本地跑起来的话是正常的,但是呢,我们在 open clone 这里面去引用它的时候,运行起来的话,则可能还是会有问题的, 所以说我们在使用模型的时候就直接使用它所建议的这些模型就可以了。 那当然了,如果说你本地的这个啊机器配置的比较高,你可以直接使用千万三 q 的, 那如果说你所使用的这个配置不是很高的话,那这里面的话呢,我们就可以直接使用是 glm 四引擎的,这是属于是语音环境上的一个啊模型,那它这里面的话并没有什么限制, 对吧?你可以看一下,它这里面并没有告诉我们说可以免费使用多少 talking, 超过这个 talking 就 不能使用了,它这里面并没有这些要求,所以说我们直接使用在线的也是非常方便的。那如果说机器配置不高,那么我们就可以选择它机器配置比较高,对吧?你就完全使用本地运行的这个模型, ok, 你 就可以选择它。 这是我们如何让 open globe 使用欧拉玛所部署的模型?大家可以自己来尝试一下。

06:22查看AI文稿AI文稿

06:22查看AI文稿AI文稿大家好,我是根谷,今天是 open core 第六堂课啊,本地模型配置的 lm studio 片和微软的这样一个开发了这个,呃,本地大模型管理的工具啊。首先祝大家二六年, 呃,新年快乐,明天就过年了,建议大家先去看欧拉玛篇,因为欧拉玛篇会的话,这篇就非常容易了。非常容易了,那首先给大家看一下我这个那个 bug 啊,就是这就是 open core 的 一个官网,我前天好像提了个 bug 啊,就在这个英雄里面给他开了个 bug, 我 看看 这个 bug 其实就是 l m 十丢丢的一个 bug, 就是 在它重启的时候,它会失去了这个通信链接,我待会怎么证明我是它是一个 bug 啊,我把各个的环境啊,还有我怎么操作的选择的模型啊,最后配置文件都截图都分享出来了,现在还没有人回复我, 好,我是怎么做的呢?就是首先你要打开 i m 四丢丢点 ai, 这是微软的一个官网,你去下载啊,你如果你是 windows 电脑,它自动的,就会自动的给你到 windows 的 电脑那个那个,呃,安装的这个软件啊,你把它下下就好了,下下来以后就会出现一个这样子的 i m 四丢丢啊,这个就是你的一个那个, 呃,就比欧拉玛复杂多了,因为这个他不是面向开发者的,但是我感觉,呃,用这个也是挺不错的,他有海量的这样一个模型,让你去下载,我这里面下了一个千万三的一个模型。千万三的一个模型,呃,正常的就是在这个地方,比如说 给我讲个笑话,那这个非常容易啊,就不需要去给大家演示,你直接下一个模型,它都是界面的管理,你在这里下一下就好了,点它下载它就能下载,下载了好了以后在这个地方就能够选模模型,选到了模型以后,在这里你就把它去装入这个模型了,就是去加载这个模型,这个模型在这里, 在这个地方千万三星,那就就这个,就在这个地方。然后呃,我说这这个这里,这是他开发文档,然后这个地方他有几个端点,就是他有几套的去对接 api 调用,你首先去这里设置里面把这个, 呃网络这个服务供应,这个服务网络中提供服务,把它打开之前是默认关闭的,你把它打开就好了,那这个端口也不要去改,就用它的一二三四,那这个比较好记一些,比较好记一些。 配置好了以后,配置好了以后就点一下它就关了。嗯,首先这个地方 state 需要,需要开启这个服务啊,需要开启这个服务,开启这个服务完以后就是输入这个啊,就是 ceo 啊,然后这个 我这样就跟它对接了,你看吧,我的,我的 h t t p local house, 一 二三四五,对吧?一二三四 api v e chat, 并且你还是可以用这个 open ai com compatible 这样一个呃 协议进行对接,那你 pos 的 请求就是唯一,呃,你,你是 boss, 它自动的会跟你拼接啊,那我这里就用这个客请求和它对接好了,剩下的就是我用客请求去把它塞到呃这个 open core 里面去。那怎么做呢? 也是在这里啊,就是我因为它这个网站啊,它这个网站不像欧拉玛,它自动的里面,呃,跟它做了 open open clone 这样一个对接啊,大家看到上海课就知道这里微软的 i m studio 并没有对这个小龙虾进行做对接,那没有做对接也是没问题的,我们就直接在这个这里去做配置啊。就是我首先是 open clone 是 吧? clone 有 一个叫 daisy board 的 啊,不是 daisy board 的 on board, on board 的 一个 insode 这样一个地方,我重新进行配置啊,重新进行配置的话是 yes 啊,然后 click start, 然后我要更新其中的一个字,这里选选第二或选第一都是可以的,我去更新它,对吧?到了这个地方 一定要选 custom pro i 的, 因为因为你这里没有没有那个 lm studio, 它都是模型在线的。我们是需要 http 请求,这个 http 请求就是呃, local house 的 一二七点一这里,这个地方就是一定是一二三四。 好,这个地方一定是写一二三四。我,我需要把这个呃日字给清掉,待会可以看一下我,我这个 open core 已经会怎么和它连通的哈。如果你这个地方假设我,我写错了,我这个地方假设有个什么 a a 啊,这是瞎写的,他就会报错啊。这个 api key 没关系,因为他我没开通那个,我没有去开健全这个地方我没有去开这个要求健全,所以说这个 api 你 写写不写 api key 都可以的。 这个时候就是 open ai controllable, 和这里是一模一样的,看到吧,哎,回车好, mod id 非常重要,你不能瞎写,这个 mod id 就 在这里,你看把它粘出来就好了。对 啊,他都告诉了你啊,就 local horse 的 一一一一 charnel 就 一二三四啊,这个它比那个小龙虾啊,不是比小龙虾,比那个欧拉玛要做的好啊的地方,就它各个地方都出来,哎,你看, 呃,其实它已经连通了,但是你这边唯一 a a a a, 它应该是唯一,你看到了吗? 所以说他就报错,报到错,对吧?然后这里有个端点 id, 这个端点 id 让他默认给就好了。啊,这个,这个这个名字啊,然后这就是错了,错了的话你就得重新填过,所以说他没有返回的机会,就是我,我现在 就是你只要按 esc 退出重新来过,所以说这里那我快速的演示一遍就是正确的应该怎么做。 yes, click start 第一个, 然后选这个 customwide 的, 哎,这个地方他又默认的,就就写一二三四就好了。呃呃。你说有些人为什么不加 api 呢?你看我这个地方为什么有 api? api 是 它的另外一套这个接口服务啊,是这个, 这里有一个 api 点微,但是一般来说是没有 api 的, 所以说这个就是没问题了,一定是这样子的,微一它后面会自动的跟你加陌陌的啊和那个例子 box 啊,然后这个就回车啊, 一定是要选择这个 openair compatible, 哎,然后这个 mod id 不 能瞎写啊。就是你,你这里,呃用的是什么 mod 就是 用什么 mod, 哎,你如果可以换的,就是在在在在这个地方换啊,就是在这个 my mod 里面,我这里只有一个,你可以选,你可以选 好,然后这个地方我,对了,以后你看,哎,这个地方他就补报错了,全绿了,看到没有,哎,这个地方全绿了,我给他全通了,全通了,那全通了就赶紧去启动一下,那就是 skip, 因为我之前都装了,也不要去装他的 skill 式,也也不需要装他 fuk 式啊, 直接就启动这个网关是吧?因此多领啊, get 位首位,然后让它浏览器打开,那这样就通了,其实它配置起来其实是比那个欧拉玛要简单,为什么呢?这微软还是做的可以的。但是呢,但是呢,这个 open core 竟然和它 内部的就是那个,我感觉它很多没有去做兼容到这一步就已经通了啊,你学会了吗?

43根谷老师 10:41查看AI文稿AI文稿

10:41查看AI文稿AI文稿大家好,我是小木头。在过去两期视频,我们介绍了如何在 clubflair 云端部署 opencloak。 在 视频分享后,有朋友也问到在云端是否只能使用 astropik 所提供的 cloak 模型? 当然不是的,在目前这套部署方案下,市场上主流的模型供应商都能够支持。本期视频我们就以最新发布的国产开元大模型 kimi 二点五为例,我们看看如何在 cloudflair 云端将这款大模型集成到 openclo。 那现在咱们就开始吧。首先咱们对 kimi 二点五模型做一番简单的介绍,这是月之暗面发布的最新款开源多模态大模型,它也用来驱动了 agent swarm 这个新的特性。 关于 agent swarm 感兴趣的朋友呢,可以来了解一下,这是一个用于驱动大规模并发任务执行的执行方式。 当然啦,这并不是我们今天分享的主要话题,那咱们还是回到 opencl 的 集成。在生态中,目前已经有许多的服务厂商提供了二点五模型的支持,比如 openerer。 我 们今天的分享呢,就借 openerer 的 二点五模型。在过去视频分享中,咱们用到了 cloudflair 所提供的 mod worker 这个代码仓库或项目。 这个项目呢,默认当然支持的是 ospec 模型,实际上它也支持到了 open ai。 从文档中可以看到,可以通过 open ai api key 这个 secret 来配置对应的密钥, 从而使用 open ai 的 模型。在今天分享中,我会用到我分叉出来的这个 mod worker 这个项目,在其中做了一些小小的代码改动,从而实现了对 open route 的 支持。 我不确定在原始的代码仓库中是否已经支持了 open router, 如果已经支持了呢?欢迎朋友也在评论区告诉我一声。那现在呢,我就以分叉出来的这个项目为例,演示如何做 open router 的 支持。在文档这里我做了简要的描述, 可以用到 open router api key 这个 secret 来指定 api key。 另一方面呢,可以通过 ai gateway api gateway base url l 这两个 secret。 如果要用这两个密钥,我们需要请用 cloud flair 的 ai gav 这个服务。在演示中呢,我们就用这套方案,那现在我们就操作起来。 在终端这里,我已经完成了 regular 登录。那直接我们就开始今天的配置。首先咱们还是需要配置一个 antropic api key, 这个是在目前这个工具或项目部署中它会用到的。 当然,当我们配置了 ai 给我相关的 api key 和 base 二六 anshropic api key 并不会被用到,它只有在 ai 给我不工作的时候作为一个备选方案会用到。 因此我们首先来设置 anshropic api key, 可以 随便给他一个无效的值吧,我们可以验证一下,在后面的应用中,它应该能够正常工作。 现在他会来创建一个新的 worker, 叫 multiple sandbox。 好 了,接下来我们要做的是首先配置这个 ai 给尾 api key。 这里要配置的就是大家会用到的 open router 的 api key, 我 去创建一个, 创建完成,接下来我们配置 ai 给尾 base 与 r l。 当我们配置 open url 时,需要使用目前我所复制的这个域域, 以 open url 结尾,那中间会需要用到 account id 和 gay 域,这两个值呢,都从 cloud layer dashboard 获取,比如现在来到 cloud layer dashboard, 在 account home 这里, 小点点这里有一个菜单, copy account id, 我 们复制它,粘贴进刚才的域域域。 接下来回到 dashboard, 在 computer and ai 这里,选择 ai gav, 可以 创建一个新的 gav, 给他一个 id, 这个 id 呢就会用到我们所配置的 base 域,而用我已经创建了一个 motoboot, 咱们呢就继续用它。 那现在呢,就可以配置好这么个 url, 我 们将其配置到这个 secret。 大家要注意的是,如果你的 ai gateway 已经起用了 authentication, 那 在这里呢,还要创建一个 os token, 我 们来设置它一下。 tobin 从哪里获得呢?回到 dashboard, 在 这个 ai 界面点击,在右侧点击 create, 创建一个 token, 给它起个名字,比如 openclip, 点击 create api token, 复制这个 api token 粘贴回控制台。 这样呢,咱们就配置好了 ai 给尾相关的密钥。接下来还要配置一系列的 secret, 比如 give token, 我 们复制这一段粘贴过来,通过 open ssl 随机地生成一个字符串,这个串呢用来作为 token。 好了,我们尝试部署。在部署中,同样咱们要启动 docker, 我 使用的客户端呢是 rancher, 大家可以根据自己的偏好来选择。现在咱们运行 npm run deploy 完成部署。部署完成,我们回到文档这里参考一下。接下来还要配置两个 secrets, 一个呢是 team domain, 另一个是 aud。 这两个 secrets 的 配置在上一期的分享中,我们也介绍到了,可以回看上一期视频来了解如何获取这两个值,我们快速的配置一下, 配置完毕,现在呢可以部署,不过我们暂时并不部署完成下一步的配置,这一步呢就是 r two arto bucket, 用于保证 multiple, 也就是 opencloud 的 数据,包括了配置配对的设备以及聊天的历史等等。我个人觉得这个呢还是很方便的一个存储的机制。 同样这部分的配置呢,在上一期的分享中也有介绍,那现在我们快速的就配置一下。第一个是配置 access key id, 我 们简单介绍一下,在刚才的配置后,其实呢已经创建了一个 arduino, 名字就叫 modbot data, 我 们只需要 在右侧在 account details 这里点击 manage, 创建一个 api token, 选择 creator api token 起个名字, 比如 open flow, 选择 object read and write。 应用到指定的 bucket, 我 们选择 multiple data, 这正是刚才在部署中已经创建的。点击 creator api token, 这里会给到我们一系列的值,比如 access key, 这是我们第一个需要的。 第二个是 secret access key, secret access key 同样复制它粘贴进来。最后呢是 cf account id, 这个在刚才配置 base 二 l 的 时候已经介绍了如何获取到这个 account id, 我们粘贴进来,现在呢就完成了又一波的配置,我们来部署一下。部署完成,我们现在呢就点击这里给到我们的 worker staff 这个 u r l。 在 初次访问这个 u r l 的 时候呢,大家应该会看到类似的界面,我们需要输入自己的 email, 获取一个 code 完成验证。在完成了验证后,大家可能会得到一个 invalid token 的 错误,那么我们初次访问的时候呢,需要在这个 url 后面加上问号 token, 等于 提供的值是我们在最开始配置的时候生成的那一长串 token。 因此大家需要回到最初的配置这里获取这个值。复制粘贴进来。 接下来或许会看到目前这一个输出,表示我们需要完成配对。初次配对以后呢,后续就不再需要操作了。 我们来访问一下这个 y l, 它会加载设备,这里会列出目前等待配对的设备,可以选择 approve 或在右上角点击 approve o, 一 次性完成配对后,就可以开始使用在云端运行的 opencl。 现在我们如果再一次访问刚才复制的这个 worker step u r l, 就 能够看到右上角 health ok 表示呢,这个 clawbot, 也就是 open claw 运行正常了,打个招呼吧。 hi, 端到端的通信一切正常。 这里呢加载了一些文字,大家不要惊奇,这个呢,是因为我的 arduino 在 过去已经有过聊天历史的存储,因此呢,它有所加载。 如果我提问 what's a model in use, 大家可以看到这里,它说是 open ledger 所提供的 kimi k two point five。 这样呢,咱们就完成了端到端的集成。 在结束本期视频分享前,我们回到 cloud layer dashboard, 来到 ai gateway。 在 刚才创建的这个 ai gateway 底下,点击 logs, 大家能看到所有的模型调研的情况。这也是使用 ai gateway 一 大好处,我们可以做很好的统计,跟踪, 了解非常详细的模型的使用情况。那感兴趣的朋友可以赶紧来尝试一下。 open ledger 提供了许许多多模型的支持,在目前我所分享的分叉的这个 motwerker 代码仓库中 硬编码的 kimi two point five 这款模型,大家可以在部署中自行地调整期望使用的 open router 的 模型,这样呢,我们就可以非常灵活地切换模型,在云端使用 openclock。 好 了,那今天的分享就先到这里吧,大家在配置和运行中有任何问题呢,也欢迎在评论区给我们留言。那今天的分享就先到这里,感谢大家收看咱们下次视频分享,再见同学们,拜拜!

327五里墩茶社 02:48查看AI文稿AI文稿

02:48查看AI文稿AI文稿在 openclaw 当中,如何免费地使用顶级大模型呢?我们知道 openclaw 本身是比较消耗 talking 的, 原因是在于当你和 openclaw 聊天的时候,它会使用上下文的 talking 调用大模型,从而导致我们使用 openclaw 会消耗大量的 talking。 问题来了,免费的大模型不好用,付费的大模型又用不起,那有没有折中的方案可以让我免费的使用顶级的大模型啊?答案还真有,那么接下来就给大家分享一个价值几千甚至上万的方式,可以让你免费的使用大模型,少花很多钱,所以大家先点赞再观看吧。那么怎么免费用啊?这里呢就给大家去说一下。 我们只需要去 n 平台,然后 n 平台里面是提供了很多顶级的大模型的,而这些大模型都是可以免费去调用的, 大家来看看都有哪些啊?比如说像国内的顶级的 mini max 最新版二点一可以免费的调用,还有像智普的四点七的满血版也可以免费调用。那么像 deep sync, 三点二、 kimi 等模型更不用说了,全部都是免费的。那么我们只需要去 n 平台申请一个 api k, 有 了这个 api k 之后呢,接下来将这个 api k 的 方式使用 open a 的 方式啊,配置到你的龙虾的配置文件里面就行了。 龙虾的配置文件在哪呢?给大家说一下啊。龙虾的配置文件呢,是在当前的用户底下有一个 opencloud 的 文件夹,然后在这个文件夹底下呢,有一个 opencloud 的 json, 然后这时候打开你的 json 啊,因为它内置是不支持这个平台的部署的,所以我们手动去配置它就行了。 手动配置呢,总共有三处地方啊,那么第一个地方呢,就是咱们在 models 供应商里面去添加一个名称,这个名称呢,其实叫啥都无所谓啊,只要后面和咱们的 agent 去对应起来就行了。然后在里面呢, ok, 去写他们家的地址。然后呢,重点这块来了,要去写你的 api k 的 换成你自己的, 用 open ai 的 方式进行调用。然后你调的模型是啥啊?那比如说我这儿呢,就是 mini max 二点一的最新版本。好,然后底下呢进行一个设置啊,这是第一处,先把它进行设置,然后设置完了之后呢,接下来第二处啊,导到你的 agents 里面, 然后将你的 default model 设置成你要调用的模型啊。设置完了之后呢, ok, 在 models 里面同样把这个名称再进行赋值一下就行了。这三个地方全部设置完成之后, ok, 这时候回到咱们的 open cloud 里面,将服务关掉,然后这时候使用命令 open cloud get v 重启你的服务啊。重启完你的服务之后呢,接下来你就可以去问一下你的龙虾你使用的模型到底是啥了。好,那这时候呢,咱们回到龙虾的 使用界面啊,那么咱们去问一下他,我为你设置了新的大模型,告诉我你使用的大模型是啥,咱们来看一下这个大模型 是否是我设置的那个大模型呢?好啊,咱们等待片刻,看到没啊,这就是我设置的 n 公司的 minimax 二点一了,那么到这咱们就可以免费的白嫖顶级的大模型了。我是磊哥,每天分享一个干货内容。

2588磊哥聊AI 09:44查看AI文稿AI文稿

09:44查看AI文稿AI文稿大家好,我是根古,今天是 open core 的 第五堂课啊,这堂课分享一下本地的模型配置教程。那前几次课,呃,我们分享了一下这个 open core 的 两个大坑呃,然后一个环境搭建的一个视频啊,最后还给大家演示了一下如何控制浏览器的一个配置。 呃,这堂课给大家分享一下,如果你你的电脑配置本身是比较强大的,那你就没有必要去用那个消耗那个外部的那个一个收费的托管把本地部署这个模型啊,这篇是欧拉玛篇 啊,欧莱玛是一个管理本地的一个大模型的这样一个程序啊,这是一个程序,其实大家还可能用过其他的,就是微软那个 lm studio。 lm studio 其实也是可以的啊,因为欧莱玛这个和那个 open color 它的兼容性配置会比较好。我给大家演示一下我配置的效果啊,我这里输入一下,你是谁啊?你是用的哪个模型啊? 他用的是这个 gbtos 二十 b 的 这样一个模型啊,也就是我这里配置的欧拉玛的这样一个。这个这个啊,呃,首先我给大家介绍一下怎么样可配置啊,前提是你已经装好了 open clone, 如果大家不不知道如何去配置 open clone 的 话,可以看我前面的前两次的视频。那首先你要打开这个欧拉玛点 com 点那么空的话,你先当漏了这个,这里会有三个版本,那你你如果是 windows 和 os, 苹果 os 都可以选择啊,建议大家是用 windows 或者是用 mac os 都可以的。然后你把它下下来了以后 直接就装好了,装好了它会进入一个这样的页面,这个页面本身没有啥,就是他进来的时候这里是没有模型的,你需要选一下。这个就是我,我本地已经下载了两个模型,一个是千万三的八 b, 一个是这个 gbt 的 o s 的 二十 b, 如果你要下其他的,直接点下载这个,呃,参数越大的就是一百二十 b, 我 估计我的电脑也跑不了。建议大家一般选八 b 的 或者二十 b 的 就好了。嗯,然后你你点击下载它就会,它就会进入漫长的下载啊,这一段,呃,可能需要魔法上网。 你好啊,这样就已经通了是吧?这已经通了,通了以后,实际上,实际上他是把那个模型下到你本地啊,通过欧拉玛进行管理,实际上他就是一个面向开发者的一个管理啊。这里你看把它翻到下面呢,就是再回回,回过头来翻到下面呢,你看这里有一个,呃,超过四千四万个应用都能够对接,你看这个就有一个 open code 啊, 你看一把 open cologne, 已经对对接了,你打开这个,哎,他告诉了你前两个是你没装 open cologne 的, 这两两步已经是,呃,前两堂课已经装了,是吧?然后,然后假设你已经跑通了,但是呢,我用的是可能是紧密来模型,那我应该怎么配置呢? 其实也不难了,第一步,第一步不是要去启动这个,第一步是要你在这里去进行配置他,他这个欧拉玛 launch open color 就 相当于是 open color, 呃, start gateway 啊,启动网关。所以说如果你本身已经运行了 open color 了,用那个线上的,你应该把它这个关掉。这里我有一些这个教程啊,就是 把它先杀死掉啊,就是他抽风的时候把它杀死掉。这个 kill 这个所有的进程也可以啊,就是把它全杀了,我就给他演示一下, 打开一个新的命令行窗口,你把它 open call 杀掉,杀掉的话,他他其实,哎,他就访问不了了。看到了,访问不了了以后你就去呃,就是运运,运行这一行啊, 运行这一行,当然你现在还没有配置,所以说是不行的。第一步就是你应该先下载模型,下载模型以后,这里通了以后,说明本地的模型和欧拉玛已经呃他,他已经管理好了这个模型,管理好了模型就应该去呃去,这样做,这样做, 就这样子,你先把这个 open 呃欧拉玛这样一个服务骑起来,骑起来了以后,呃,就可以,幺二七点零点零幺二八,就这里就可以。呃, 在这网页这个窗口进行配置啊,就可以不用命令行,如果你对命令行很熟的话,其实可以用。呃,可以,可以用,我前堂课跟你分享的那个,就是 openclo 这样一个 on board 的 这个 excel, 这个是可以配置的,但是最好能够。哎,这个地方它有个配置选项,一个 config, 这个咖啡啊,咖啡里面你选到一个模型,这个 model 式, model 式, model 式里面有个 prologue 字, prologue 字的时候,这里面,哎,这里面你,你开始是空的,你这里随便取个名字都无所谓啊。这个这个欧莱玛你随便取的都可以。这里的话它是兼容 open ai 的 一个 compilers, 一定要选这个, 这个 ai key 你 不要去呃,随便选都可以啊,为什么呢?因为你这个欧莱玛这里是没有这个教验的,那就是这个欧莱玛这个 set 里面 来打开这个地方,就是欧拉玛一个三体里面,你可以,你是把它关掉了,就是这个,这个选项一一个是 pos, 欧拉玛 to like work, 需要把它打开啊,需要把它打开, 这个地方是不需要学 api key 交易的,因为你是本地模型了,你随便输都可以的啊。所以说这个地方把它打开,这个地方最关键的地方来了,呃,这个幺二七点一点一四三就可以随便选了, 其他地方可以随便选这个地方,呃,这个点 a p s 也也也需要这样,对,然后 max 头肯,其他的都我觉得无所谓,这个地方空着也行,你你把它设置一个很大的字也行。 呃,还有一个最最关键的,就这个 id, mod id, 这个 mod id 就是 一定是要在这里,我,我知道了,这个地方看,就是如果你找不到这个配置文件,应该从这里看,他有个 com figure 文件,也就是这个地方,这个地方,呃,这个 它有一个这个欧拉玛的配置选项,这个,呃,去配置这个登录像,它有个这个就是你,你下了,比如说我下了两个模型,然后你应该管理模型的时候,你应该哎这个啊, 然后把这个复制一下,欧拉玛 launch 是 吧?欧拉玛 launch, 这个,这个,这个很重要,因为你看这里面是我本地选择的,这个 x 就是 我默认的是,就是 jptos, 或者我这里下了这个,如果你下了其他的,他会在这里列出来。这里还有 glm 四点七 flash 是 吧?千万八币是吧?我选择的是这个,因为这个还是比较好用的,所以说选择了以后你就把这个复制出来, 复复制出来过就好了。好,然后这个地方把它复制出来,把它粘过来。如果你是选择别的模型,就是塞别的模型,这里有个小小的坑呢。他这个地方推荐的模型有这些千文山扣的 glm 四点七, gptos 二点零二二二十 b。 对, 如果你选的是别的模型,我试过他不知道为什么连不上啊,这就是他一个巨大的坑。这里这里有一个,你看这个是可以用的,然后还有一个千万三的扣的,这个也是可以用。这有个扣的三十 b 也是可以用的。还有一个清华紫光的。那他这里竟然没有啊。这里没有,这里没有, 所以说这这也是他一个做的不好的地方啊。就是就是,除了这几个,我想用别的,我不知道为什么会出出错啊。会出错,可能是他的一个 bug 吧。 然后配置好了以后,配置好了以后你再往下翻呢。这这个地方 test 的 和 emoji 一定要是选 test, 我 们这里没有 emoji 啊。那最后这个这个名字可以随便取啊,这念你也可以跟他取的 id 一 样的。那完了以后就 save, save 了以后刷新一下, 刷新一下就点 check, 然后再你又再再另一个筛选呢,你说你好随随便输入,他如果有反应呢?那就是配置成功了,当然这个地方你还需要重新启动一下,你看这个地方他需要重重启一下。呃,就配置完了以后这个地方需要重启,也就是这个地方你配置完了应该再给浪去一下。 我试试看浪去一下。哎,奇怪,这个复制一下, 那如果出现了这种卡死的情况啊。啊,这已经好了,对吧?嗨,这个我我帮助你,但你你会,请和我就是用中文,用中文,和我用中文与我沟通。您是谁 啊?他肯定是我是欧巴马,是吧?这样一个 gpt 啊,这是 open call 的 助手啊,您是用的这个 gpt? 看,我是用的欧巴马的这样一个 这个 gpt。 还有一种情况就是有 bug, 就是 你这个配置文件,我无论怎么改,改不动了,怎么办呢?然后呢?有办法,就是他的有一个配置文件,这个配置文件是这个玩意,这个配置文件的路径就是在这个呃,加目录下的点 open, 也就是他的路径,这里也也是一个坑啊。但是一般来说你是不需要走到这里的, 就这个这个路径是在你的加目录,比如说你 cd 加目录,加目录下的有一个点啊,点 open 这样一个,这是他所有的配置文件, 这里面的这一个玩意儿就是 open curl json 格式,那这些是它的备份,不用管,这个就是它的一个配置文件,你所有的配置文件都是想改这个 json, 那 你把它这个 打开来,用 v s code 打开来,你可以看到第一行就是 ajax, 这里就是之前讲的主力模型,你主力模型塞的是 jimi 二点五 flag, 那 就是主力模型,这个它自动的就能够连到这个这个外网,是吧? api 进行调用。如果你把它 改成这个欧拉玛,这个本地的,那就是本地的。如果你是微软的 lm studio, 微软 lm studio 它也可以。然后这里非常重要,非常重要,在这个地方它有一个叫模型管理,这个模型管理非常重要,你刚刚加一个这个欧拉玛,它就会出现一个这样一个, 呃,节省的这样一个很大的这样一个对象,你去改它这个地方非常重要,就是 http, 幺幺四三四零号,你,你这里就应该是改,你也可以改这个端口, 看这个端端口其他的就没有啥了,其他就没有啥了。那就如果这个幺幺四三四被占用了,你可以看这个这个端口是不是被占用了,也可以这么看,就你像占不占用,哎,他占用的,他占用的,他这里都是欧拉玛,也就是他是用的幺幺四三四,幺幺四三四,所以说你这个端口就是用幺幺四三四。 然后其实大家还是要经常去摸索的,因为这个里面,呃,他的配置像啊,和那个那个欧拉玛这个这个对接啊,这个流程并不是非常好用,因为他也没有哪里进行跟你先调试啊,就是只能在这个窗口进行调试,那最重要的就是这个配置像,如果大家配置像这里玩明白了, 也不需要去这里去改这个地方。呃,所以说这堂课就分享到这里,你学会了吗?

66根谷老师 12:43查看AI文稿AI文稿

12:43查看AI文稿AI文稿大家好,我是兔兔,欢迎来到我的频道,真的是好久不见,差不多一周的时间了,我都没有发视频,因为 上个星期我就在家研究 open call, 都没怎么出门。这个时间呢,说长不长,但是 也不算很短了哈,要问我在这个过程中有什么进展,有什么发现?我想先分享一个截止目前为止 最大的感受。我好像终于理解什么叫技术超能力了,作为一个完全不会写代码的普通人,现在我可以让 ai 来帮我写程序,部署服务、调试硬件,甚至操控远程设备。 而以前一些脑中的奇奇怪怪的想法也有落地的可能了,真的是一个一个做出来了,最夸张的是,他已经从软件层过渡到了物理层。 我知道这么说有点虚,有点玄乎,但这确确实实是我最近一段时间来的一个真实的感受。那么在具体分享我用 oppo cloud 做了什么之前,我想简单的分享一下我在这上面投入的硬件软件的成本。 先讲一讲硬件成本,我在分享初次体验 opencloud 那 期视频当中就有提到过,我在去年底其实就买了一台六十四 g 版本的 mac mini 四 pro, 当时本来就是想拿来跑一些本地大模型研究研究 ai, 然 那阵子呢,处于超级新手期,都还在想怎么样去利用好这台设备,结果没过多久, overclock 就 出来了,这个真的就是巧了哈,硬件层面来讲就属于遥遥领先了。 那这个 overclock 其实已经经历过三次更名了,问世的时候真的是超火爆,很多人就到底用什么设备去装,也是掀起了不少的讨论, 都说可以不用 mac mini, 用其他的设备,那我呢,刚好手上有一台,最开始就用的是 mac mini 嘛。然后在过去一周呢,我其实也尝试过用三种不同类型的设备都去试装体验了一下。 首先我试了用 zmar broad, 它的系统是 zmar o s, 能不能装?当然能,它的应用市场都自带了,更新的非常快,我就试了一下,结果发现这种被动散热的设计呢,就会导致它在运行的时候 非常烫。其实目前呢,清迈还处于没有到夏季最热的时候,但是我感受到那个机器烫的程度到什么程度,可以煎蛋了。我很担心长期这个样子使用,所以这种散热压力就会导致在运行 open club 就 有一点卡卡的。 其次是我的一台小主机,华硕 n u c 十四 pro, 那 这台小主机的硬件性能是很强的,跑起来是绰绰有余,但是呢,我是把它放在国内的,是远程控制的这么一种状态, 结果就遇到了网络环境的问题,在调试方面呢,挺麻烦的。后来呢,家人还跟我反馈说这台机器他的风噪声很大,就呼呼作响吧。然后我在网上也没有搜到很好的那种散热配件, 所以目前呢,就是一种因为网络因为风扇使用不畅的一种状况。 最后是十三寸的 macbook pro i 五的 cpu, 这是我的第一台 macbook pro, 大 概七年前买的吧,就一直舍不得出掉,留作备用了。 它的架构其实和 mac mini 已经完全不同了,性能放今天来讲也属于比较差了,跑 open cloud 可以, 但是相同的 cloud 的 模型,我就发现它这个反应速度确实要慢很多,然后在高负荷的情况下呢,风扇噪音也是明显很多,不过还是可以用的。 那其实我用的三种不同形态的设备都可以装,所以我也意识到 openclaw 它对硬件没有那么挑,要求没有那么高,但是如果有性能更强的 cpu, 更大的内存支持, 那么在运行上来讲就会更加的流畅,更加的高效。好像有点在说废话嘞, 那说完硬件层面,我还想小小的补充一下,就是我基于语音输入和识别去购买了两个小配件,一个是麦克风,还有一个是快捷键键盘。麦克风也是看别人推荐的,效果还行, 之前长期跟 ai 对 话,我就发现我打字的速度跟不上,会降低效率,然后我就开始用语音输入的内置的麦克风, 但是周边环境的噪音多一点的话,会影响识别的精准度,而且因为有一段距离,所以我的声音会需要比较大,说久了之后嗓子有点疼。 后来我就用了这种放在嘴边的麦克风,识别效果有一点点提升。当然我觉得这个也不是最关键的,还是要配合语音输入法和 ai 校准这个样子呢。出来的大段文本准确率是比较高了的,因为我有的时候说我可能 口述的时候会有重复的习惯啊,或者有一些口语化的表达,那这样一套组合下来,其实识别的准确率真的就很高,我基本上不用改的。 而快捷键机械键盘的作用非常简单,主要是想减少高频操作情况下对笔记本键盘的损耗,然后就试了一下,还可以,手感还不错。 还有就是买了 esp 三二设备,这个设备挺有意思的,但是在这里我要先卖个小关子,因为之后分享我用 openclaw 做了什么的时候,我就会重点分享一下它, 再来聊一聊软件方面的投入,也就是各大 ai 的 订阅。其实在这个方面我算了一下,这个支出还挺大的, 就是三家我都有在用。关于这三个 ai, 简单说一说截止目前为止我的一个使用感受。 club 的, 我最早用的是二十美金的那一档,然后上个月不是做了一个升了吗项目吗?当时就触发限额了,我一咬牙,升级升级成了一百元那一档, 就想着说之后肯定很够用了,结果没想到我要制作炒股的一个项目的时候呢, 又触发限额了,这个托肯真的很贵啊。所以我也在 open cloud 上面做了一些优化,比如把一些不太重要的工作丢给其他的便宜模型,比如我把项链模型部署到本地,再比如定期重置对话,以及设置 cloud 的 上限。其实截止目前为止,我的主力 ai 就是 cloud 的。 可能视频前朋友会有一个小小的疑问,市面上那么多 ai 还有平替的,你为什么就选 cloud 的 呢? 我觉得可能是使用习惯,一开始我的工具制作还有一些小开发都是用的它,而且随着我投入使用的比例的增加, 我发现它收集我更多数据之后,好像比其他 ai 确实更懂我一点,更能 get 到我说的意思。所以目前呢,属于一种比较依赖的状态。当然后续如果有比较好的平替,我是二十美金的那一档, 但说实话,最近我的使用率真的是降低了很多,所以一度我都想要去把它停掉了,但是又觉得在泰国这边,在手机端 app 使用的时候,它的通话和语音 响应速度比较快,体验是比较好的,所以这一点呢,让我至今都有点犹豫。但是如果一定要去砍我的 ai 订阅之初,我第一个应该会选择把它刷下去, 然后是积木莱,目前也是 pro 版,之前打折的时候我就直接年付了这个积木莱用下来呢,我真的觉得它是目前所有 ai 当中 性价比很高很高的了,就是它既可以编程,又可以处理长文,还可以升图。目前来讲,我其实对它的各项表现还是比较满意的,但它有点挑 ip, 偶尔连接不上。 而国产大魔星我当然也用过,之前 deepsea 出来的时候我就想要体验一下嘛,充了一百多,结果用了好久好久,现在都还有六十多。以及我上周体验的 kimi, 我 就当时看很多人都说它挺好用的,所以就充了一个 kimi co 的 七天乐, 差不多五块钱,超级便宜的,就想着说短时间作为编程助手来体验,看一看表现还是不错的。但是七天时间一到,他就要强制给我升级成四十五块钱包月的套餐了, 他问都不问我洗得好,我最后一刻发现了停止了,真的是有点迷哈这操作。目前我的 ai 订阅就是这些了,这个开销其实不低,可能就是学习的成本,学习的代价了。只能说期待未来 ai 越来越普及,关于 ai 的 基建、算力都有所提升之后,它的价格就能够降下来。所以呢,我现在为了对得起投入的这个学习成本,我给自己定了一个小目标,每天至少要用百分之八十的量, 如果当天我的用量没有达到,那就是我对于 ai 的 研究开发还不够。除了订阅,我还买断了 mac whisper 这个软件, 因为这个软件它支持设置本地的模型来进行校对,所以现在我的语音识别和校对都是本地的,体验很不错,安全性也挺高的,识别速度真的挺快的。因为现在放了个话筒在嘴边,所以我给俩洗碗都不可以,就可以一直叽里呱啦的说个不停。 手机上暂时用的 tablets, 一个月内是免费体验之后就要付费了。它的输入准确率是非常不错的,接近于手打了,但是我始终不太喜欢它后台常驻的这种方式。还有就是我想要 减少一些在 ai 软件方面的支出,所以呢,我就用 ai 去做了一个山寨版的,虽然说体验没有这个 typeface 好, 用时也更长,但是免费啊。 那么总体算下来,硬件和软件的投入确实不少,但还是那句话嘛,对我个人而言,我认为它是我的一个必要的学习支出。 那其实也有很多比较精深的方案,就比如说硬件层面完全可以去买 mac mini 的 基础款,比如说订阅, ai 的 订阅也可以去找一些平替,甚至现在也有一些免费的方案都可以,对吧? 只是说这个呢,就看个人的选择需要跟喜好嘛。那我现阶段并不是说因为投入了这么多,所以我要取得一个很及时的现金回报, 而是我想要去学习,想要去学会这一个技能,就是我觉得目前还处于一种会,但是也没有说用的很好的这么一个程度, 所以接下来呢,短期需要功课的目标就是真正的把它用到位之后再说,完完全全的掌握, 毕竟这对于我们所有人而言呢,其实都还是一项比较陌生的技能,而且现在 ai 的 门槛确实也是越来越低了嘛,未来我相信这个 学习的难度也会越来越低,整个花费也会越来越小的。对了,还想分享一个之前发生在我身上的糗事,就是我放心的让 open class 去同步我的视频到我的群里边儿,结果 我可能没弄好吗?肯定是没弄好,他一晚上推送了几十次,而我睡着了, 后来都是群友来提醒我的尴尬。所以想说的是,在享受 ai 带来便利的同时, 我们也要对一些基础的技术有所了解,就是不必要成为大佬,也不必要成为这方面的专家。但是呢,也不能纯做甩手掌柜,多一点了解,在用 ai 的 时候就会更加的安心,也就更能去防范一些安全风险,技术问题。 ok, 那 么本期的分享呢,就到这里,欢迎视频前的朋友在评论区留言讨论,大家相互交流,看看我们下期见。

873TuTu生活志